Deepfakes – realistische, von KI generierte Audio-, Video- oder Bilddateien, die das Abbild einer Person nachbilden können – sind eine der dringlichsten Herausforderungen, die die generative KI mit sich bringt, da sie von böswilligen Akteuren genutzt werden kann, um die Demokratie zu untergraben, Künstler und Darsteller auszubeuten und normale Menschen zu belästigen und zu schädigen.

In diesem Moment sind sowohl technische als auch rechtliche Lösungen gefragt. Aus diesem Grund hat IBM den Tech Accord to Combat Deceptive Use of AI in 2024 Elections (Munich Tech Accord) unterzeichnet und sich damit verpflichtet, die Risiken des Einsatzes von KI zur Täuschung der Öffentlichkeit und zur Untergrabung von Wahlen zu mindern. Das ist auch der Grund, warum IBM seit langem für Regelungen eintritt, die genau auf schädliche Anwendungen von Technologie abzielen.

Im Folgenden stellen wir drei wichtige Prioritäten für politische Entscheidungsträger vor, um den Schaden von Deepfakes zu mindern:

- Schutz von Wahlen,

- Schutz von Urhebern, und

- Schutz der Privatsphäre der Menschen

Schutz von Wahlen

Die Demokratie hängt davon ab, dass die Bevölkerung in der Lage ist, an freien und fairen Wahlen teilzunehmen. Leider können böswillige Akteure Deepfakes verwenden, um sich als Amtsträger und Kandidaten auszugeben und die Wähler auf verschiedene Weise zu täuschen, wodurch dieser wichtige Grundsatz untergraben wird. So könnten Deepfakes die Wähler beispielsweise darüber täuschen, wo, wann und wie sie wählen können, oder einen Kandidaten fälschlicherweise so darstellen, dass er kontroverse Aussagen macht oder sich an skandalösen Aktivitäten beteiligt.

Die politischen Entscheidungsträger sollten die Verbreitung materiell irreführender Deepfake-Inhalte im Zusammenhang mit Wahlen verbieten. Der von den Senatoren Klobuchar, Hawley, Coons und Collins eingebrachte „Protect Elections from Deceptive AI Act“ würde beispielsweise die Verwendung von KI zur Erzeugung irreführender Inhalte einschränken, die Bundeskandidaten in politischen Werbespots mit der Absicht der Wahlbeeinflussung falsch darstellen. Andere politische Ansätze könnten es Kandidaten, die von irreführenden KI-Inhalten in politischen Anzeigen oder Spendenkampagnen betroffen sind, ermöglichen, Schadenersatz zu fordern oder irreführende Inhalte zu entfernen, während gleichzeitig der Schutz der Meinungsfreiheit gewahrt bleibt.

In der EU hat IBM den Digital Services Act unterstützt, der großen Internetplattformen bestimmte Verpflichtungen hinsichtlich der Moderation von Online-Inhalten auferlegt. In den kürzlich von der Europäischen Kommission veröffentlichten Leitlinien wurden außerdem zusätzliche Anforderungen für verbrauchernahe Plattformen vorgeschlagen, um „systemische Risiken für Wahlprozesse“ zu mindern.

Schutz von Urhebern

Musiker, Künstler, Schauspieler und Kreative aller Art setzen ihre Talente und ihr Abbild ein, um die Kultur zu gestalten, zu inspirieren, zu unterhalten und ihren Lebensunterhalt zu verdienen. Deepfakes können es böswilligen Akteuren ermöglichen, das Bildnis von Urhebern auszunutzen, um irreführende Werbung zu schalten, Verbraucher zu betrügen und in die Irre zu führen, die Möglichkeiten von Urhebern, von ihren Talenten zu profitieren, unzulässig einzuschränken und vieles mehr.

Die politischen Entscheidungsträger sollten Personen zur Verantwortung ziehen, die unerlaubte Deepfakes von Darbietungen von Urhebern produzieren, und Plattformen zur Rechenschaft ziehen, wenn sie wissentlich solche unerlaubten Inhalte verbreiten. In einigen Ländern gibt es bereits so genannte „Bildnisgesetze“, die die unbefugte Nutzung des Bildes einer Person zu kommerziellen Zwecken verbieten. Diese Gesetze können jedoch uneinheitlich sein, und nur wenige decken ausdrücklich digitale Nachbildungen oder die Rechte zur Nutzung des Bildes einer Person nach deren Tod ab. Angesichts dieser Unstimmigkeiten in der Rechtsprechung unterstützt IBM den NO FAKES Act in den USA, der auf Bundesebene einen Schutz für Personen schaffen würde, deren Stimmen und/oder Bildnisse von Dritten ohne deren Zustimmung erzeugt werden.

Schutz der Privatsphäre der Menschen

Bereits heute werden Menschen durch Deepfakes auf höchst bedenkliche Weise geschädigt, insbesondere durch bösartige Akteure, die ihr Abbild für die Erstellung von Pornografie ohne Einwilligung verwenden. Dieser Missbrauch zielt in erster Linie auf Frauen ab, zu den Opfern gehören auch Minderjährige, und könnte weiteren Missbrauch und Erpressung durch bösartige Akteure ermöglichen. Der nicht einvernehmliche Austausch intimer Bilder, auch bekannt als Rachepornografie, nimmt mit der Verwendung von Deepfakes zu, ist aber letztlich kein neues Problem. Doch nur wenige der bestehenden Gesetze ziehen böswillige Akteure für die Weitergabe oder die Androhung der Weitergabe dieses Materials angemessen zur Rechenschaft, und auch KI-generierte Inhalte werden nicht unbedingt erfasst.

Die politischen Entscheidungsträger sollten eine strenge straf- und zivilrechtliche Haftung für Personen vorsehen, die nicht einvernehmlich intime audiovisuelle Inhalte, einschließlich KI-generierter Inhalte, verbreiten, sowie für Personen, die damit drohen. Die Strafen sollten besonders streng sein, wenn das Opfer minderjährig ist. Die Gesetzgeber können dieser Empfehlung jetzt nachkommen, indem sie den überparteilichen Preventing Deepfakes of Intimate Images Act in den USA unterstützen und verabschieden. Dieser Gesetzentwurf würde eine Haftung für Personen schaffen, die eine nicht einvernehmliche intime digitale Darstellung einer Person, einschließlich KI-generierter Inhalte, veröffentlichen oder damit drohen, und es den Betroffenen ermöglichen, Schadenersatz zu fordern. Diese Gesetzgebung würde eine dringend benötigte bundesweite Grundlage für die Rechenschaftspflicht schaffen, die in verschiedenen Racheporno-Gesetzen auf bundesstaatlicher Ebene uneinheitlich geregelt ist, und den Opfern und Einzelpersonen in den Vereinigten Staaten mehr Schutz bieten.

Der EU AI Act – den IBM seit langem unterstützt – befasst sich bereits mit vielen dieser Probleme, indem er Deepfakes im Allgemeinen abdeckt und Transparenzanforderungen auferlegt, die klarstellen, wann bestimmte Inhalte nicht authentisch sind. Während die politischen Entscheidungsträger in den kommenden Monaten auf die Umsetzung des Gesetzes hinarbeiten, sollte besonderes Augenmerk darauf gelegt werden, dass Einzelpersonen vor nicht einwilligungsfähigen intimen audiovisuellen Inhalten geschützt werden.

Schlussfolgerung

Die Lösung der Probleme, die durch Deepfakes entstehen, erfordert durchdachte, gesamtgesellschaftliche Ansätze, die sowohl rechtliche als auch technologische Veränderungen nutzen. Technologieunternehmen stehen in der Verantwortung, technische und Governance-Lösungen zu verfolgen, die sich mit KI-generierten Inhalten befassen, wie sie in der Münchner Vereinbarung, den freiwilligen KI-Verpflichtungen des Weißen Hauses und dem kanadischen freiwilligen Verhaltenskodex für die verantwortungsvolle Entwicklung und Verwaltung fortgeschrittener generativer KI-Systeme formuliert sind.

IBM ermutigt die politischen Entscheidungsträger, diese Gelegenheit zu ergreifen, um drei der wichtigsten schädlichen Anwendungen von Deepfakes schnell zu bekämpfen und sicherzustellen, dass KI eine positive Kraft für die globale Wirtschaft und Gesellschaft bleibt.

By Christina Montgomery, Chief Privacy & Trust Officer, IBM and Joshua New, Senior Fellow, IBM Policy Lab

Fachartikel

Studien

Drei Viertel aller DACH-Unternehmen haben jetzt CISOs – nur wird diese Rolle oft noch missverstanden

AI-Security-Report 2024 verdeutlicht: Deutsche Unternehmen sind mit Cybersecurity-Markt überfordert

Cloud-Transformation & GRC: Die Wolkendecke wird zur Superzelle

Threat Report: Anstieg der Ransomware-Vorfälle durch ERP-Kompromittierung um 400 %

Studie zu PKI und Post-Quanten-Kryptographie verdeutlicht wachsenden Bedarf an digitalem Vertrauen bei DACH-Organisationen

Whitepaper

Unter4Ohren

Datenklassifizierung: Sicherheit, Konformität und Kontrolle

Die Rolle der KI in der IT-Sicherheit

CrowdStrike Global Threat Report 2024 – Einblicke in die aktuelle Bedrohungslandschaft

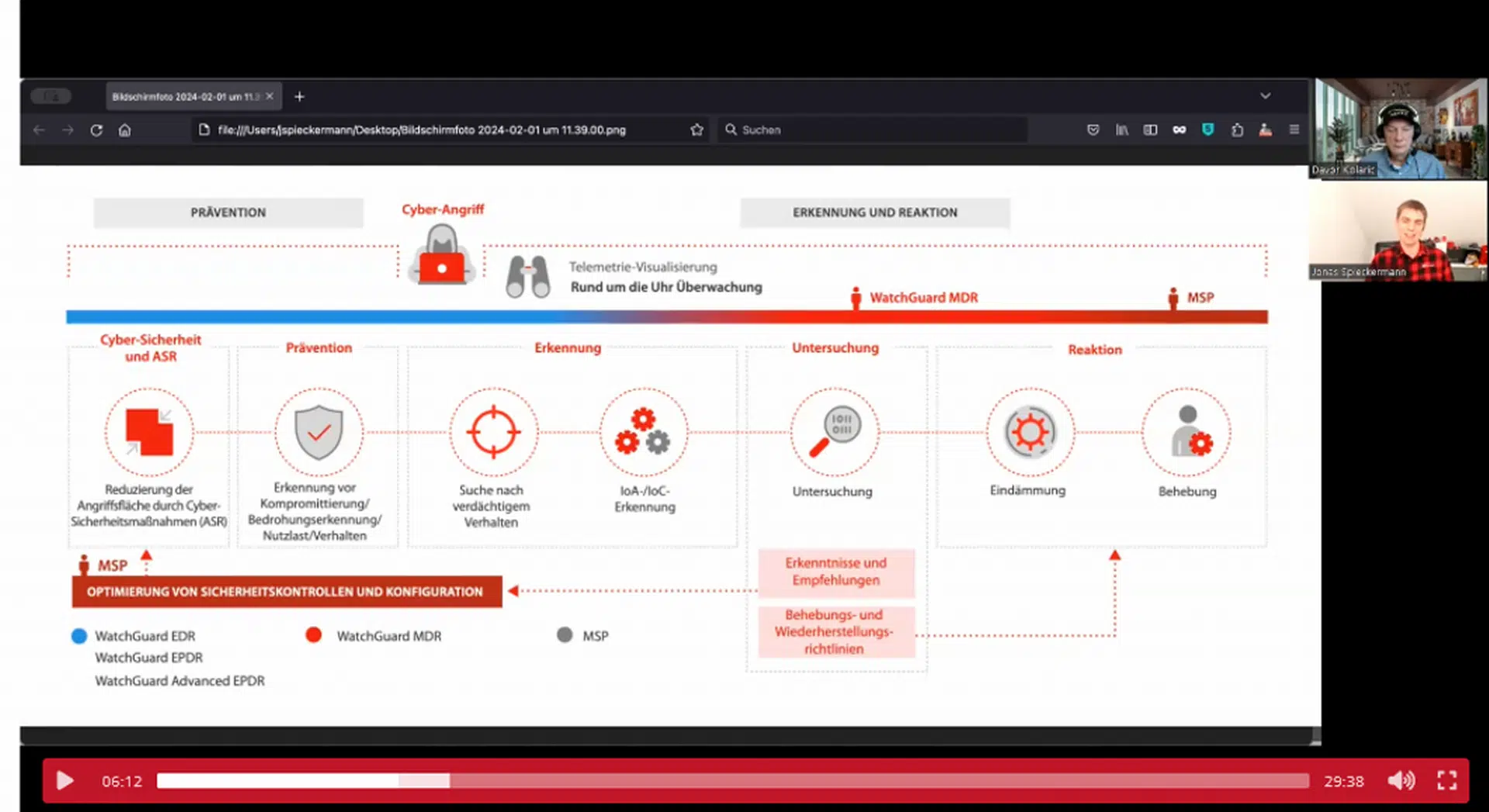

WatchGuard Managed Detection & Response – Erkennung und Reaktion rund um die Uhr ohne Mehraufwand