Mit dem Aufkommen von generativen KI-Modellen hat sich die Bedrohungslandschaft drastisch verändert. Seit dem 22. Juli 2023 kursiert beispielsweise das Darknet-Programm FraudGPT in Telegram-Kanälen. Es ist davon auszugehen, dass der Anbieter die Software über einen Telegram-Kanal vertreibt, um seine Dienste nahtlos und ohne die Probleme von Exit-Scams auf Dark-Web-Marktplätzen anbieten zu können.

Eine neue Studie von Netenrich enthält erste Erkenntnisse über FraudGPT, die bei der Untersuchung potenzieller Gefahren für Sicherheitssysteme helfen sollen. Nach Ansicht des Forschungsteams kann FraudGPT vertrauenswürdige E-Mails verfassen, die den Empfänger dazu verleiten, auf bösartige Links zu klicken. Diese Raffinesse spielt eine entscheidende Rolle bei Phishing-Kampagnen, die Unternehmen per E-Mail kompromittieren (BEC).

Wie wir wissen, ist von KI generierter Code fehleranfällig und es gibt noch nicht viele schlüssige Untersuchungen darüber, ob GPT-generierte Phishing-Köder effektiver sind als von Menschen erstellte.

Es ist deshalb zum aktuellen Zeitpunkt anzuzweifeln, dass Angriffe durch FraudGPT gefährlicher und schneller sind als herkömmliche Phishing-Attacken. Noch scheint hier viel Wirbel um wenig tatsächliche Neuerungen gemacht zu werden. Dadurch soll das Interesse potenzieller Käufer an LLM-basierten Angreifer-Tools geweckt werden, damit sie viel Geld für die Software bezahlen.

Dies könnte also ein weiterer Exit-Betrug sein. Auch Kriminelle wissen, wie man sich vermarktet, sodass jede technologische Neuigkeit für Aufregung sorgt und andere Kriminelle zum Mitmachen verleitet. Unternehmen sollten jedoch weiterhin auf die verantwortungsvolle Erfüllung ihrer Sorgfaltspflicht konzentrieren und folgende Maßnahmen nicht vernachlässigen: Bedrohungsjagd und Überwachung mit Hilfe von IOCs, die dieser neue Akteur verwenden könnte. Außerdem sind strenge Sicherheitskontrollen (E-Mail, Web, Endpunkt), MFA und geringstmögliche Privilegien sowie Benutzerschulungen nötig.

FraudGPT erlaubt es Möchtegern-Betrügern anders als ChatGPT, KI-Tools ohne Missbrauchsfilter zu benutzen. Das bedeutet, dass fast alles erlaubt ist, da die Aktivitäten nicht überprüft werden. Dies erleichtert die Benutzung für unerfahrene Cyberkriminelle, da sie nicht zuerst etwaige Sicherheitsbarrieren umgehen müssen. Im Grunde sind die Angriffe jedoch die gleichen, FraudGPT ist nur eine andere Art, sie einfacher auszuführen. Ein Beispiel dafür ist BEC: Was auch immer jetzt zur Abwehr von BEC unternommen wird – Schulungen, E-Mail-Sicherheit, Kontrollen beim Zahlungsverkehr – wird immer noch dasselbe sein. Das einzige, was sich ändern wird: Überzeugenderer Inhalt und korrekte Grammatik bei den Phishing-Mails.

Besuchen Sie www.tanium.com

von Melissa Bischoping, Director Endpoint Security Research bei Tanium

Fachartikel

Studien

Drei Viertel aller DACH-Unternehmen haben jetzt CISOs – nur wird diese Rolle oft noch missverstanden

AI-Security-Report 2024 verdeutlicht: Deutsche Unternehmen sind mit Cybersecurity-Markt überfordert

Cloud-Transformation & GRC: Die Wolkendecke wird zur Superzelle

Threat Report: Anstieg der Ransomware-Vorfälle durch ERP-Kompromittierung um 400 %

Studie zu PKI und Post-Quanten-Kryptographie verdeutlicht wachsenden Bedarf an digitalem Vertrauen bei DACH-Organisationen

Whitepaper

Unter4Ohren

Datenklassifizierung: Sicherheit, Konformität und Kontrolle

Die Rolle der KI in der IT-Sicherheit

CrowdStrike Global Threat Report 2024 – Einblicke in die aktuelle Bedrohungslandschaft

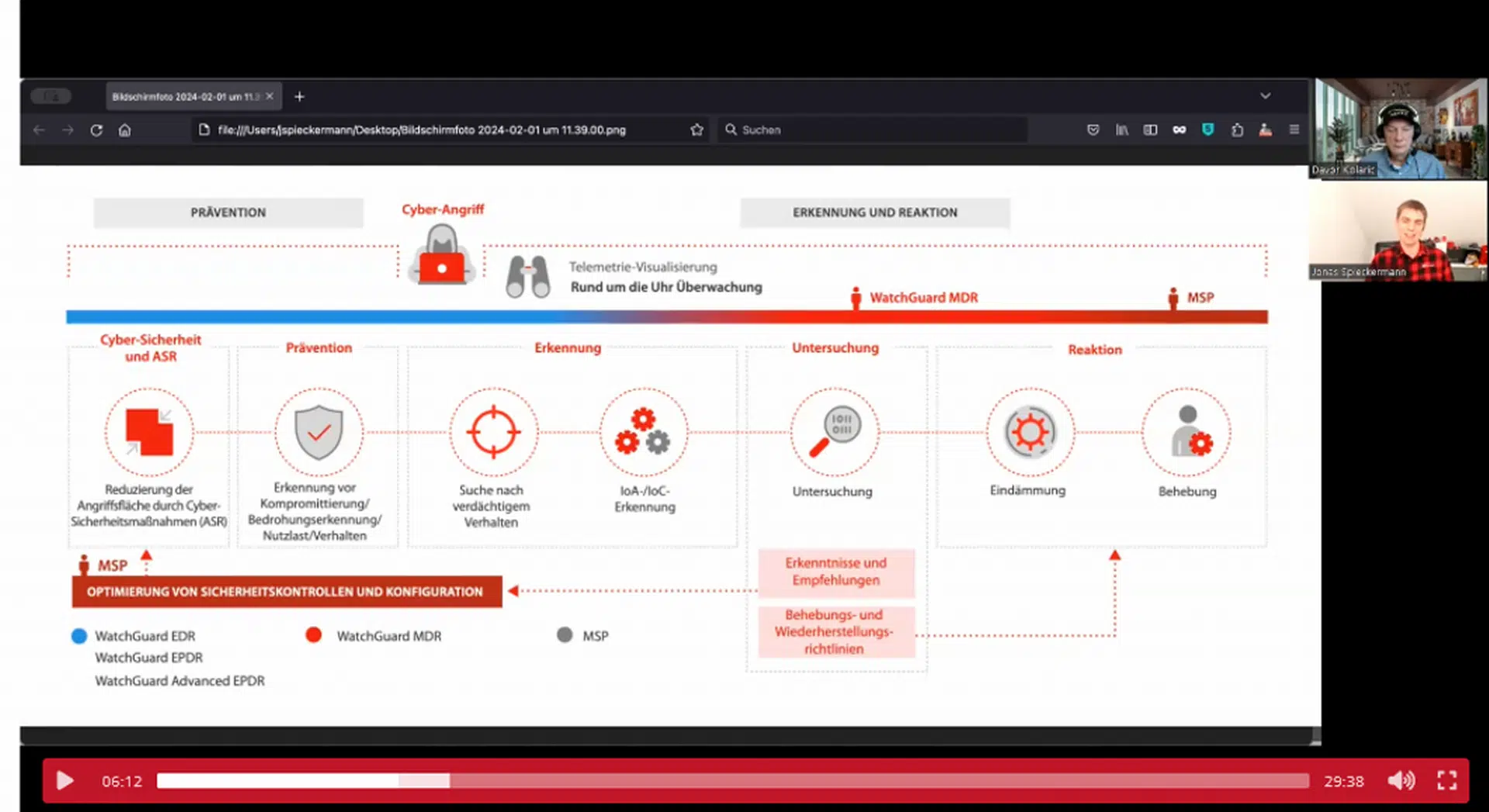

WatchGuard Managed Detection & Response – Erkennung und Reaktion rund um die Uhr ohne Mehraufwand