Immer wieder wird über neue Meilensteine der Entwicklung von Quantenrechnern berichtet. Sie werden immer leistungsfähiger und zuverlässiger und werden irgendwann auch den Weg aus den Laboratorien in den praktischen Einsatz antreten. Forscher versprechen sich davon Fortschritte in vielen Bereichen unter anderem im Bereich der Medikamentenentwicklung oder Verkehrsplanung. Doch in den falschen Händen könnte die Technologie auch eine dunkle Seite haben: Die überlegene Rechenleistung könnte heute gängige Verschlüsselungsalgorithmen brechen. Nils Gerhardt, CTO von Utimaco, geht der Frage nach, ob dadurch eine reale Bedrohung für Unternehmen besteht und was sie dagegen tun können.

Quantencomputer basieren auf Quantenbits als kleinste Einheit. Anders als konventionelle Bits können diese aber nicht nur den Zustand 1 oder 0 annehmen, sondern sich auch in einem indifferenten Zustand, der sogenannten Superposition befinden. Das bedeutet, solange bis keine Messung stattfindet, ist der Zustand eines QBits nicht klar definiert. Dieses Phänomen ist einigen vielleicht noch vom Doppelspaltexperiment im Physikunterricht oder durch das Gedankenexperiment Schrödingers Katze bekannt.

Diese besondere Eigenschaft könnte neue Rechenoperationen ermöglichen, die konventionelle Computer nicht beherrschen und so bestimmte mathematische Probleme schneller lösbar machen. In der Theorie könnte ein Quantenrechner binnen kurzer Zeit bei einem Problem zu einem Ergebnis kommen, für das ein herkömmlicher Computer Jahrtausende theoretischer Rechenzeit benötigt hätte. Neben neuen Erkenntnissen für Wissenschaft und Forschung kann diese überlegene Rechenleistung allerdings auch Risiken bedeuten.

Der Q-Day, ein Damoklesschwert?

Mit dem Begriff Q-Day wird in der Berichterstattung der Tag bezeichnet, an dem Quantenrechner in der Lage sein werden, kryptographische Verfahren wie z.B. Verschlüsselungen zu brechen, die heute als sicher gelten. Die meisten Experten gehen davon aus, dass dieser Tag kommen wird. Die Frage ist allerdings, wann dies passieren wird – in fünf, zehn oder erst in zwanzig Jahren? Dafür Prognosen abzugeben ist schwierig. Auch wenn kein Anlass zur Panik besteht, sollten sich Sicherheitsverantwortliche mit der Problematik vertraut machen und bereits heute mögliche Gegenmaßnahmen evaluieren.

Würde der Q-Day auf eine nicht vorbereitete digitale Welt treffen, könnten erhebliche Konsequenzen drohen. Datenverkehr über HTTPS wäre nicht mehr sicher, ebenso wie Ende-zu-Ende-verschlüsselte Chatnachrichten. Elektronisch signierte Verträge könnten unerkannt gefälscht werden. Digitale Identitäten, die auf Zertifikaten basieren, könnten korrumpiert werden. Über Jahre aufgebaute Verfahren, um in der digitalen Welt Vertrauen zu schaffen, könnten im Extremfall auf einmal wertlos werden. Eine Bedrohung existiert also durchaus, doch wie kommt sie zustande?

Gefahr durch neue Rechenarten

Viele Verschlüsselungen im Netz und auch elektronische Signaturen basieren auf asymmetrischer Kryptografie. Diese beruht wiederum auf einer Kombination von öffentlichem und privatem Schlüssel. Der öffentliche Schlüssel kann dabei, wie der Name bereits sagt, bedenkenlos geteilt werden, da es mit heutigen Methoden nicht möglich ist, in reeller Zeit aus dem öffentlichen auf den privaten Schlüssel zu schließen. Das liegt daran, dass die Verknüpfung zwischen beiden durch mathematische Operationen realisiert wird, die in eine Richtung trivial aber schwer umkehrbar sind.

Ein Beispiel dafür ist die Multiplikation von Primzahlen. Diese Rechenoperation ist einfach, die Primfaktorzerlegung des entstandenen Produkts wesentlich komplizierter. Wählt man die Primzahlen ausreichend groß, ist diese Zerlegung selbst für moderne Supercomputer nicht in sinnvoller Zeit realisierbar.

Durch die speziellen Eigenschaften der Quantenrechner könnten zukünftig allerdings Verfahren eingesetzt werden, die eine erhebliche Verkürzung dieser Rechenzeit ermöglichen. Der Shor-Algorithmus erlaubt in der Theorie eine wesentlich schnellere Faktorisierung großer Zahlen als klassische Algorithmen. Sobald es ausreichend leistungsfähige und zuverlässige Quantencomputer gibt, um diesen Algorithmus praktisch einzusetzen, könnten Verfahren der asymmetrischen Kryptografie angreifbar werden.

Mögliche Gegenmaßnahmen

Um der drohenden Gefahr durch Quantenrechner entgegenzuwirken, gibt es grundsätzlich zwei Ansätze. Zum einen wird vorgeschlagen, die Eigenschaften der Quantenwelt ebenfalls für sehr sichere Verschlüsselungen zu nutzen. Bei der sogenannten Quantum Key Distribution könnte beispielsweise der Austausch polarisierter Photonen dazu dienen. Dafür wären allerdings eine spezialisierte Infrastruktur und sehr teures Equipment notwendig. Da sich diese Technologie noch in einem sehr frühen Entwicklungsstadium befindet, rät auch das BSI vom praktischen Einsatz ab.

Der andere, vielversprechendere Ansatz ist es, mathematische Probleme zu verwenden, die auch mittels der speziellen Fähigkeiten eines Quantencomputers nicht effizient gelöst werden können. Dieser Post-Quanten-Kryptografie (Post Quantum Cryptography, PQC) genannte Ansatz kommt mit Standard-Hardware und bestehenden Infrastrukturen aus.

Anstatt der Faktorisierung großer Zahlen könnten beispielsweise hochdimensionale Gitter zum Einsatz kommen. Bereits seit den 1990er Jahren arbeiten Wissenschaftler an entsprechenden Verfahren, die für die Entschlüsselung den kürzesten möglichen Vektor zwischen zwei gegebenen Punkten verwenden. Dieser Vektor müsste errechnet werden, um von einem öffentlichen auf einen privaten Schlüssel zu kommen. Da unsere Vorstellungskraft auf drei Dimensionen beschränkt ist, wirkt so eine Vektorrechnung zunächst nicht sehr kompliziert. Die Mathematik kennt allerdings keine derartigen Beschränkungen und je mehr Dimensionen ein Gitter hat, desto komplexer wird die Vektorberechnung. Für diese Art der Kryptografie existieren bereits anerkannte Verfahren und an einem Standard wird bereits gearbeitet. Weitere quantensichere Ansätze existieren z.B. basierend auf speziellen Problemen aus der Kodierungstheorie oder der Kollisionsresistenz kryptographischer Hashfunktionen.

Fazit: Flexibel planen

Es ist eher unwahrscheinlich, dass sich zukünftig ein Verfahren oder gar ein spezifischer Algorithmus als allgemeingültige Lösung durchsetzen wird. Vielmehr ist damit zu rechnen, dass es verschiedene Verfahren für unterschiedliche Anwendungsfälle geben wird. Es ist auch wahrscheinlich, dass neue PQC-Algorithmen sukzessive angepasst werden müssen, wenn sich Technologien weiterentwickeln.

Unternehmen sollten also eine Infrastruktur aufbauen, die mit verschiedenen Algorithmen zurechtkommt, die heute und in Zukunft mit PQC-Algorithmen modernisiert und angepasst werden kann. Dafür steht der Begriff Kryptoagilität. In einem solchen Ökosystem ist es auch möglich, dass herkömmliche und quantensichere Algorithmen parallel zum Einsatz kommen, um den Übergang zu erleichtern.

Autor: Nils Gerhardt, CTO bei Utimaco

Fachartikel

Studien

Drei Viertel aller DACH-Unternehmen haben jetzt CISOs – nur wird diese Rolle oft noch missverstanden

AI-Security-Report 2024 verdeutlicht: Deutsche Unternehmen sind mit Cybersecurity-Markt überfordert

Cloud-Transformation & GRC: Die Wolkendecke wird zur Superzelle

Threat Report: Anstieg der Ransomware-Vorfälle durch ERP-Kompromittierung um 400 %

Studie zu PKI und Post-Quanten-Kryptographie verdeutlicht wachsenden Bedarf an digitalem Vertrauen bei DACH-Organisationen

Whitepaper

Unter4Ohren

Datenklassifizierung: Sicherheit, Konformität und Kontrolle

Die Rolle der KI in der IT-Sicherheit

CrowdStrike Global Threat Report 2024 – Einblicke in die aktuelle Bedrohungslandschaft

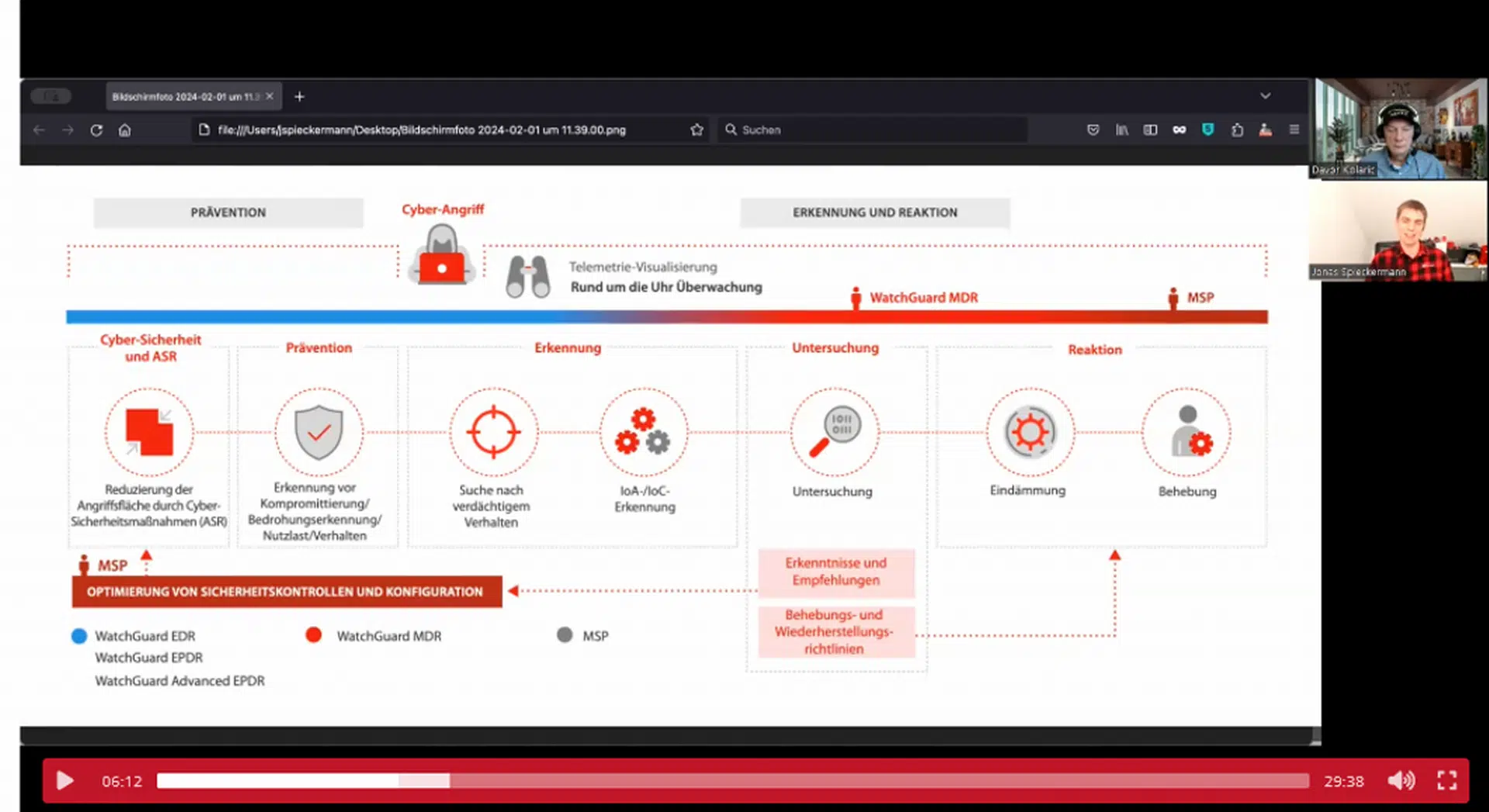

WatchGuard Managed Detection & Response – Erkennung und Reaktion rund um die Uhr ohne Mehraufwand