Wer KI-Agenten im Unternehmenseinsatz betreibt, stößt schnell auf ein strukturelles Problem: Nach jeder Konversation beginnt der Agent von vorn. Kein Kontext, keine Präferenzen, keine Historie. Das zeigt ein aktueller Beitrag im Oracle Developers Blog. Dabei liegt die Lösung nicht im Erweitern von Kontextfenstern, sondern in einer durchdachten Speicherinfrastruktur – und die folgt Prinzipien, die das Datenbankdesign seit Jahrzehnten kennt.

Das Kernproblem: Zustandslosigkeit als Systemdesignfrage

Aktuelle KI-Agenten leiden unter einem grundlegenden Architekturmangel: Sie verfügen über kein sitzungsübergreifendes Gedächtnis. Ein Kundenservice-Agent, der heute eine Beschwerde bearbeitet, weiß morgen weder, wer der Gesprächspartner ist, noch welche Präferenzen dieser bereits geäußert hat. Jede Interaktion startet ohne Vorwissen.

Das ist kein Implementierungsfehler, sondern ein Designproblem. Die Antwort darauf lautet: Agentenspeicher – eine persistente, sich entwickelnde Zustandsschicht außerhalb des Sprachmodells selbst.

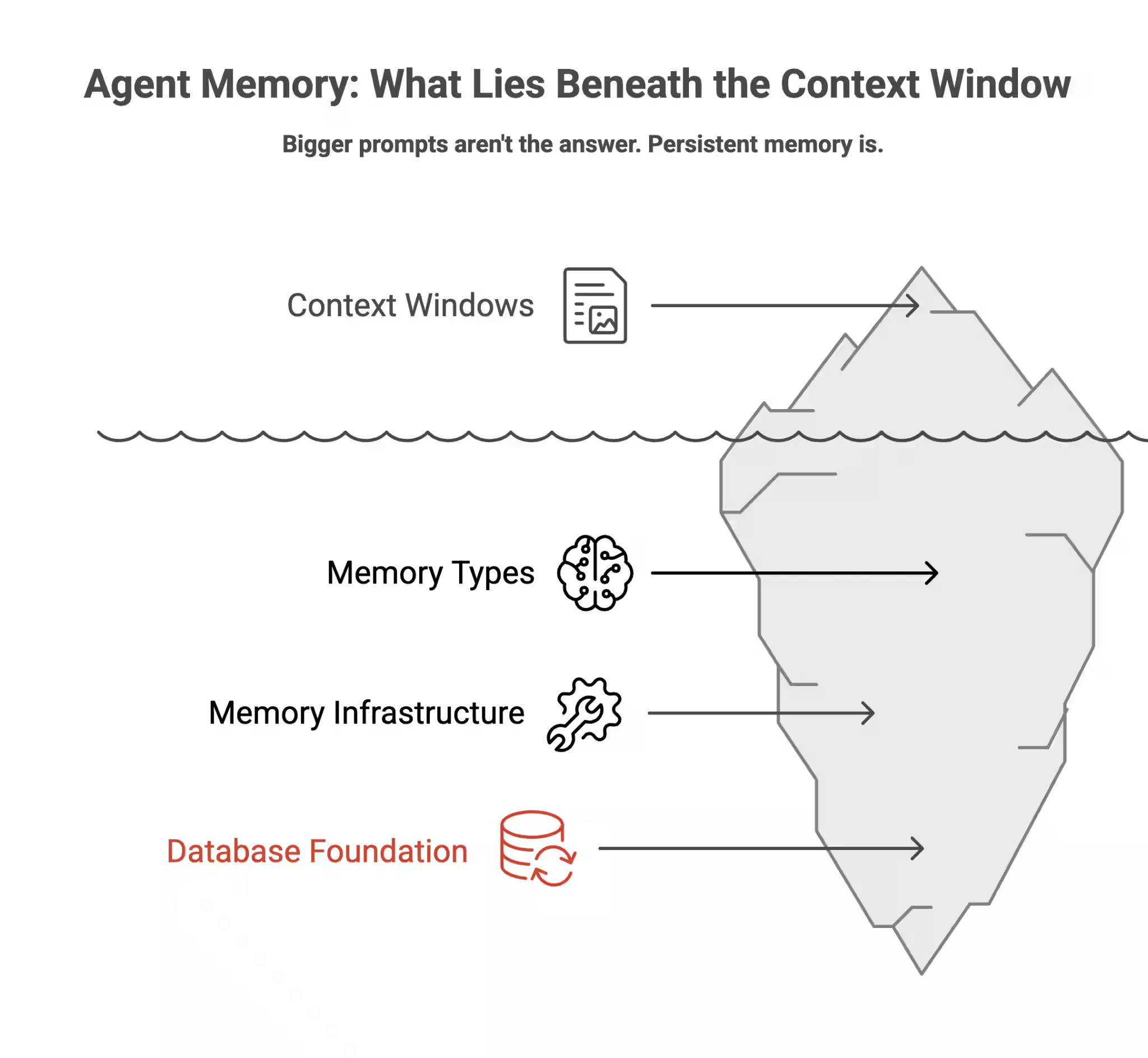

Grafik Quelle: Oracle

Größere Kontextfenster lösen das Problem nicht

Ein verbreitetes Missverständnis besteht darin, wachsende Kontextfenster – heute bis zu einer Million Token – als Lösung zu betrachten. Tatsächlich handelt es sich dabei lediglich um einen größeren, aber weiterhin temporären Arbeitsspeicher: Nach Sitzungsende gehen alle Informationen verloren.

Hinzu kommen praktische Einschränkungen: Die tatsächliche Zuverlässigkeit liegt meist deutlich unter der nominellen Kapazität. Ein Modell mit 200.000 Token zeigt typischerweise ab etwa 130.000 Token Leistungseinbußen. Zudem werden alle Inhalte gleichwertig behandelt – relevante Details erhalten kein höheres Gewicht als beiläufige Informationen. Und die Kosten skalieren linear mit der Tokenmenge.

Auch Retrieval Augmented Generation (RAG) ist kein Ersatz für echten Agentenspeicher. RAG bringt externes Wissen zur Inferenzzeit in den Kontext – es ist jedoch zustandslos und kennt keine Interaktionshistorie. Kurz gesagt: RAG verbessert die Qualität einzelner Antworten, Agentenspeicher ermöglicht lernendes und anpassungsfähiges Verhalten über Zeit.

Vier Gedächtnistypen nach dem CoALA-Framework

Die Kognitionswissenschaft liefert ein belastbares Modell. Das 2023 an der Princeton University veröffentlichte CoALA-Framework (Cognitive Architectures for Language Agents) unterscheidet vier Speichertypen, die heute als Grundlage für alle wesentlichen Frameworks in diesem Bereich dienen:

Arbeitsgedächtnis enthält den aktuellen Gesprächskontext – das, was im aktiven Kontextfenster vorhanden ist. Es ist schnell verfügbar, aber flüchtig.

Prozedurales Gedächtnis umfasst Systemanweisungen, Entscheidungslogik und erlernte Verhaltensweisen – also das Wissen darüber, wie Aufgaben auszuführen sind.

Semantisches Gedächtnis speichert gesammelte Fakten, Nutzerpräferenzen und Kontextwissen, das über Sitzungen hinweg erhalten bleibt.

Episodisches Gedächtnis enthält vergangene Interaktionen und Erfahrungen – konkrete Ereignisse aus früheren Gesprächen.

Die meisten heutigen Agenten verfügen ausschließlich über Arbeitsgedächtnis. Das entspricht dem Versuch, ausschließlich mit einem Whiteboard zu arbeiten, das täglich gelöscht wird.

Technische Architektur: Drei Speicherparadigmen im Verbund

Produktionssysteme setzen typischerweise auf drei komplementäre Ansätze:

Vektorspeicher wandeln Text in numerische Einbettungen um und ermöglichen bedeutungsbasierte Ähnlichkeitssuche. Sie sind effizient, bilden jedoch keine strukturellen Beziehungen zwischen Informationen ab.

Wissensgraphen speichern Fakten als Entitäten und Kanten und erlauben so relationale Abfragen. Mit bi-temporaler Modellierung lässt sich dabei nicht nur erfassen, was bekannt ist, sondern auch, wann welche Information vorlag. Frameworks wie Zeps Graphiti erreichen mit diesem Ansatz laut eigenen Angaben eine Abrufgenauigkeit von 94,8 Prozent im Deep Memory Retrieval-Benchmark.

Relationale Datenbanken sichern strukturierte Daten wie Nutzerprofile, Zugriffskontrollen und Audit-Protokolle mit den Transaktionsgarantien, die Produktionsumgebungen erfordern.

In der Praxis betreiben viele Teams diese drei Ebenen als separate Systeme – mit entsprechend getrennten Sicherheitsmodellen und ohne gemeinsame Transaktionsgrenzen. Schlägt ein Schreibvorgang fehl, gerät der Agentenspeicher in einen inkonsistenten Zustand. Konvergierte Datenbankarchitekturen, die alle drei Paradigmen in einer Engine vereinen, lösen dieses Problem durch gemeinsame ACID-Transaktionen und einheitliche Sicherheitsrichtlinien.

Speicherverwaltung: Vier Kernoperationen

Jedes Speichersystem arbeitet mit denselben vier Grundoperationen: Hinzufügen neuer Informationen, Aktualisieren bestehender Einträge, Löschen widersprüchlicher Daten und Übergehen irrelevanter Inhalte. Moderne Systeme delegieren diese Entscheidungen zunehmend an das Sprachmodell selbst, statt auf statische Regellogik zu setzen.

Beim Vergessen – einer oft unterschätzten Operation – kommen häufig Verfallsfunktionen zum Einsatz: Selten abgerufene Einbettungen verlieren schrittweise an Relevanz, analog zu biologischen Gedächtnismustern. Alternativ können alte Fakten als ungültig markiert, aber archiviert werden – notwendig etwa für Prüfpfade in regulierten Branchen.

Unternehmenseinsatz: Anforderungen jenseits des Prototyps

Der Schritt vom Pilotprojekt zur Produktionsumgebung offenbart Anforderungen, die viele Implementierungen zunächst nicht berücksichtigen.

Sicherheit und Isolation auf Zeilenebene sind für Multi-Tenant-Szenarien unabdingbar. Namespace-Trennung allein reicht in regulierten Umgebungen nicht aus. Zudem stellt sogenanntes Memory Poisoning – das gezielte Einschleusen falscher Informationen in den Agentenspeicher – einen realen Angriffsvektor dar.

Regulatorische Anforderungen erzeugen strukturelle Spannungen: Die DSGVO verlangt das Recht auf Vergessenwerden personenbezogener Daten, während der EU AI Act (vollständig anwendbar ab August 2026) für risikoreiche KI-Systeme zehnjährige Audit-Protokolle vorschreibt. Beide Anforderungen gleichzeitig zu erfüllen, erfordert eine differenzierte Architektur.

ACID-Transaktionen sind bei Speicheroperationen, die mehrere Datentypen gleichzeitig betreffen, nicht verhandelbar. Teilweise fehlgeschlagene Schreibvorgänge hinterlassen inkonsistente Zustände – mit entsprechenden Folgen für das Agentenverhalten.

Laut einer KPMG-Umfrage unter 130 Führungskräften großer Unternehmen nannten 65 Prozent zwei Quartale in Folge die Komplexität agentischer Systeme als größtes Implementierungshindernis. Drei Viertel der Unternehmen befinden sich noch in der Pilotphase.

Ausblick: Offline-Konsolidierung und Konvergenz

Zwei Entwicklungen zeichnen sich ab: Erstens gewinnen sogenannte Sleep-Time-Berechnungen an Bedeutung – Agenten, die in Leerlaufphasen ihre Erinnerungen reorganisieren und konsolidieren, arbeiten bei der Abfrage effizienter. Forschungsergebnisse von Letta zeigen dabei Genauigkeitssteigerungen von 18 Prozent und eine Kostensenkung von etwa Faktor 2,5 pro Abfrage.

Zweitens verschiebt sich der Fokus von einfachen RAG-Implementierungen hin zu vollständigen Speichersystemen. Marktbeobachter wie VentureBeat erwarten, dass kontextueller Agentenspeicher RAG im Bereich agentischer KI im Verlauf des Jahres 2026 als primären Ansatz ablösen wird.

Die technische Richtung ist dabei klar: Agentenspeicher ist im Kern ein Datenbankproblem – mit allen Anforderungen an Konsistenz, Sicherheit und Skalierbarkeit, die dieses Feld seit Jahrzehnten prägen.

Hier geht’s weiter

Fachartikel

KI-Agenten ohne Gedächtnis: Warum persistenter Speicher der Schlüssel zur Praxistauglichkeit ist

Oracle erweitert OCI-Netzwerksicherheit: Zero Trust Packet Routing jetzt mit Cross-VCN-Unterstützung

KI-Agenten in der Praxis: Anthropic misst Autonomie und Nutzerverhalten im großen Maßstab

Google Play 2025: KI-Systeme blockieren Millionen schädlicher Apps

Details zur Sicherheitslücke im Windows-Editor bekannt geworden

Studien

IT-Budgets 2026: Deutsche Unternehmen investieren mehr – und fordern messbaren Gegenwert

KI-Investitionen in Deutschland: Solide Datenbasis, aber fehlende Erfolgsmessung bremst den ROI

Cybersicherheit 2026: Agentic AI auf dem Vormarsch – aber Unternehmen kämpfen mit wachsenden Schutzlücken

IT-Fachkräfte: Warum der deutsche Stellenabbau die Sicherheitslage verschlechtert

Deutsche Wirtschaft unzureichend auf hybride Bedrohungen vorbereitet

Whitepaper

WatchGuard Internet Security Report zeigt über 1.500 Prozent mehr neuartige Malware auf

Armis Labs Report 2026: Früherkennung als Schlüsselfaktor im Finanzsektor angesichts KI-gestützter Bedrohungen

Active Directory schützen: TÜV Rheinland liefert Leitfaden mit konkreten Handlungsempfehlungen

Sicherheitslücken in Passwortmanagern: ETH-Forschende hebeln Zero-Knowledge-Versprechen aus

MITRE ATLAS analysiert OpenClaw: Neue Exploit-Pfade in KI-Agentensystemen

Hamsterrad-Rebell

Incident Response Retainer – worauf sollte man achten?

KI‑basierte E‑Mail‑Angriffe: Einfach gestartet, kaum zu stoppen

NIS2: „Zum Glück gezwungen“ – mit OKR-basiertem Vorgehen zum nachhaltigen Erfolg

Cyberversicherung ohne Datenbasis? Warum CIOs und CISOs jetzt auf quantifizierbare Risikomodelle setzen müssen