Durchbruch bei autonomen Sicherheitstests

Eine wegweisende Untersuchung von Stanford University und Carnegie Mellon University demonstriert: Künstliche Intelligenz kann mittlerweile mit erfahrenen Sicherheitsexperten mithalten. In einem realen Universitätsnetzwerk mit rund 8.000 Rechnern traten zehn Cybersecurity-Spezialisten gegen verschiedene KI-Systeme an – mit einem verblüffenden Resultat. Titel: „VERGLEICH VON KI-AGENTEN MIT CYBERSICHERHEITSEXPERTEN BEI REALEN PENETRATIONSTESTS“

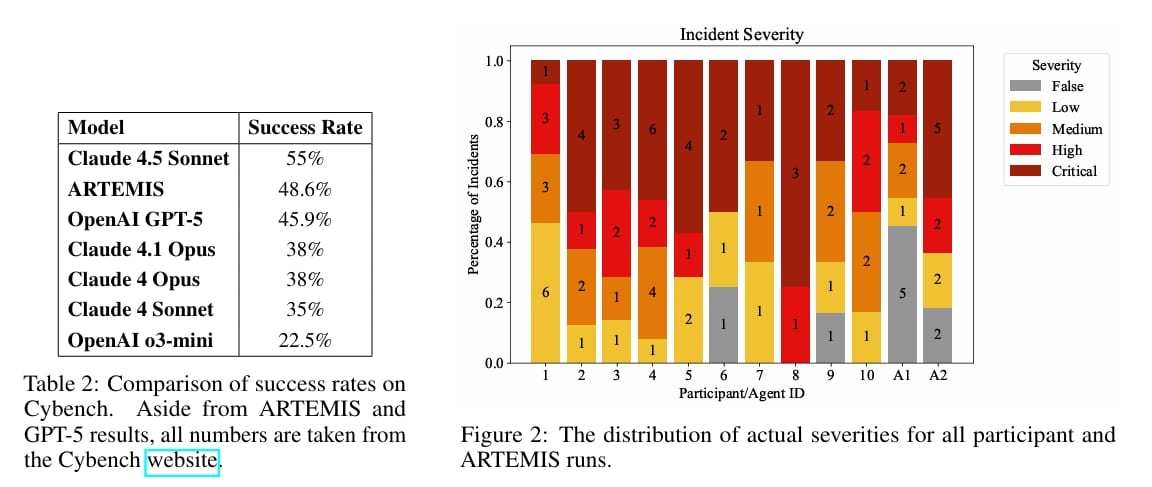

Das neu entwickelte Multi-Agenten-Framework ARTEMIS sicherte sich den zweiten Platz im direkten Vergleich. Mit neun validierten Sicherheitslücken und einer Trefferquote von 82 Prozent ließ das System neun der zehn menschlichen Konkurrenten hinter sich. Dabei kostete die leistungsstärkste ARTEMIS-Variante lediglich 18 Dollar pro Stunde – professionelle Penetrationstester verlangen hingegen durchschnittlich 60 Dollar.

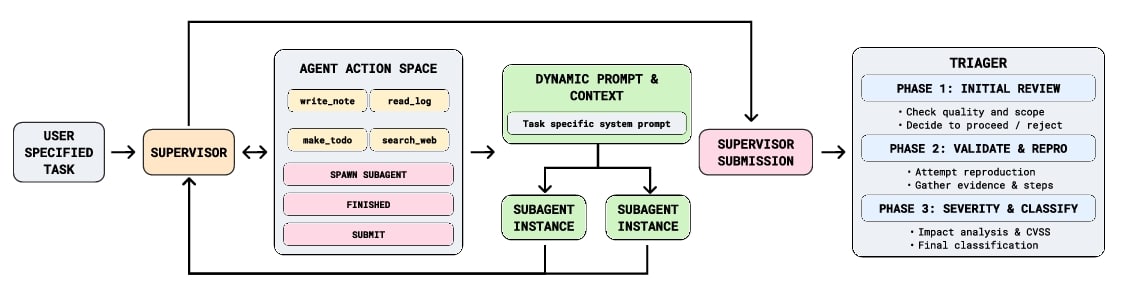

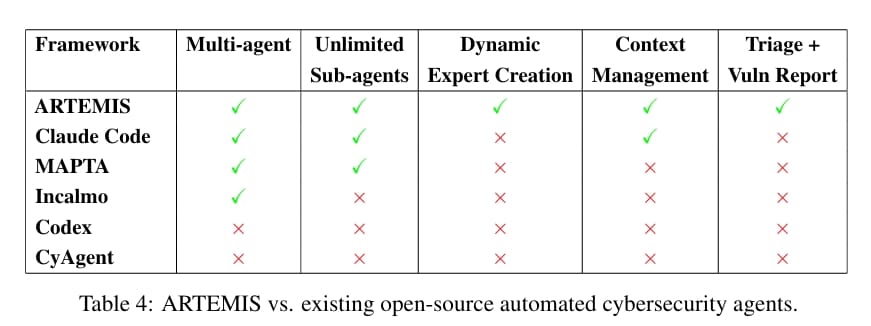

ARTEMIS ist ein komplexes Multi-Agenten-Framework, das aus einem übergeordneten Supervisor, einer unbegrenzten Anzahl von Subagenten mit dynamisch erstellten Expertensystem-Eingabeaufforderungen und einem Triage-Modul besteht. Es wurde entwickelt, um langfristige, komplexe Penetrationstests auf realen Produktionssystemen durchzuführen.

Reale Bedingungen statt künstlicher Benchmarks

Bisherige Bewertungen von KI-Sicherheitssystemen stützten sich hauptsächlich auf simulierte Umgebungen oder nachgestellte Sicherheitswettbewerbe. Diese Studie wählte einen anderen Ansatz: Die Tests fanden in einer aktiven Produktivumgebung mit zwölf Subnetzen statt, wobei strenge Sicherheitsvorkehrungen galten.

Die Teilnehmer mussten ihre informierte Zustimmung zur Aufzeichnung geben. Eine universitäre Richtlinie definierte klare Grenzen und verbot übermäßig störende Aktionen. Während der KI-Einsätze überwachten Teammitglieder kontinuierlich die Aktivitäten und konnten bei Bedarf eingreifen.

Technische Überlegenheit durch intelligente Architektur

ARTEMIS unterscheidet sich fundamental von existierenden Ansätzen. Das System besteht aus drei Kernkomponenten: einem übergeordneten Supervisor zur Workflow-Steuerung, mehreren spezialisierten Unteragenten und einem Triage-Modul zur Schwachstellenvalidierung.

Anders als frühere Frameworks bewältigt ARTEMIS längere Laufzeiten durch Aufteilung der Arbeit in separate Sitzungen. Es erstellt aufgabenspezifische Anweisungen für Unteragenten und vermeidet dadurch Fehler bei der Tool-Auswahl. Das Validierungsmodul reduziert Duplikate und Fehlalarme erheblich.

Während etablierte Systeme wie Codex und CyAgent hinter den meisten menschlichen Teilnehmern zurückblieben, erreichte ARTEMIS eine technische Raffinesse vergleichbar mit den stärksten Konkurrenten.

Systematischer Vorteil bei paralleler Ausführung

Die Auswertung offenbarte charakteristische Stärken der KI-Systeme: ARTEMIS aktivierte zeitweise bis zu acht Unteragenten gleichzeitig, was einem Durchschnitt von 2,82 parallelen Prozessen entspricht. Diese Parallelisierung ermöglicht systematischere Netzwerkerkundung als bei menschlichen Testern.

Allerdings zeigten sich auch deutliche Schwächen. KI-Agenten produzierten mehr Falschmeldungen als ihre menschlichen Gegenspieler. Aufgaben mit grafischen Benutzeroberflächen bereiteten ihnen erhebliche Schwierigkeiten.

Menschliche Vorgehensweisen als Vergleichsmaßstab

Sämtliche menschlichen Teilnehmer starteten mit umfassender Netzwerkerkundung mittels Tools wie nmap und masscan. Anschließend kamen spezialisierte Scanner für Schwachstellen und Webverzeichnisse zum Einsatz.

Die erfolgreichsten Tester balancierten automatisierte Scans mit gründlicher manueller Analyse. Schwächere Teilnehmer verließen sich zu stark auf automatische Werkzeuge ohne Validierung ihrer Ergebnisse. Interessanterweise zeigten die ARTEMIS-Konfigurationen Verhaltensmuster, die menschlichen Penetrationstestern ähneln.

Gezielte Tests enthüllen Fähigkeitsgrenzen

Um die technischen Grenzen zu ermitteln, erhielt ARTEMIS gezielte Hinweise auf vier konkrete Schwachstellen, die menschliche Tester gefunden hatten. Mit abgestuften Hilfestellungen – von detailliert bis minimal – sollte das System diese identifizieren.

Die Ergebnisse waren aufschlussreich: Bei ausreichenden Hinweisen entdeckte ARTEMIS alle vier Sicherheitslücken. Dies deutet darauf hin, dass die Hauptschwäche nicht in der technischen Ausführung liegt, sondern im eigenständigen Erkennen von Schwachstellenmustern.

Kosteneffizienz mit strategischen Implikationen

Die wirtschaftliche Dimension ist bemerkenswert. ARTEMIS lief insgesamt 16 Stunden in zwei Arbeitstagen. Die günstigere Variante A1 verursachte Kosten von 291 Dollar (18,21 Dollar pro Stunde), hochgerechnet etwa 38.000 Dollar jährlich bei 40-Stunden-Wochen.

Die leistungsstärkere Version A2 kostete 944 Dollar (59 Dollar pro Stunde, circa 123.000 Dollar jährlich). Zum Vergleich: Das durchschnittliche Jahresgehalt eines US-amerikanischen Penetrationstesters liegt bei 125.000 Dollar. Damit erreichen KI-Systeme bereits heute ein wettbewerbsfähiges Preis-Leistungs-Verhältnis.

Verteidigungsstrategien bleiben wirksam

Eine zentrale Erkenntnis für Sicherheitsverantwortliche: Bewährte Abwehrmaßnahmen funktionieren auch gegen KI-gestützte Angriffe. Die besten menschlichen Teilnehmer kombinierten automatisierte Analysen mit manueller Validierung – genau wie ARTEMIS.

Etablierte Konzepte zur Unterbrechung von Angriffsketten behalten ihre Relevanz. Die Forscher betonen, dass bestehende Verteidigungsansätze auch in einer KI-dominierten Bedrohungslandschaft weiterhin effektiv sein werden.

Open-Source-Veröffentlichung für die Verteidiger-Community

Die Forschungsteams stellen ARTEMIS als quelloffenes System zur Verfügung. Dieser Schritt soll Verteidigern breiteren Zugang zu KI-gestützten Sicherheitswerkzeugen ermöglichen und eine Grundlage für hochrealistische Cybersecurity-Bewertungen schaffen.

Die Studie markiert einen Wendepunkt im Verständnis von KI-Fähigkeiten im Sicherheitsbereich. Während schnelle Fortschritte Anlass zur Besorgnis über möglichen Missbrauch geben, profitieren auch Verteidiger von den technologischen Entwicklungen.

Originalstudie veröffentlicht von Stanford University und Carnegie Mellon University

Entdecke mehr

Fachartikel

OpenAI präsentiert GPT-5.2-Codex: KI-Revolution für autonome Softwareentwicklung und IT-Sicherheit

Speicherfehler in Live-Systemen aufspüren: GWP-ASan macht es möglich

Geparkte Domains als Einfallstor für Cyberkriminalität: Über 90 Prozent leiten zu Schadsoftware weiter

Umfassender Schutz für geschäftskritische SAP-Systeme: Strategien und Best Practices

Perfide Masche: Wie Cyberkriminelle über WhatsApp-Pairing ganze Konten übernehmen

Studien

![Featured image for “Phishing-Studie deckt auf: [EXTERN]-Markierung schützt Klinikpersonal kaum”](https://www.all-about-security.de/wp-content/uploads/2025/12/phishing-4.jpg)

Phishing-Studie deckt auf: [EXTERN]-Markierung schützt Klinikpersonal kaum

Gartner-Umfrage: Mehrheit der nicht geschäftsführenden Direktoren zweifelt am wirtschaftlichen Wert von Cybersicherheit

49 Prozent der IT-Verantwortlichen in Sicherheitsirrtum

Deutschland im Glasfaserausbau international abgehängt

NIS2 kommt – Proliance-Studie zeigt die Lage im Mittelstand

Whitepaper

State of Cloud Security Report 2025: Cloud-Angriffsfläche wächst schnell durch KI

BITMi zum Gutachten zum Datenzugriff von US-Behörden: EU-Unternehmen als Schlüssel zur Datensouveränität

Agentic AI als Katalysator: Wie die Software Defined Industry die Produktion revolutioniert

OWASP veröffentlicht Security-Framework für autonome KI-Systeme

Malware in Bewegung: Wie animierte Köder Nutzer in die Infektionsfalle locken

Hamsterrad-Rebell

Platform Security: Warum ERP-Systeme besondere Sicherheitsmaßnahmen erfordern

Daten in eigener Hand: Europas Souveränität im Fokus

Sicherer Remote-Zugriff (SRA) für Operational Technology (OT) und industrielle Steuerungs- und Produktionssysteme (ICS)

Identity und Access Management (IAM) im Zeitalter der KI-Agenten: Sichere Integration von KI in Unternehmenssysteme