Ein erfahrener Cybersecurity-Architekt weiß: Die Migration von SIEM-Umgebungen zu Microsoft Sentinel bringt immer wieder dieselben Fragen auf den Tisch – unabhängig von Branche oder Unternehmensgröße.

- Welche Protokolle sind für die Angriffserkennung unverzichtbar?

- Welche Daten lassen sich langfristig aufbewahren, ohne das Budget zu sprengen?

- Und wie behält man bei alledem die Kostenkontrolle?

Sentinel war schon immer leistungsfähig. Doch als „kostengünstig“ ließ sich der Dienst bislang nur schwer verkaufen – vor allem, wenn es um die Archivierung von sekundären oder Compliance-relevanten Protokollen ging. Diese Daten werden im Alltag selten benötigt, sind aber im Ernstfall für forensische Analysen unverzichtbar.

Frühere Projekte erforderten kreative, aber oft unbefriedigende Lösungen: aggressives Filtern, Stichproben, Auslagerung selten genutzter Daten in externe Speicher. In jüngster Zeit halfen zusätzliche Protokollierungsansätze, doch stets blieb das Gefühl eines faulen Kompromisses.

Mit dem Sentinel Data Lake könnte sich dieses Dilemma nun grundlegend ändern.

Ein neuer Weg aus der Kostenfalle

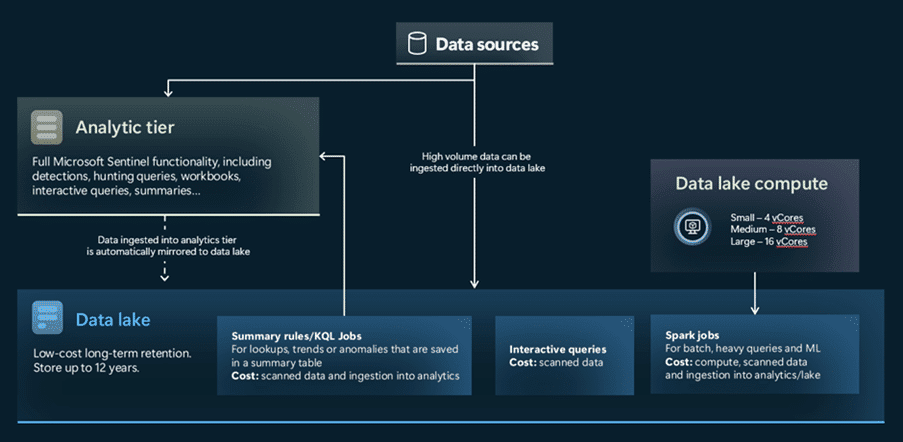

Mit dem Microsoft Sentinel Data Lake steht nun ein Ansatz bereit, der eines der größten Praxisprobleme elegant löst. Anstatt sämtliche Protokolle in die teure Analytics-Ebene zu laden – und damit hohe Gebühren für Erfassung und Abfragen zu zahlen – lassen sich im Data Lake enorme Datenmengen deutlich günstiger ablegen. Der Clou: Bei Bedarf bleiben sie trotzdem jederzeit abrufbar.

Grafik Quelle: NVISO Labs

Für alle, die schon einmal vor der Frage standen „Können wir es uns leisten, diese Logs wirklich aufzubewahren?“, könnte das die Antwort sein.

Erste Praxiserfahrungen sprechen für sich:

-

Bis zu 85 % Kostenersparnis: In ersten Tests senkten wir die Ausgaben massiv, indem wir Protokolle aus der Analytics- in die Data-Lake-Ebene verschoben.

-

Langfristige Archivierung wird machbar: Logs können nun bis zu zwölf Jahre aufbewahrt werden – ohne dass Budgets kollabieren.

-

Bessere Incident Response: Historische KQL-Abfragen auf ältere Daten sind endlich realistisch. Schluss mit dem frustrierenden „Diese Protokolle haben wir leider nicht mehr“.

Der Data Lake könnte sich damit als entscheidender Baustein für Organisationen erweisen, die Kostenkontrolle, Compliance und forensische Schlagkraft unter einen Hut bringen wollen.

Wo ist der Haken?

Überraschend wenige. Dennoch sollten Unternehmen ein paar Punkte im Blick behalten.

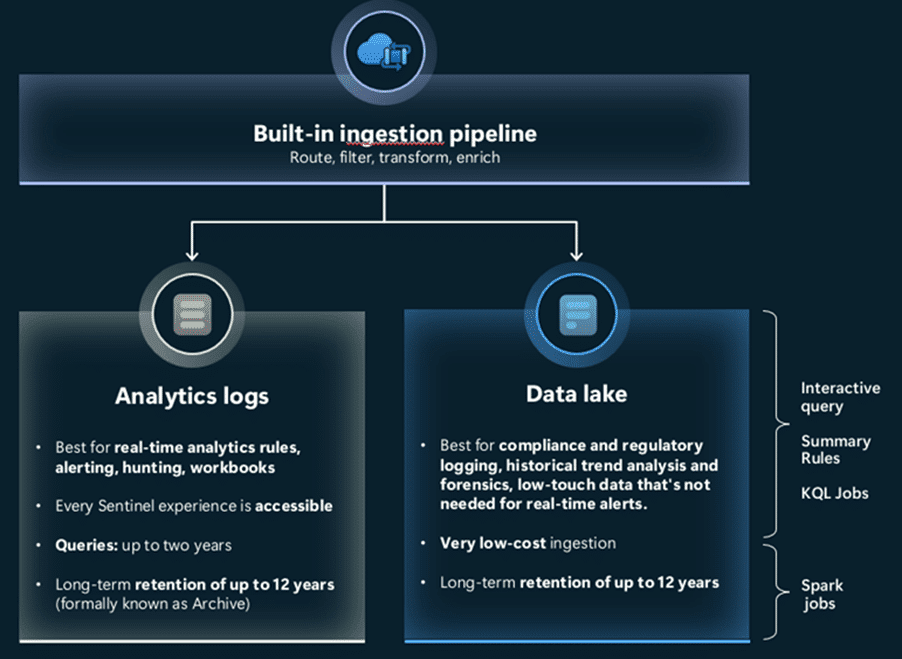

Grafik Quelle: NVISO Labs

Die Analytics-Ebene bleibt der Ort für Hot Data – also jene Protokolle, die in Echtzeit für Erkennung, Warnmeldungen, Dashboards und schnelle Abfragen benötigt werden. Daran ändert sich nichts.

Die Data-Lake-Ebene hingegen ist als Cold Storage zu verstehen: ein Speicher für umfangreiche, kontextreiche Daten wie Endpunkt-Telemetrie, NetFlow-Daten oder Infrastrukturprotokolle. Im Grunde handelt es sich um die modernisierte Version der bisherigen „Auxiliary“-Ebene.

Das Entscheidende: Beide Ebenen arbeiten nahtlos zusammen. Signaldaten bleiben in Analytics, während das „Rauschen“ – das dennoch für Ermittlungen wichtig ist – in den Data Lake wandert. Abfragen können über beide Ebenen hinweg laufen. Es geht also nicht darum, weniger zu protokollieren, sondern intelligenter.

Schneller Vergleich

| Feature | Analytics Tier (Hot) | Data Lake Tier (Cold) |

| Main Use | Real-time detection, dashboards, threat hunting | Long-term storage, compliance, historical hunting |

| Query Performance | Fast and indexed | Slower (full table scans) |

| Costs | Higher (standard ingestion + query) | Low ingestion, pay-per-query GB scanned |

| Retention | Up to 2 years | Up to 12 years |

| Great For | Azure AD sign-ins, alerts, DNS | EDR logs, network flow, anything high-volume |

Grafik Quelle: NVISO Labs

Einige Tipps, wenn Sie einen Wechsel in Betracht ziehen

Hier sind einige Erkenntnisse, die bei der Zusammenarbeit mit Teams gewonnen wurden und die diesen Schritt vollzogen haben:

- Vorhandene Protokolle: Sobald Sie Sentinel Data Lake aktivieren, sind Ihre vorhandenen Protokolle aus der Analytics-Ebene auch dort verfügbar: Sie müssen nichts duplizieren.

- Zusatzprotokolle: Wenn Sie bereits Zusatzprotokolle verwendet haben, werden diese nun in der neuen Data Lake-Ebene angezeigt. Hier sind keine Änderungen erforderlich. Nach der Onboarding-Phase sind Hilfsprotokolltabellen nicht mehr in Microsoft Defender Advanced Hunting verfügbar. Stattdessen können Sie über KQL-Abfragen zur Data Lake-Erkundung im Defender-Portal darauf zugreifen.

Außerdem:

- Historische Abfragen: Sie können KQL-Abfragen direkt im Data Lake für die Bedrohungssuche oder Untersuchungen ausführen. Dies ist zwar langsamer als die Abfrage von Hot-Daten, funktioniert aber und ist ein entscheidender Vorteil, wenn Sie historischen Kontext benötigen.

- Protokolle bei Bedarf hochstufen: Sie können Protokolle sogar vorübergehend von „kalt” auf „heiß” hochstufen, wenn Sie an einem bestimmten Fall arbeiten und einen schnelleren Zugriff wünschen.

Mögliche Nachteile der Umstellung auf Sentinel Data Lake

Microsoft Sentinel Data Lake bietet zwar erhebliche Kosteneinsparungen und langfristige Vorteile bei der Aufbewahrung, es sind jedoch auch einige Nachteile zu berücksichtigen:

- Einschränkungen bei interaktiven Abfragen im Data Lake: Interaktive Abfragen sind auf 30.000 Zeilen oder 64 MB Daten begrenzt und werden nach 10 Minuten abgebrochen. Wenn Sie einen großen Zeitbereich auswählen, kann Ihre Abfrage diese Grenzen überschreiten. Verwenden Sie KQL-Aufträge für Abfragen, die diese Grenze überschreiten würden.

- Kostenkomplexität: Das GB-Preismodell mit Bezahlung pro Abfrage erschwert die Kostenprognose, und häufige Umwandlungen von kalten in heiße Daten können versteckte Kosten verursachen.

- Anpassungen an Tools und Workflows: Nach der Aktivierung von Sentinel Data Lake werden Hilfsprotokolle nicht mehr in Defender Advanced Hunting angezeigt. Stattdessen können sie nur über die KQL-Schnittstelle „Data Lake Exploration” im Defender-Portal aufgerufen werden.

- Lernkurve: Analysten benötigen bessere KQL-Optimierungskenntnisse, um die Scan-Kosten zu minimieren und die Leistung zu verbessern.

Microsoft Sentinel Data Lake: Pros vs. Cons

Pros Pros |  Cons Cons |

| 85%+ cost savings compared to Analytics tier for high-volume logs | Slower queries due to lack of indexing |

| Long-term retention (up to 12 years) | Pay-per-query costs add unpredictability |

| Seamless integration with Analytics tier (hot + cold) | No real-time detection on cold data |

| Ability to store all context-rich logs without filtering or sampling | Requires log tiering strategy and operational changes |

| Historical hunting possible with KQL queries | Learning curve for query optimization |

| Promote cold data to hot for faster access when needed | Defender Advanced Hunting limitations (AUX data moved to Data Lake) |

Grafik Quelle: NVISO Labs

Ausblick: Warum der Data Lake die Zukunft des SOC prägt

Künstliche Intelligenz ist im Sicherheitsbereich allgegenwärtig – teils Hype, teils gelebte Realität. Bei NVISO ist der Weg bereits weit fortgeschritten: Das SOC ist stark automatisiert, KI beschleunigt Triage und Untersuchungen spürbar.

Doch der nächste Schritt – KI-Agenten, die eigenständig Entscheidungen treffen und Maßnahmen ergreifen – erfordert vor allem eines: Daten. Und zwar in großer Menge, aus unterschiedlichsten Quellen und über lange Zeiträume hinweg.

Genau hier spielt der Sentinel Data Lake seine strategische Rolle aus. Er ist nicht nur ein günstiger Speicher, sondern die essenzielle Datengrundlage für KI-gestützte Sicherheitsprozesse. Ohne diese tiefgreifende und langfristig verfügbare Datenschicht bleibt jede KI limitiert.

Damit ist der Data Lake weit mehr als eine technische Kostenoptimierung. Er markiert einen Paradigmenwechsel im Log-Management und im SIEM-Design – und könnte sich als Fundament des Security Operations Centers von morgen erweisen.

Von Maxim Deweerdt, Lösungsarchitekt für Managed Services bei NVISO

Mehr Lesestoff für Sie

Fachartikel

ShinyHunters-Angriffe: Mandiant zeigt wirksame Schutzmaßnahmen gegen SaaS-Datendiebstahl

Phishing-Angriff: Cyberkriminelle missbrauchen Microsoft-Infrastruktur für Betrugsmaschen

Wie Angreifer proprietäre KI-Modelle über normale API-Zugriffe stehlen können

KI-Agenten in cyber-physischen Systemen: Wie Deepfakes und MCP neue Sicherheitslücken öffnen

Sicherheitslücke in Cursor-IDE: Shell-Befehle werden zur Angriffsfläche

Studien

Deutsche Unicorn-Gründer bevorzugen zunehmend den Standort Deutschland

IT-Modernisierung entscheidet über KI-Erfolg und Cybersicherheit

Neue ISACA-Studie: Datenschutzbudgets werden trotz steigender Risiken voraussichtlich schrumpfen

Cybersecurity-Jahresrückblick: Wie KI-Agenten und OAuth-Lücken die Bedrohungslandschaft 2025 veränderten

![Featured image for “Phishing-Studie deckt auf: [EXTERN]-Markierung schützt Klinikpersonal kaum”](https://cdn-ileiehn.nitrocdn.com/EZdGeXuGcNedesCQNmzlOazGKKpdLlev/assets/images/optimized/rev-68905f9/www.all-about-security.de/wp-content/uploads/2025/12/phishing-4.jpg)

Phishing-Studie deckt auf: [EXTERN]-Markierung schützt Klinikpersonal kaum

Whitepaper

DigiCert veröffentlicht RADAR-Bericht für Q4 2025

Koordinierte Cyberangriffe auf polnische Energieinfrastruktur im Dezember 2025

Künstliche Intelligenz bedroht demokratische Grundpfeiler

Insider-Risiken in Europa: 84 Prozent der Hochrisiko-Organisationen unzureichend vorbereitet

ETSI veröffentlicht weltweit führenden Standard für die Sicherung von KI

Hamsterrad-Rebell

NIS2: „Zum Glück gezwungen“ – mit OKR-basiertem Vorgehen zum nachhaltigen Erfolg

Cyberversicherung ohne Datenbasis? Warum CIOs und CISOs jetzt auf quantifizierbare Risikomodelle setzen müssen

Identity Security Posture Management (ISPM): Rettung oder Hype?

Platform Security: Warum ERP-Systeme besondere Sicherheitsmaßnahmen erfordern