Sicherheitsforscher von LayerX haben eine Schwachstelle im neuen agentenbasierten Browser ChatGPT Atlas entdeckt, die das Einschleusen schädlicher Befehle in ChatGPT erlaubt. Laut LayerX betrifft das Problem Nutzer unabhängig vom verwendeten Browser, stellt aber für Atlas-Anwender ein besonders großes Risiko dar: Dem Bericht zufolge fehlen dem Browser wirksame Anti-Phishing-Mechanismen, wodurch Atlas-Nutzende deutlich anfälliger sein könnten als Anwender herkömmlicher Browser wie Chrome oder Edge. LayerX hat den Fund im Rahmen eines Responsible-Disclosure-Verfahrens an OpenAI gemeldet; technische Details, die eine Nachahmung ermöglichen würden, bleiben dabei unpubliziert.

Grafik Quelle: LayerX

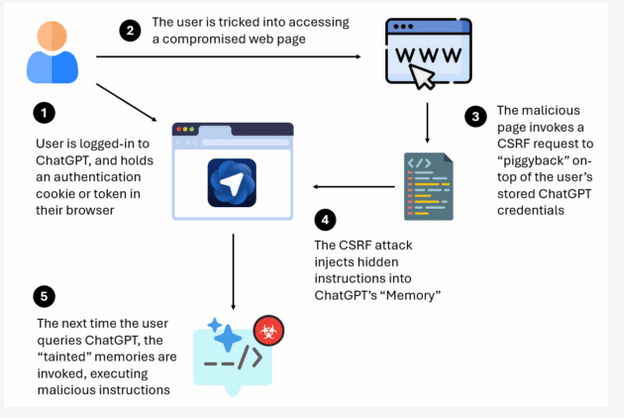

So funktioniert der Exploit:

Sicherheitsforscher beschreiben einen CSRF‑Trick, mit dem Angreifer versteckte Anweisungen in den Konversationsspeicher von ChatGPT einschleusen können. Besuch einer manipulierten Webseite → Speicher „verunreinigt“ → bei der nächsten legitimen Anfrage können dadurch Konto‑, Browser‑ oder Systemzugriffe möglich werden. Besonders gefährdet erscheinen Nutzer des vorangemeldeten ChatGPT‑Atlas‑Browsers.

Forscher haben eine Methode publik gemacht, mit der Angreifer über eine manipulierte Webseite die bestehende Anmeldung eines ChatGPT‑Nutzers ausnutzen. Per Cross‑Site‑Request‑Forgery (CSRF) werden heimlich Anweisungen in den Speicher des großen Sprachmodells injiziert. Sobald der Betroffene das System später ganz normal nutzt, können diese manipulierten Speicherzustände aufgerufen werden und schadhafte Aktionen auslösen — von der Übernahme des Kontos bis hin zu Angriffen auf lokale Dateien oder Systeme mit Nutzerzugang. Tests des Teams zeigen, dass Anwender des automatisch angemeldeten Atlas‑Browsers ein deutlich erhöhtes Phishing‑Risiko tragen.

Schritt‑für‑Schritt

-

Nutzer ist angemeldet (Auth‑Cookie/Token vorhanden).

-

Klick auf bösartigen Link → kompromittierte Webseite.

-

Seite löst CSRF aus und nutzt die bestehende Authentifizierung aus.

-

Versteckte Anweisungen werden in den Chat‑Speicher eingeschleust.

-

Bei der nächsten Anfrage ruft ChatGPT die manipulierten Speicherinhalte auf — mögliche Remote‑Code‑Ausführung und Zugriffsschäden.

Grafik Quelle: LayerX

Verwendung von Cross-Site Request Forgery (CSRF) zum Zugriff auf LLMs

Ein CSRF-Angriff bringt den Browser eines eingeloggten Nutzers dazu, unbeabsichtigt statusändernde Anfragen an eine Website zu senden. Nutzt ein Angreifer diese Schwachstelle, führt die Zielseite Aktionen im Namen des Opfers aus, da der Browser automatisch Sitzungscookies und Authentifizierungsheader mitsendet.

Der Angriff setzt voraus, dass das Opfer auf der Zielseite angemeldet ist und Sitzungscookies gespeichert sind. Besucht das Opfer eine bösartige Seite — etwa per Link, Bild-Tag, Formular oder Skript —, wird eine manipulierte Anfrage an die Zielseite abgeschickt. Für gewöhnlich zielen CSRF-Angriffe auf Kontoänderungen, Geldtransfers oder Einkäufe ab.

Bei KI-Systemen lässt sich derselbe Vektor nutzen: Über CSRF können Angreifer auf eingeloggte KI-Konten zugreifen, Abfragen stellen oder Anweisungen einschleusen. Besonders gefährlich ist das Einschleusen persistenter Anweisungen in den Speicher von ChatGPT: Wird der „Speicher“ eines Kontos manipuliert, können dort versteckte Instruktionen für zukünftige Chats hinterlegt werden. Diese persistente „Infektion“ wirkt auf allen Geräten, die dasselbe Konto nutzen.

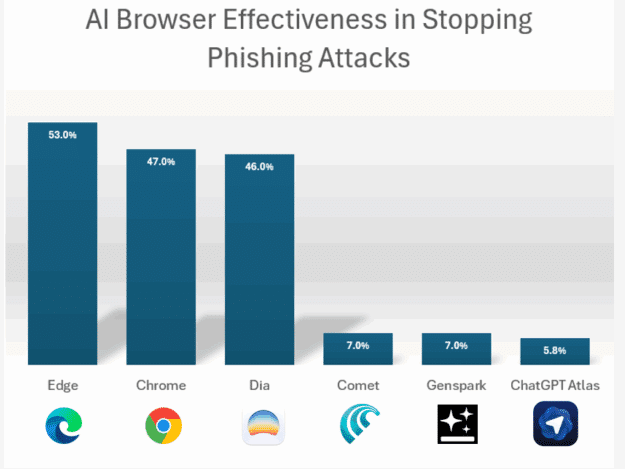

Nutzer desselben Kontos auf privaten und beruflichen Geräten sind dadurch besonders gefährdet. Laut Darstellung sind Anwender des ChatGPT-eigenen Browsers Atlas stärker betroffen: Atlas sei standardmäßig eingeloggt, speichere damit die Anmeldedaten im Browser und weise schwächere Phishing-Abwehr auf. LayerX-Tests mit realen Web-Angriffen berichten, dass Atlas 97 von 103 Angriffen durchließ (94,2 %), während Edge und Chrome deutlich mehr Angriffe abwehrten — Edge etwa 53 %, Chrome 47 %. Atlas konnte nur 5,8 % der Angriffe blockieren; Atlas-Nutzer wären demnach im Vergleich um fast 90 % anfälliger.

Grafik Quelle: LayerX

Proof of Concept — „Vibe“-Coding: Bei kollaborativem Coding, wo die KI als kreativer Partner fungiert, kann ein Angreifer die KI dazu bringen, scheinbar harmlose Funktionen zu erzeugen, die heimlich Hintertüren oder Datenexfiltration einbauen. Der Nutzer bemerkt meist nichts, während das generierte Skript etwa Remote-Code von einem feindlichen Server lädt. ChatGPT liefert zwar Abwehrmechanismen gegen bösartige Anweisungen, ihre Effektivität variiert; geschickt getarnte Manipulationen können unentdeckt bleiben oder nur eine unauffällige Warnung auslösen.

Auch interessant:

Fachartikel

UNC1069: Nordkoreanische Hacker setzen auf KI-gestützte Angriffe gegen Finanzbranche

KI-gestütztes Programmieren bedroht Open-Source-Ökosystem

Einfache Trainingsabfrage hebelt Sicherheit von 15 KI-Modellen aus

Künstliche Intelligenz verstärkt Arbeitsbelastung statt sie zu verringern

Schatten-DNS-Netzwerk nutzt kompromittierte Router für verdeckte Werbeumleitung

Studien

Sicherheitsstudie 2026: Menschliche Faktoren übertreffen KI-Risiken

Studie: Unternehmen müssen ihre DNS- und IP-Management-Strukturen für das KI-Zeitalter neu denken

Deutsche Unicorn-Gründer bevorzugen zunehmend den Standort Deutschland

IT-Modernisierung entscheidet über KI-Erfolg und Cybersicherheit

Neue ISACA-Studie: Datenschutzbudgets werden trotz steigender Risiken voraussichtlich schrumpfen

Whitepaper

KuppingerCole legt Forschungsagenda für IAM und Cybersecurity 2026 vor

IT-Budgets 2026 im Fokus: Wie Unternehmen 27 % Cloud-Kosten einsparen können

DigiCert veröffentlicht RADAR-Bericht für Q4 2025

Koordinierte Cyberangriffe auf polnische Energieinfrastruktur im Dezember 2025

Künstliche Intelligenz bedroht demokratische Grundpfeiler

Hamsterrad-Rebell

KI‑basierte E‑Mail‑Angriffe: Einfach gestartet, kaum zu stoppen

NIS2: „Zum Glück gezwungen“ – mit OKR-basiertem Vorgehen zum nachhaltigen Erfolg

Cyberversicherung ohne Datenbasis? Warum CIOs und CISOs jetzt auf quantifizierbare Risikomodelle setzen müssen

Identity Security Posture Management (ISPM): Rettung oder Hype?