Große Sprachmodelle schreiben heute einen erheblichen Teil des neuen Programmcodes – allein bei Python-Funktionen liegt der Anteil in führenden Regionen bei 30 Prozent. Doch Forscher des Israel Institute of Technology haben nun aufgedeckt, dass diese automatisierte Codegenerierung ein systematisches Sicherheitsproblem birgt: Die KI-Systeme reproduzieren dieselben fehlerhaften Muster immer wieder, was Angreifer gezielt ausnutzen können.

Wenn KI-Systeme immer die gleichen Fehler machen

Moderne Sprachmodelle haben sich als zentrale Werkzeuge in der Softwareentwicklung etabliert. Sie unterstützen beim Schreiben, Vervollständigen und Anpassen von Code über verschiedene Programmiersprachen und Anwendungsbereiche hinweg. Die schnelle Verbreitung dieser Technologie wird durch Leistungssteigerungen in Standard-Tests und die nahtlose Integration in Entwicklungsumgebungen vorangetrieben.

Die Kehrseite dieser Entwicklung: Während die Funktionalität der generierten Programme oft korrekt erscheint, enthält der Code häufig Sicherheitslücken. Diese Schwachstellen decken ein breites Spektrum bekannter Fehlertypen ab, die als Common Weakness Enumerations katalogisiert sind. Das grundlegende Problem liegt in der Art, wie die Modelle arbeiten – durch probabilistische Auswahl wiederholen sie oft ähnliche Codemuster, wodurch dieselben Fehler in vielen verschiedenen Programmen auftauchen.

Black-Box-Angriff ohne Zugang zum Quellcode

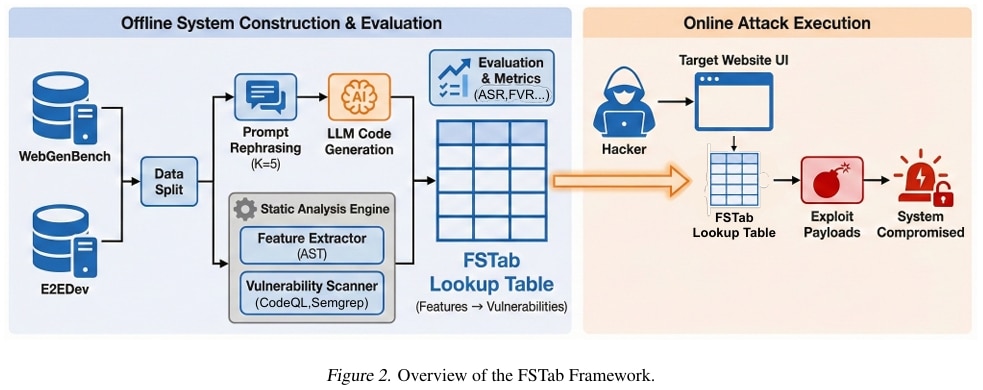

Das Forschungsteam hat mit der „Feature-Security Table“ (FSTab) eine Methode entwickelt, die diese Regelmäßigkeiten ausnutzt. Der Ansatz ermöglicht es, Sicherheitslücken im Backend einer Anwendung vorherzusagen, indem lediglich die sichtbaren Funktionen der Benutzeroberfläche analysiert werden – ohne Zugriff auf den zugrundeliegenden Code.

Die Methode beruht auf zwei Komponenten: Zunächst wird eine umfangreiche Datenbank erstellt, indem große Mengen an Code von einem bestimmten Modell generiert und auf Schwachstellen untersucht werden. Dabei werden sowohl die Sicherheitslücken als auch die sichtbaren Funktionsmerkmale erfasst. Diese Zuordnung ermöglicht es später, von beobachtbaren Merkmalen auf versteckte Schwachstellen zu schließen.

Bei einem Angriff muss lediglich bekannt sein, welches KI-Modell den Code erstellt hat.

Anhand der sichtbaren Funktionen einer Website oder Anwendung können dann die wahrscheinlichen Sicherheitslücken im Backend identifiziert werden, ohne dass eine Analyse des Quellcodes erforderlich ist.

Erfolgsquote von bis zu 94 Prozent

Die Wissenschaftler haben FSTab an aktuellen Code-Modellen getestet, darunter GPT-5.2, Claude-4.5 Opus und Gemini-3 Pro. Die Untersuchung erstreckte sich über verschiedene Anwendungsbereiche.

Die Resultate zeigen eine hohe Übertragbarkeit der Schwachstellenmuster: Selbst wenn der Zielbereich nicht Teil des Trainings war, erreichte die Angriffsmethode Erfolgsraten von bis zu 94 Prozent. Bei internen Werkzeugen, die mit Claude-4.5 Opus erstellt wurden, konnten 93 Prozent der Schwachstellen korrekt identifiziert werden.

Die Studie belegt, dass Schwachstellenmuster sowohl über verschiedene Anwendungsdomänen hinweg bestehen bleiben als auch modellspezifisch sind. Diese Persistenz entsteht, weil Sprachmodelle einer kleinen Gruppe standardisierter Vorlagen für gängige Funktionen eine hohe Wahrscheinlichkeit zuweisen. Ob es um das Löschen von Elementen oder die Benutzeranmeldung geht – dieselben fehlerhaften Designentscheidungen tauchen über verschiedene Eingaben und Bereiche hinweg wieder auf.

Neue Angriffsfläche in automatisiert erstellter Software

Bisherige Ansätze zur Sicherheit von KI-generiertem Code konzentrieren sich hauptsächlich auf nachträgliche Schutzmaßnahmen. Statische Analyseprogramme, Schwachstellen-Benchmarks und Testverfahren prüfen den generierten Code jeweils isoliert. Diese Methoden erkennen zwar Fehler effektiv, berücksichtigen aber nicht die programmübergreifenden Regelmäßigkeiten, die durch das generierende Modell entstehen.

Diese Lücke ermöglicht die weiträumige Erzeugung von vorhersagbarem, unsicherem Code. Die Forschungsarbeit deckt damit eine bisher wenig untersuchte Angriffsfläche auf: Die Sicherheitsrisiken entstehen nicht aus einzelnen Eingaben oder spezifischen Anwendungsfällen, sondern aus systematischen Verzerrungen auf Modellebene.

Bewertungsrahmen für modellintrinsische Risiken

Neben der Angriffsmethode haben die Forscher einen Bewertungsrahmen entwickelt, der quantifiziert, wie konsistent ein bestimmtes Modell dieselbe Art von Schwachstellen reproduziert. Die Metriken messen die Persistenz über verschiedene Programme, semantisch gleichwertige Umformulierungen und Anwendungsbereiche hinweg.

Dieser modellzentrierte Ansatz ermöglicht einen direkten Vergleich verschiedener Systeme hinsichtlich ihrer Neigung, wiederkehrende Fehlermuster zu erzeugen. Die Bewertung zeigt, dass die Schwachstellenprofile charakteristisch für einzelne Modelle sind – ähnlich wie ein Fingerabdruck stabile, identifizierbare Signaturen in den Ausgaben hinterlassen.

Defensive Anwendung und Einschränkungen

Die primäre Zielsetzung der Arbeit ist defensiver Natur. Das Framework soll proaktive Sicherheitsüberprüfungen, modellzentrierte Risikobewertungen und funktionsabhängige Tests von KI-generiertem Code unterstützen. Entwickler können damit risikoreiche Funktionen vor der Veröffentlichung priorisieren.

Die Forscher weisen darauf hin, dass ihre Analyse auf automatisierter Merkmalserkennung und statischen Analysewerkzeugen beruht, was zu Fehleinschätzungen führen kann. Die Ergebnisse sollten daher als Risikosignale interpretiert werden, wobei kritische Befunde durch manuelle Überprüfung validiert werden sollten.

Implikationen für die Softwareentwicklung

Mit etwa 30 Prozent KI-generierten Python-Funktionen in führenden Regionen hat die automatisierte Codeerstellung bereits erhebliche Verbreitung erreicht. Die Studienergebnisse legen nahe, dass mit dieser Entwicklung eine stabile Angriffsfläche über verschiedene Kontexte hinweg entsteht.

Die Autoren empfehlen mehrere Gegenmaßnahmen: Die Verringerung der Template-Starrheit in Modellen, die Integration sicherheitsrelevanter Ziele während des Trainings oder der Textgenerierung sowie die Entwicklung von Benchmarks, die die Persistenz von Schwachstellen statt isolierter Fehler messen.

Die Forschungsarbeit soll zu sicherheitsorientierten Bewertungsstrategien für Codegenerierungsmodelle beitragen und die Diskussion über den verantwortungsvollen Einsatz von Sprachmodellen in der großflächigen Softwareentwicklung fördern.

Quelle: Tomer Kordonsky, Maayan Yamin, Noam Benzimra, Amit LeVi, Avi Mendelson – Israel Institute of Technology. Veröffentlicht auf arXiv

Entdecke mehr

Fachartikel

KI-Modelle entdecken kritische Sicherheitslücken in jahrzehntealter Software

KI-generierter Code folgt gefährlichen Mustern: Forscher entwickeln Angriffsmethode FSTab

DDoS-Attacken 2025: Rekordangriff mit 31,4 Tbit/s und 121% mehr Angriffe

SonicWall-VPN-Einbruch: Angreifer deaktivieren EDR über Kernel-Ebene mit widerrufenen Treibern

OpenClaw-Skills als neuer Malware-Verteilweg: Erkenntnisse von VirusTotal

Studien

Sicherheitsstudie 2026: Menschliche Faktoren übertreffen KI-Risiken

Studie: Unternehmen müssen ihre DNS- und IP-Management-Strukturen für das KI-Zeitalter neu denken

Deutsche Unicorn-Gründer bevorzugen zunehmend den Standort Deutschland

IT-Modernisierung entscheidet über KI-Erfolg und Cybersicherheit

Neue ISACA-Studie: Datenschutzbudgets werden trotz steigender Risiken voraussichtlich schrumpfen

Whitepaper

IT-Budgets 2026 im Fokus: Wie Unternehmen 27 % Cloud-Kosten einsparen können

DigiCert veröffentlicht RADAR-Bericht für Q4 2025

Koordinierte Cyberangriffe auf polnische Energieinfrastruktur im Dezember 2025

Künstliche Intelligenz bedroht demokratische Grundpfeiler

Insider-Risiken in Europa: 84 Prozent der Hochrisiko-Organisationen unzureichend vorbereitet

Hamsterrad-Rebell

KI‑basierte E‑Mail‑Angriffe: Einfach gestartet, kaum zu stoppen

NIS2: „Zum Glück gezwungen“ – mit OKR-basiertem Vorgehen zum nachhaltigen Erfolg

Cyberversicherung ohne Datenbasis? Warum CIOs und CISOs jetzt auf quantifizierbare Risikomodelle setzen müssen

Identity Security Posture Management (ISPM): Rettung oder Hype?