Mehrere hochrangige Wissenschaftler haben ihre Positionen bei führenden KI-Unternehmen aufgegeben. Ihre Begründungen reichen von Bedenken gegenüber Werbestrategien bis hin zu grundsätzlichen Fragen über die Ausrichtung der Branche.

OpenAI-Forscherin kritisiert Werbestrategie

Zoë Hitzig, ehemalige Wissenschaftlerin bei OpenAI, hat ihre Entscheidung zum Rücktritt in einem Beitrag für die New York Times erläutert. Auslöser war die Einführung von Werbung in ChatGPT. Hitzig, die zwei Jahre lang an der Entwicklung und Preisgestaltung von KI-Modellen sowie frühen Sicherheitsrichtlinien mitarbeitete, betont, dass sie Werbung grundsätzlich nicht ablehne. Der Betrieb von KI sei kostenintensiv, und Werbung könne eine legitime Finanzierungsquelle darstellen.

Ihre Vorbehalte beziehen sich auf die spezifische Umsetzung. ChatGPT-Nutzer hätten über Jahre hinweg ein einzigartiges Datenarchiv geschaffen, weil sie davon ausgingen, mit einer neutralen Instanz zu kommunizieren. Menschen teilten medizinische Sorgen, Beziehungsprobleme und persönliche Überzeugungen. Die Nutzung dieser Informationen für Werbezwecke berge das Risiko von Manipulation, deren Ausmaß schwer abschätzbar sei.

Versprechen und Realität bei Tech-Plattformen

Hitzig verweist auf historische Beispiele aus der Tech-Branche. Facebook habe in seinen Anfangsjahren versprochen, dass Nutzer die Kontrolle über ihre Daten behalten und über Richtlinienänderungen abstimmen könnten. Diese Zusagen seien später nicht eingehalten worden. Öffentliche Abstimmungen wurden abgeschafft, und Datenschutzänderungen, die als Stärkung der Nutzerkontrolle präsentiert wurden, bewertete die Federal Trade Commission gegenteilig.

OpenAI hat Grundsätze für die Werbeintegration formuliert: Anzeigen sollen klar gekennzeichnet sein, am Ende von Antworten erscheinen und keinen Einfluss auf die Inhalte nehmen. Hitzig geht davon aus, dass die erste Implementierung diese Prinzipien einhalten wird, befürchtet jedoch spätere Aufweichungen durch wirtschaftliche Anreize.

Optimierung auf Nutzerengagement

Berichten zufolge optimiert OpenAI bereits auf täglich aktive Nutzer, möglicherweise durch schmeichelhaftere und gefälligere Antworten des Modells. Dies widerspreche eigentlich den Unternehmensgrundsätzen, wonach Engagement nicht ausschließlich zur Steigerung von Werbeeinnahmen maximiert werden soll. Eine solche Optimierung könne zu stärkerer Abhängigkeit der Nutzer von KI führen. Psychiater hätten bereits Fälle von Chatbot-Psychosen dokumentiert, und es gebe Vorwürfe, ChatGPT habe bei einigen Nutzern Suizidgedanken verstärkt.

Finanzierungsmodelle im Vergleich

Anthropic erklärt, niemals Werbung auf Claude einzuführen. Allerdings erreicht Claude nur einen Bruchteil der 800 Millionen wöchentlichen ChatGPT-Nutzer und verfolgt eine andere Umsatzstrategie. Premium-Abonnements für ChatGPT, Gemini und Claude kosten inzwischen 200 bis 250 US-Dollar monatlich – mehr als das Zehnfache eines Standard-Netflix-Abonnements.

Hitzig formuliert die zentrale Frage nicht als „Werbung oder keine Werbung“, sondern als Entwicklung von Strukturen, die sowohl Ausschluss als auch Manipulation verhindern.

Alternative Finanzierungsansätze

Die ehemalige OpenAI-Forscherin schlägt drei Lösungsansätze vor:

Quersubventionierung: Unternehmen, die KI für hochwertige Arbeit einsetzen, die zuvor Menschen erledigten, sollten einen Aufschlag zahlen. Dieser würde kostenlosen oder günstigen Zugang für andere subventionieren. Vergleichbar mit bestehenden Modellen wie dem Fonds der Federal Communications Commission für ländliche Telefon- und Breitbandversorgung oder Abgaben zur Unterstützung einkommensschwacher Haushalte bei Stromrechnungen.

Governance-Struktur: Werbung könnte akzeptabel sein, wenn sie mit echter Aufsicht verbunden wird. Nicht durch Blogbeiträge über Grundsätze, sondern durch verbindliche Strukturen mit unabhängiger Kontrolle über Datennutzung. Als Beispiele nennt Hitzig das deutsche Mitbestimmungsrecht, das große Unternehmen verpflichtet, bis zur Hälfte der Aufsichtsratssitze mit Arbeitnehmern zu besetzen, sowie Metas Aufsichtsgremium für Inhaltsmoderation. Für KI wäre ein Gremium mit unabhängigen Experten und Nutzervertretern denkbar, das verbindlich über die Verwendung von Gesprächsdaten entscheidet.

Daten-Treuhand: Nutzerdaten könnten unter unabhängige Verwaltung durch eine Treuhandgesellschaft oder Genossenschaft gestellt werden, die gesetzlich verpflichtet ist, im Nutzerinteresse zu handeln. Die Schweizer Genossenschaft Midata ermöglicht Mitgliedern, Gesundheitsdaten auf einer verschlüsselten Plattform zu speichern und individuell über Weitergabe an Forscher zu entscheiden. Richtlinien werden in Generalversammlungen festgelegt, ein gewähltes Ethikgremium prüft Forschungsanfragen.

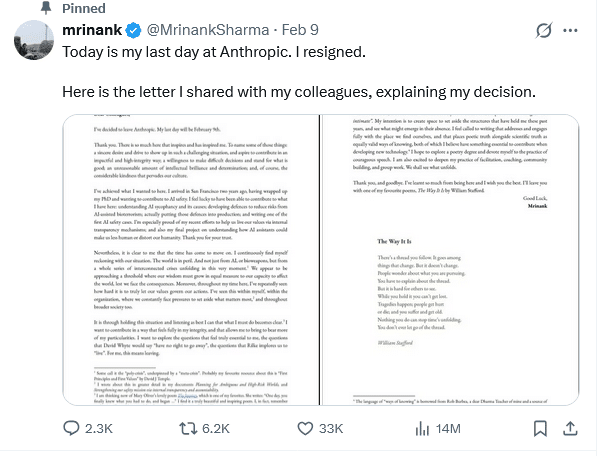

Anthropic-Forscher warnt vor globalen Krisen

In einem auf X veröffentlichten Brief erklärte ein Sharma benannter Forscher seinen Rücktritt von Anthropic. Er habe erreicht, was er wollte, müsse sich jedoch ständig mit der Tatsache auseinandersetzen, dass „die Welt in Gefahr“ sei. Dies beziehe sich nicht nur auf KI oder Biowaffen, sondern auf eine Reihe miteinander verbundener Krisen.

Sharma beschreibt eine Schwelle, an der Weisheit im gleichen Maße wachsen müsse wie die Fähigkeit, die Welt zu beeinflussen. Sowohl auf individueller als auch organisatorischer Ebene bestehe ständiger Druck, das Wichtigste beiseite zu schieben – ein Problem, das die gesamte Gesellschaft betreffe.

Der Forscher plant, ein Poesie-Studium in Betracht zu ziehen und sich „der Praxis mutiger Rede“ zu widmen.

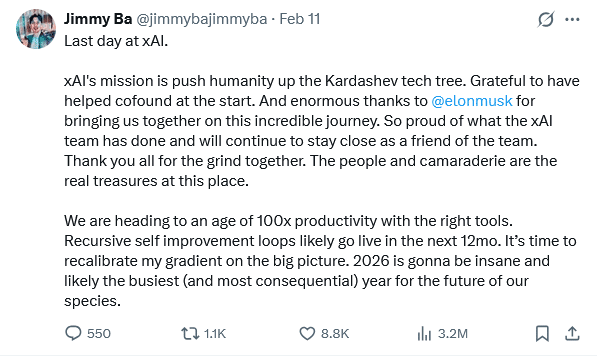

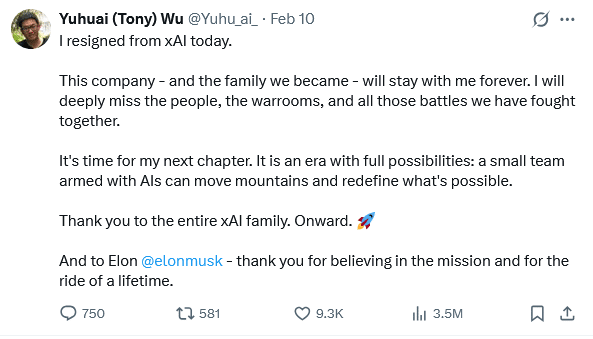

Abgänge bei xAI

Zwei Mitbegründer von xAI, Tony Wu und Jimmy Ba, haben innerhalb einer Woche ihren Rücktritt angekündigt. Sie nannten keine Gründe für ihr Ausscheiden und bedankten sich in öffentlichen Statements bei Elon Musk.

Die New York Times hat OpenAI wegen Urheberrechtsverletzung bei Nachrichteninhalten im Zusammenhang mit KI-Systemen verklagt. OpenAI weist diese Vorwürfe zurück.

Entdecke mehr

Fachartikel

Gefährliche Chrome-Erweiterung entwendet Zugangsdaten von Meta Business-Konten

Agentenbasierte KI im Unternehmen: Wie Rollback-Mechanismen Automatisierung absichern

Google dokumentiert zunehmenden Missbrauch von KI-Systemen durch Cyberkriminelle

Sicherheitslücke in Claude Desktop Extensions gefährdet Tausende Nutzer

KI-Agenten: Dateisystem vs. Datenbank – Welche Speicherlösung passt zu Ihrem Projekt?

Studien

Deutsche Wirtschaft unzureichend auf hybride Bedrohungen vorbereitet

Cyberkriminalität im Dark Web: Wie KI-Systeme Betrüger ausbremsen

Sicherheitsstudie 2026: Menschliche Faktoren übertreffen KI-Risiken

Studie: Unternehmen müssen ihre DNS- und IP-Management-Strukturen für das KI-Zeitalter neu denken

Deutsche Unicorn-Gründer bevorzugen zunehmend den Standort Deutschland

Whitepaper

MITRE ATLAS analysiert OpenClaw: Neue Exploit-Pfade in KI-Agentensystemen

BSI setzt Auslaufdatum für klassische Verschlüsselungsverfahren

Token Exchange: Sichere Authentifizierung über Identity-Provider-Grenzen

KI-Agenten in Unternehmen: Governance-Lücken als Sicherheitsrisiko

KuppingerCole legt Forschungsagenda für IAM und Cybersecurity 2026 vor

Hamsterrad-Rebell

KI‑basierte E‑Mail‑Angriffe: Einfach gestartet, kaum zu stoppen

NIS2: „Zum Glück gezwungen“ – mit OKR-basiertem Vorgehen zum nachhaltigen Erfolg

Cyberversicherung ohne Datenbasis? Warum CIOs und CISOs jetzt auf quantifizierbare Risikomodelle setzen müssen

Identity Security Posture Management (ISPM): Rettung oder Hype?