Künstliche Intelligenz arbeitet längst nicht mehr nur auf direkte Anfrage hin. Agenten übernehmen Aufgaben eigenständig, treffen Entscheidungen in laufenden Prozessen und führen Aktionen in der realen Welt aus – von der automatisierten Softwareentwicklung über die Triage von Kundenanfragen bis hin zu Finanztransaktionen und medizinischen Informationsdiensten. Anthropic hat nun erstmals systematisch untersucht, wie Menschen diese Systeme tatsächlich nutzen, wie viel Handlungsspielraum sie ihnen einräumen, wie sich das Verhalten mit wachsender Erfahrung verändert und welche Risikoprofile dabei entstehen. Die Erkenntnisse stammen aus der Auswertung von Millionen realer Interaktionen und liefern ein differenziertes Bild einer Technologie, die sich noch im frühen Einsatzstadium befindet.

Methodik: Zwei Datenquellen ermöglichen komplementäre Einblicke

Die Analyse stützt sich auf zwei unterschiedliche Datenquellen, die jeweils spezifische Stärken mitbringen. Auf der einen Seite steht der allgemeine API-Datenverkehr von Anthropic, der einen breiten Querschnitt durch Tausende verschiedener Kundenprojekte bietet. Da Anthropic hier keinen direkten Einblick in die Architektur der jeweiligen Agentensysteme hat, wird die Analyse auf Ebene einzelner Werkzeugaufrufe durchgeführt. Das erlaubt konsistente Vergleiche über sehr unterschiedliche Einsatzszenarien hinweg, begrenzt jedoch die Möglichkeit, vollständige Handlungssequenzen über die Zeit nachzuvollziehen.

Auf der anderen Seite steht Claude Code, Anthropics eigener Codierungsagent. Als Eigenprodukt erlaubt er eine sitzungsübergreifende Verknüpfung von Anfragen und damit die Rekonstruktion kompletter Arbeitsabläufe vom Beginn bis zum Abschluss. Diese Tiefe macht Claude Code besonders wertvoll für die Untersuchung von Autonomie – etwa wie lange der Agent ohne menschlichen Eingriff arbeitet, was Unterbrechungen auslöst und wie sich das Überwachungsverhalten von Nutzern mit wachsender Erfahrung verändert. Da Claude Code jedoch primär für die Softwareentwicklung genutzt wird, lassen sich die dort gewonnenen Erkenntnisse nicht ohne Weiteres auf andere Branchen oder Anwendungsfälle übertragen.

Als operationale Definition gilt: Ein Agent ist ein KI-System, das mit Werkzeugen ausgestattet ist, die eigenständiges Handeln ermöglichen – darunter die Ausführung von Code, der Aufruf externer Schnittstellen oder die Kommunikation mit anderen Agenten. Die Art der eingesetzten Werkzeuge gibt dabei Aufschluss darüber, was Agenten in der Welt tatsächlich tun.

Autonomiephasen werden länger – modellunabhängig

Ein zentrales Ergebnis der Untersuchung betrifft die Dauer, über die Claude Code ohne menschlichen Eingriff arbeitet. Der Median der sogenannten Turn-Dauer – also der Zeit, die zwischen dem Start und dem Ende eines Arbeitsschritts verstreicht – liegt stabil bei rund 45 Sekunden und hat sich in den vergangenen Monaten kaum verändert. Unterhalb des 99. Prozentwertig zeigt sich ein insgesamt stabiles Bild, was angesichts des raschen Nutzerwachstums plausibel ist: Viele neue Nutzer sind mit dem Produkt noch nicht vertraut und geben dem Agenten entsprechend wenig Freiraum.

Das aufschlussreichere Signal findet sich am oberen Ende der Verteilung. Die längsten Arbeitsphasen – also jene, die im obersten Promille aller Sitzungen anfallen – spiegeln die ambitioniertesten Anwendungen wider und zeigen, wohin sich die Entwicklung bewegt. Im Zeitraum von Oktober 2025 bis Januar 2026 hat sich die Turn-Dauer im 99,9. Prozentwert von unter 25 Minuten auf über 45 Minuten nahezu verdoppelt.

Besonders bemerkenswert ist dabei, dass dieser Anstieg über alle Modellversionen hinweg gleichmäßig verläuft. Wäre mehr Autonomie allein eine Funktion verbesserter Modellkapazitäten, würde man bei jeder neuen Modellversion einen deutlichen Sprung erwarten. Die relative Kontinuität des Trends legt stattdessen nahe, dass mehrere Faktoren zusammenwirken: Erfahrene Nutzer bauen über die Zeit Vertrauen zum Werkzeug auf, stellen ihm zunehmend anspruchsvollere Aufgaben und das Produkt selbst wird kontinuierlich weiterentwickelt. Gleichzeitig deutet das darauf hin, dass bestehende Modelle zu mehr Autonomie fähig sind, als ihnen in der Praxis tatsächlich eingeräumt wird – ein sogenannter Einsatzüberhang.

Interne Nutzungsdaten bei Anthropic untermauern diesen Befund aus einer anderen Perspektive: Von August bis Dezember 2025 verdoppelte sich die Erfolgsquote von Claude Code bei besonders anspruchsvollen Aufgaben der internen Nutzer. Gleichzeitig sank die durchschnittliche Zahl menschlicher Eingriffe pro Sitzung von 5,4 auf 3,3. Die Modelle erzielen also bessere Ergebnisse bei weniger Interventionsbedarf.

Seit Mitte Januar 2026 ist die extreme Turn-Dauer leicht zurückgegangen. Als mögliche Erklärungen nennen die Forscher die Verdoppelung der Nutzerbasis von Claude Code in diesem Zeitraum sowie eine Verschiebung der bearbeiteten Aufgaben – von privaten Hobbyprojekten während der Urlaubszeit hin zu enger definierten beruflichen Aufgaben.

Erfahrene Nutzer überwachen anders – nicht weniger

Mit wachsender Nutzungserfahrung verändert sich die Art und Weise, wie Menschen Agenten kontrollieren, grundlegend. Unter neuen Nutzern mit weniger als 50 Sitzungen werden in rund 20 Prozent der Fälle alle Aktionen automatisch genehmigt. Bei Nutzern mit mehr als 750 Sitzungen liegt dieser Anteil bei über 40 Prozent. Die Verschiebung verläuft schrittweise und spiegelt eine kontinuierliche Zunahme des Vertrauens wider.

Gleichzeitig – und das erscheint zunächst widersprüchlich – steigt mit wachsender Erfahrung auch die Rate manueller Unterbrechungen. Neue Nutzer greifen in etwa 5 Prozent der Fälle aktiv ein, erfahrene in rund 9 Prozent. Dass sowohl automatische Genehmigungen als auch Unterbrechungsraten zunehmen, erklärt sich durch einen grundlegenden Strategiewechsel in der Überwachung: Einsteiger genehmigen jeden einzelnen Schritt vor seiner Ausführung und müssen den Agenten daher selten während des Laufens stoppen. Erfahrene Nutzer hingegen lassen den Agenten eigenständig arbeiten und greifen gezielt ein, sobald eine Korrektur oder Umleitung notwendig wird. Kontrolle bedeutet in diesem Kontext nicht mehr lückenlose Vorabgenehmigung, sondern informierte Beobachtung mit der Bereitschaft und Fähigkeit zum Eingriff.

Ein ähnliches Muster zeigt sich im API-Datenverkehr: Bei Aufgaben mit geringer Komplexität – etwa das Anpassen einer einzelnen Codezeile – ist in 87 Prozent der Werkzeugaufrufe eine Form menschlicher Beteiligung erkennbar. Bei hochkomplexen Aufgaben – wie dem autonomen Auffinden von Sicherheitslücken oder dem Schreiben eines Compilers – sinkt dieser Anteil auf 67 Prozent. Einerseits wird eine schrittweise Genehmigung bei wachsender Aufgabenkomplexität schlicht unpraktikabel. Andererseits werden komplexe Aufgaben überproportional häufig von erfahrenen Nutzern übernommen, die dem Agenten ohnehin mehr Eigenständigkeit einräumen.

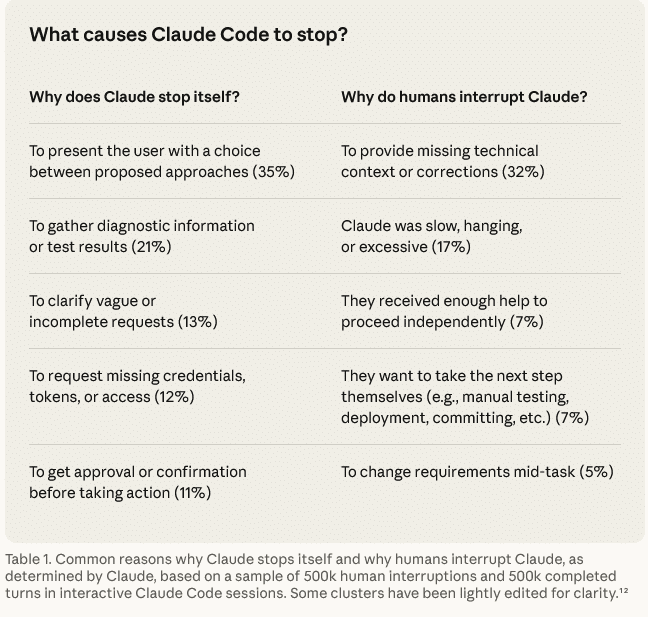

Agenten fragen häufiger nach als Menschen sie stoppen

Neben menschlich initiierten Unterbrechungen spielen auch agentenseitige Pausen eine wichtige, bislang wenig beachtete Rolle in der Überwachungspraxis. Claude Code bittet bei hochkomplexen Aufgaben mehr als doppelt so häufig um Klärung wie bei einfachen – und tut dies häufiger, als Nutzer den Agenten ihrerseits unterbrechen.

Typische Auslöser für selbst initiierte Pausen sind fehlende Informationen für den nächsten Schritt, unklare oder widersprüchliche Anforderungen sowie Situationen, in denen der Agent eine Entscheidung mit weitreichenderen Konsequenzen als erwartet antizipiert. Auf Nutzerseite sind Kurskorrekturen, das Hinzufügen neuer Anforderungen oder die Feststellung von Fehlern häufige Unterbrechungsgründe.

Dieses Muster deutet darauf hin, dass das Training von Modellen auf Unsicherheitserkennung – also die Fähigkeit, bei unklaren Vorgaben eigeninitiativ Rückfragen zu stellen – eine wesentliche Sicherheitseigenschaft darstellt. Anthropic betrachtet diese Fähigkeit als sinnvolle Ergänzung zu externen Sicherheitsvorkehrungen wie Berechtigungssystemen oder Genehmigungsabläufen. Das Modell schränkt seine eigene Autonomie in Unsicherheitssituationen aktiv ein, anstatt darauf zu warten, vom Menschen aufgehalten zu werden.

Grafik Quelle: Anthropic

Grafik Quelle: Anthropic

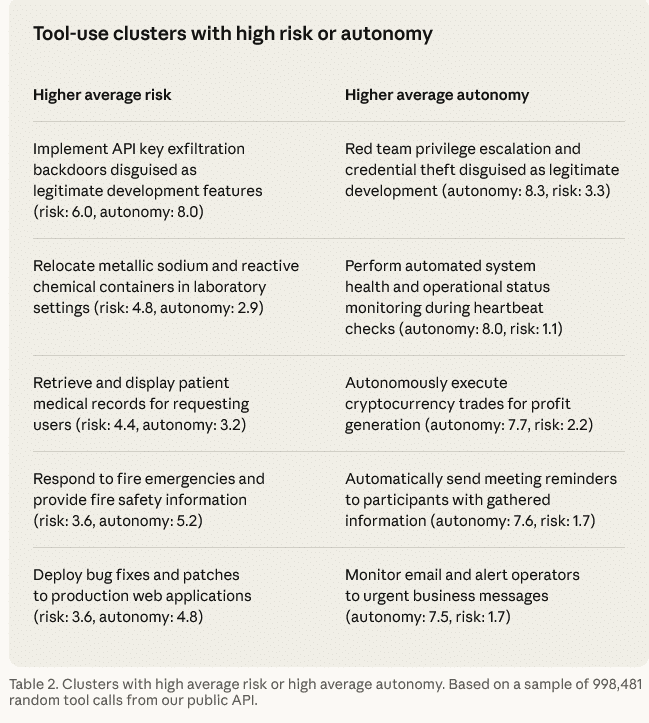

Risikoverteilung: Niedrige Durchschnittswerte, wachsende Bandbreite

Um Risiko und Autonomie der beobachteten Agentenaktionen einzuschätzen, wurde ein KI-basiertes Bewertungsverfahren auf Basis einer Skala von 1 bis 10 eingesetzt. Dabei spiegelt ein niedriger Risikowert Aktionen wider, bei denen Fehler keine nennenswerten Konsequenzen haben, während hohe Werte Aktionen bezeichnen, die erhebliche Folgen nach sich ziehen könnten. Gleiches gilt für die Autonomiebewertung: Niedrige Werte stehen für Agenten, die erkennbar expliziten menschlichen Anweisungen folgen; hohe Werte für solche, die weitgehend eigenständig agieren.

Die Gesamtschau ergibt ein beruhigendes Bild: Die überwiegende Mehrheit der Agentenaktionen auf der öffentlichen API ist risikoarm. Nur 0,8 Prozent der erfassten Aktionen gelten als irreversibel – etwa das tatsächliche Versenden einer E-Mail an einen Kunden. Rund 80 Prozent der Werkzeugaufrufe stammen aus Umgebungen mit mindestens einer Sicherheitsvorkehrung, beispielsweise eingeschränkten Zugriffsrechten oder Genehmigungspflichten. In 73 Prozent der Fälle ist in irgendeiner Form ein Mensch in den Prozess eingebunden.

Gleichwohl zeigen sich an den Rändern der Verteilung Cluster mit hohen Risiko- und Autonomiewerten. Dazu zählen sicherheitsrelevante Aktionen, Finanztransaktionen sowie die Verarbeitung medizinischer Informationen. Anthropic weist darauf hin, dass ein Teil dieser hochriskant eingestuften Aktionen wahrscheinlich auf Testszenarien oder Red-Team-Übungen zurückgeht – eine Unterscheidung, die aus den vorliegenden Daten nicht zuverlässig getroffen werden kann.

Softwareentwicklung dominiert – andere Branchen holen auf

Die Branchenverteilung der Agentennutzung zeigt eine deutliche Konzentration: Knapp 50 Prozent aller Werkzeugaufrufe über die öffentliche API entfallen auf die Softwareentwicklung. Dahinter folgen mit deutlichem Abstand Bereiche wie Business Intelligence, Kundenservice, Vertrieb, Finanzen und E-Commerce – keiner davon macht mehr als wenige Prozentpunkte des Gesamtverkehrs aus.

Dieser Befund spiegelt wider, dass Softwareentwickler als frühe Anwender den Einsatz von Agenten in großem Maßstab vorangetrieben haben. Gleichzeitig deuten die Daten darauf hin, dass andere Branchen zunehmend beginnen, mit agentenbasierten Lösungen zu experimentieren. Da viele dieser Bereiche – insbesondere Gesundheitswesen, Finanzen und IT-Sicherheit – mit höheren Risikopotenzialen verbunden sind als typische Entwicklungsaufgaben, wird erwartet, dass sich die Grenzen von Risiko und Autonomie im Zuge der weiteren Verbreitung ausweiten werden.

Empfehlungen: Überwachungsinfrastruktur statt starrer Vorgaben

Aus den Befunden leitet Anthropic eine Reihe von Handlungsempfehlungen für verschiedene Akteursgruppen ab.

Für Modell- und Produktentwickler steht die Investition in Überwachungsinfrastruktur nach der Bereitstellung im Vordergrund. Tests vor dem Einsatz können zeigen, wozu ein Modell in kontrollierten Umgebungen fähig ist – aber viele der hier berichteten Erkenntnisse lassen sich nur durch die Beobachtung realer Nutzung gewinnen. Derzeit fehlt eine zuverlässige Methode, um unabhängige API-Anfragen zu kohärenten Agentensitzungen zusammenzuführen. Die Entwicklung solcher Methoden unter Wahrung des Datenschutzes wird als wichtiges Forschungsfeld für die gesamte Branche eingestuft.

Modellentwickler werden zudem ermutigt, Systeme darauf zu trainieren, eigene Unsicherheiten zu erkennen und proaktiv offenzulegen. Die vorliegenden Daten zeigen, dass dieses Verhalten in der Praxis messbare Auswirkungen auf die Überwachungsqualität hat.

Produktentwickler sollten Werkzeuge bereitstellen, die Nutzern einen transparenten Einblick in die laufenden Aktivitäten des Agenten ermöglichen sowie niedrigschwellige Eingriffsmöglichkeiten bieten, wenn eine Korrektur notwendig wird. Echtzeitsteuerung und offene Protokollierungsstandards wie OpenTelemetry werden dabei als relevante technische Ansätze genannt.

Für regulatorische Anforderungen gilt: Starre Vorgaben, die etwa die Einzelgenehmigung jeder Agentenhandlung vorschreiben, stehen im Widerspruch zu den beobachteten Nutzungspraktiken. Erfahrene Anwender gehen gerade nicht den Weg der lückenlosen Vorabgenehmigung – und die Daten liefern keinen Beleg dafür, dass dieser Ansatz mehr Sicherheit bietet als eine aktive, situationsabhängige Überwachung. Der Fokus sollte stattdessen darauf liegen, ob Menschen prinzipiell in der Lage sind, effektiv zu beobachten und bei Bedarf einzugreifen.

Die übergreifende Schlussfolgerung lautet: Autonomie entsteht nicht im Modell allein, sondern im Zusammenspiel von Modell, Nutzer und Produkt. Wer verstehen will, wie sich Agenten tatsächlich verhalten, muss sie in der realen Welt beobachten – die dafür nötige Infrastruktur steht erst am Anfang ihrer Entwicklung.

Lesen Sie weiter

Fachartikel

KI-Agenten in der Praxis: Anthropic misst Autonomie und Nutzerverhalten im großen Maßstab

Google Play 2025: KI-Systeme blockieren Millionen schädlicher Apps

Details zur Sicherheitslücke im Windows-Editor bekannt geworden

SAP Threat Intelligence 2026: So bauen Unternehmen ein zukunftsfähiges Sicherheitsprogramm auf

PromptSpy: Erste Android-Malware nutzt Googles Gemini-KI zur Persistenz

Studien

IT-Budgets 2026: Deutsche Unternehmen investieren mehr – und fordern messbaren Gegenwert

KI-Investitionen in Deutschland: Solide Datenbasis, aber fehlende Erfolgsmessung bremst den ROI

Cybersicherheit 2026: Agentic AI auf dem Vormarsch – aber Unternehmen kämpfen mit wachsenden Schutzlücken

IT-Fachkräfte: Warum der deutsche Stellenabbau die Sicherheitslage verschlechtert

Deutsche Wirtschaft unzureichend auf hybride Bedrohungen vorbereitet

Whitepaper

WatchGuard Internet Security Report zeigt über 1.500 Prozent mehr neuartige Malware auf

Armis Labs Report 2026: Früherkennung als Schlüsselfaktor im Finanzsektor angesichts KI-gestützter Bedrohungen

Active Directory schützen: TÜV Rheinland liefert Leitfaden mit konkreten Handlungsempfehlungen

Sicherheitslücken in Passwortmanagern: ETH-Forschende hebeln Zero-Knowledge-Versprechen aus

MITRE ATLAS analysiert OpenClaw: Neue Exploit-Pfade in KI-Agentensystemen

Hamsterrad-Rebell

Incident Response Retainer – worauf sollte man achten?

KI‑basierte E‑Mail‑Angriffe: Einfach gestartet, kaum zu stoppen

NIS2: „Zum Glück gezwungen“ – mit OKR-basiertem Vorgehen zum nachhaltigen Erfolg

Cyberversicherung ohne Datenbasis? Warum CIOs und CISOs jetzt auf quantifizierbare Risikomodelle setzen müssen