Autonome KI-Systeme übernehmen in Smart Grids, Industrieanlagen und Fahrzeugen immer mehr Aufgaben – doch genau dort, wo digitale Intelligenz auf die physische Welt trifft, entstehen Angriffsflächen, die herkömmliche Sicherheitskonzepte nicht mehr abdecken. Generative KI-Modelle machen es möglich, Sensordaten, Videoströme oder Sprachbefehle so überzeugend nachzubilden, dass weder Maschinen noch Menschen sie mühelos durchschauen können.

Eine neue Studie von Mohsen Hatami, Van Tuan Pham, Hozefa Lakadawala und Yu Chen der Binghamton University untersucht genau diese Schnittstelle und argumentiert, dass eine auf Erkennung ausgerichtete Verteidigung langfristig nicht ausreicht. Stattdessen sei ein systemweiter Ansatz nötig, der Herkunftsverifikation und physikalische Vertrauensmechanismen von der Konzeptionsstufe an in die Architektur einbettet.

Neue Bedrohungen an der Schnittstelle zwischen KI und physischer Umwelt

Die Einbettung von KI-Agenten in cyber-physische Systeme (CPS) erzeugt eine Verschmelzung von digitaler Verarbeitung und greifbaren Umwelteinflüssen. Diese Agenten sind mit Wahrnehmungs-, Entscheidungs- und Handlungsfähigkeiten ausgestattet und arbeiten unter anderem in Smart Grids, autonomen Fahrzeugen und industriellen Automatisierungssystemen ein. Die Kommunikation zwischen einem solchen Agenten und seiner Umgebung – also die sogenannte Agent-Environment-Schnittstelle – wird damit zu einem attraktiven Ziel für gezielte Manipulationen.

Traditionelle CPS-Sicherheitsforschung hat sich bisher hauptsächlich auf bekannte Angriffsformen konzentriert: Sensor-Spoofing, Denial-of-Service-Attacken und Insider-Bedrohungen. Mit der Reife generativer KI-Modelle rückt aber eine neue Kategorie in den Vordergrund: KI-generierte Inhalte, kurz AIGC. Diese umfassen synthetische Bilder, Videos, Audiodateien, Texte und sogar Verhaltensimitationen. Sie können sich als legitime Umweltdaten oder autorisierte Befehle tarnen und damit sowohl automatisierte Systeme als auch menschliche Bediener in die Irre führen.

Ein Deepfake-Videofeed könnte z. B. Überwachungskameras täuschen, eine nachgeahmte Stimme könnte sich als autorisierter Operator ausgeben, oder gefälschte Sensorspuren könnten eine reale physikalische Anomalie verschleiern. Die Konsequenzen bleiben damit nicht mehr auf den Cyberraum beschränkt – sie wirken sich direkt auf physische Prozesse aus.

Was diese Bedrohungen besonders schwer greifbar macht, ist die nahtlose Verschmelzung digitaler Fälschung mit physischen Auswirkungen. Ein manipulierter Videofeed oder ein geklonter Sprachbefehl kann nicht nur Fehlinformationen erzeugen, sondern auch physisch unsichere Handlungen auslösen oder Anomalien im Betrieb verbergen. Die traditionelle Unterscheidung zwischen einem Cyber- und einem physischen Angriff wird damit zunehmend obsolet – was die Verteidiger vor einem Paradigmenwechsel steht, auf den herkömmliche Erkennungsverfahren nicht zugeschnitten sind.

Das Model Context Protocol als erweiterte Angriffsfläche

Ein weiterer Faktor, der die Risikosituation verschärft, ist das Model Context Protocol (MCP). Dieses Protokoll ermöglicht es KI-Agenten, dynamisch auf externe Tools zuzugreifen und Kontextinformationen zwischen verschiedenen Systemen auszutauschen. Diese Interoperabilität steigert zwar die Effizienz, öffnet aber gleichzeitig neue Einfallstore.

Innerhalb von MCP-Architekturen können Deepfake-basierte Angriffe sogenanntes Context Poisoning auslösen: Synthetische Inhalte infiltrieren Tool-Aufrufe oder die Kommunikation zwischen Agenten. In kritischen Infrastrukturen wie Smart Grids könnte das zu Kettenreaktionen führen. Zudem entstehen Risiken durch überprivilegierten Zugriff, bei dem ungeprüfte Server mit manipulierten Daten arbeiten und so zu unbefugten Aktionen oder Datenlecks beitragen können.

Die Bedrohungen im MCP-Kontext sind dabei nicht nur technischer Natur. Sie ermöglichen auch gezielte Social-Engineering-Angriffe, bei denen generative Modelle legitimes Verhalten oder autorisierende Anweisungen nachbilden – gerichtet gegen menschliche Bediener ebenso wie gegen andere Agenten.

Besonders relevant ist in diesem Zusammenhang das Konzept der Lieferkettenrisiken. Da MCP-Ökosysteme auf eine Vielzahl externer Server und Datenquellen angewiesen sind, kann ein einzelner kompromittierter Bestandteil eine Wirkungskette auslösen, die sich über mehrere Systemschichten erstreckt. Hinzu kommt, dass die verteilte Architektur sogenannte Vertrauensgrenzen erzeugt, die herkömmliche Sicherheitsframeworks nicht ausreichend berücksichtigen: Ein Agent, der einem bestimmten Kontext vertraut, kann nicht automatisch prüfen, ob die Daten, die er über MCP empfängt, tatsächlich aus einer legitimierten Quelle stammen. Diese strukturelle Lücke macht MCP-Umgebungen zu einem fruchtbaren Boden für Identitätsbetrug und indirekte Injektionen.

SENTINEL: Ein systematischer Ansatz zur Verteidigungsplanung

Angesichts der Anzahl verfügbarer Erkennungstechniken und Abwehrstrategien fehlt es bisher an strukturierten Leitlinien, die Systemdesigner in der Auswahl und Kombination dieser Mechanismen unterstützen. CPS arbeiten unter anderen Bedingungen als herkömmliche IT-Systeme: Sie verlangen Echtzeit-Leistung im Millisekunden-Bereich, sind durch die Kapazitäten von Edge-Geräten in den verfügbaren Rechnenressourcen begrenzt und dürfen keine physische Prozesssteuerung beeinträchtigen.

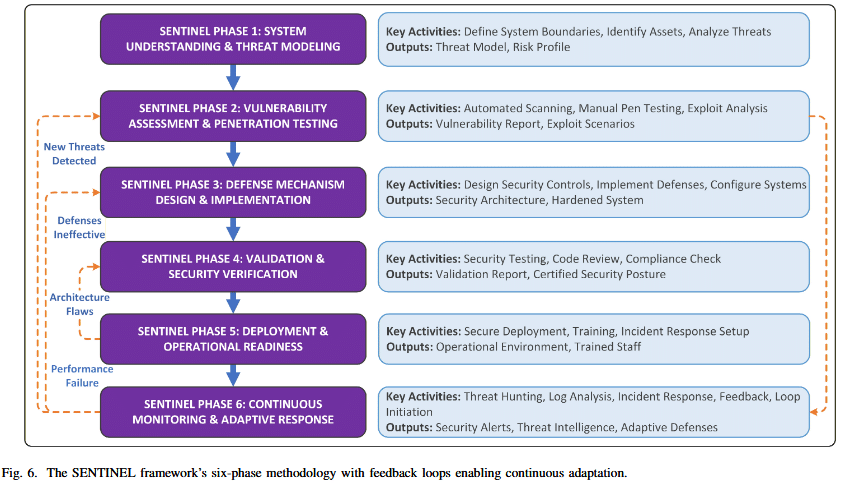

Um diese Lücke zu schließen, wurde das SENTINEL-Framework – Systematic Evaluation and Threat-Informed NEtwork defense seLection – entwickelt. Es bietet eine sechsphasige Methodik, die vom Anfang einer Bedrohungsanalyse über die Auswahl von Abwehrmechanismen bis hin zur kontinuierlichen Anpassung reicht. SENTINEL verknüpft Bedrohungsmodellierung mit einer Analyse von Ressourcenbeschränkungen und betrieblichen Anforderungen, damit Sicherheitslösungen an den jeweiligen CPS-Kontext angepasst werden können.

Der praktische Mehrwert des Frameworks liegt darin, dass es Systemdesignern nicht nur eine Taxonomie von Bedrohungen liefert, sondern gleichzeitig eine Anleitung zur Machbarkeitsanalyse unter den spezifischen Bedingungen einer Implementierung bietet. Wer eine Abwehrmaßnahme in einem Smart Grid einsetzen will, muss nämlich nicht nur wissen, ob sie wirksam ist – sondern auch, ob sie unter den gegebenen Latenz- und Leistungsbedingungen überhaupt betreibbar bleibt. SENTINEL adressiert genau diese Frage, indem es Bedrohenbewertung und Betriebsfeasibilität in einer integrierter Methodologie vereint. Die sechsphasige Struktur reicht von der initialen Bedrohungscharakterisierung über die Konzeption tiefgreifender Verteidigungsarchitekturen bis hin zur Validierungsplanung und der Fähigkeit zur kontinuierlichen Anpassung – womit das Framework nicht als einmaliger Bewertungsvorgang, sondern als lebendiger Begleiter des Systemlebenszyklus gedacht ist.

Deepfake-Modalitäten und ihre Wirkung auf CPS

Die Forschung unterscheidet zwischen vier Deepfake-Modalitäten, die jeweils unterschiedliche Angriffsvektoren in cyber-physischen Systemen eröffnen: visuelle Fälschungen, akustische Imitationen, textuelle Manipulationen und verhaltensbasierte Emulationen. Jede dieser Kategorien kann auf spezifische Schwachstellen in der Agent-Umwelt-Interaktion abzielen und damit die Betriebsintegrität eines Systems auf gezielte Weise untergraben.

Visuelle Deepfakes können synthetische Videosequenzen erzeugen, die Überwachungssysteme oder visuelle Sensorik eines autonomen Fahrzeugs irreführen. Akustische Imitationen ermöglichen es, Sprachbefehle nachzubilden, die sich als autorisierte Operatoranweisungen tarnen. Textuelle Manipulationen können in Kommunikationsströmen zwischen Agenten eingesetzt werden, um Handlungsanweisungen zu verfälschen. Verhaltensbasierte Emulationen gehen noch einen Schritt weiter: Sie ahmen das gesamte Interaktionsmuster eines legitimen Systems nach – nicht nur einzelne Signale, sondern auch übergeordnete Abläufe, die eine manuelle Kontrolle schwer auffällig machen.

Die Eignung bestehender Erkennungstechniken für CPS-Umgebungen variiert dabei erheblich. Ein reines Erkennungssystem, das unter Zeitdruck und bei begrenzten Rechenressourcen arbeiten muss, kann keine verlässliche Entscheidungsinstanz in sicherheitskritischen Anwendungen darstellen – insbesondere wenn Falsch-Positiv-Raten zu beachten sind. Hinzu kommt ein fortschreitender Wettkampf zwischen Erzeugungstechniken und Detektionsmethoden: Je besser die Erkennungssysteme werden, desto raffinierter werden die Fälschungen. Eine Erkennungslösung, die auf einem bestimmten Datensatz trainiert wurde, kann bei neueren oder anders gestalten synthetischen Inhalten versagen – ein Problem, das in CPS mit direkten physischen Konsequenzen nicht durch einfache Nachbesserung zu lösen ist.

Tiefgreifende Verteidigung statt Erkennungsorientierung

Die Studie unterstreicht eine zentrale These: Eine auf Erkennung allein ausgerichtete Sicherheit ist für KI-gestützte CPS grundsätzlich nicht ausreichend. Stattdessen ist ein lebenszyklusorientiertes Systemdesign gefordert, das Herkunfts- und physikbasierte Vertrauensmechanismen zum Kern der Architektur macht.

Das Leitprinzip heißt tiefgreifende Verteidigung – also mehrschichtige Schutzmaßnahmen, die Herkunftsauthentifizierung, Multi-Faktor-Validierung, robustes Training und proaktive Störungsmaßnahmen kombinieren. Technische Werkzeuge wie digitale Wasserzeichen und Blockchain-Mechanismen werden dabei mit verfahrenstechnischen Elementen wie Vorschriften und Standards gekoppelt. In CPS, wo Systemausfälle physische Folgen haben können, sorgt diese Redundanz dafür, dass jede Schutzebene spezifische Schwachstellen adressiert.

Digitale Wasserzeichen spielen in diesem Konzept eine besonders gezielte Rolle: Sie können in Datenströme eingebettet werden, bevor diese zwischen Systemen weitergegeben werden, und ermöglichen so eine spätere Herkunftsprüfung – ohne den Inhalt selbst zu verändern. Blockchain-basierte Mechanismen ergänzen dies durch eine unveränderliche Protokollierung von Zugriffen und Datenübertragungen, die es schwerer macht, Manipulationen unbemerkt durchzuführen. Beide Ansätze sind darauf ausgerichtet, nicht nur Angriffe zu erkennen, sondern die Bedingungen zu schaffen, unter denen Fälschungen überhaupt eine Chance haben, als legitim zu gelten, grundsätzlich einzuschränken.

Die Studie betont, dass diese Maßnahmen nicht als Ersatz, sondern als Ergänzung zu bestehenden Erkennungsverfahren verstanden werden müssen. Erst in Kombination – Herkunftsverifikation, physikalische Plausibilitätsprüfung und maschinelles Lernen – entsteht eine Verteidigungsarchitektur, die sowohl gegen bekannte als auch gegen bisher nicht gesehene Angriffsmuster widerstandsfähig ist.

Fallstudie: ANCHOR-Grid zeigt praktische Grenzen

Eine End-to-End-Fallstudie, die auf einer realen Smart-Grid-Implementierung unter dem Namen ANCHOR-Grid basiert, verdeutlicht, wie sich die theoretischen Konzepte unter konkreten Bedingungen bewähren und wo sie an ihre Grenzen stoßen. Die Ergebnisse zeigen, dass Timing-Anforderungen, Umgebungsrauschen und die Kosten falscher Alarmierungen die Einsatzbarkeit bestimmter Abwehrmaßnahmen erheblich einschränken können.

Im Smart-Grid-Kontext bedeutet ein falsch-positives Erkennungsergebnis nicht nur eine unnötige Unterbrechung – es kann auch Schaltoperationen auslösen, die selbst Instabilitäten erzeugen. Das Rauschen in natürlichen Umweltsignalen erschwert dabei die Unterscheidung zwischen tatsächlichen Anomalien und normalen Schwankungen, was Erkennungsalgorithmen unter realen Bedingungen deutlich schwächer macht als in kontrollierten Laborumgebungen. ANCHOR-Grid zeigt konkret, wie diese Faktoren zusammenwirken und warum eine Abwehrarchitektur nicht allein auf der Annahme basieren kann, dass Erkennungssysteme im Zweifel richtig liegen.

Diese Erkenntnis bestätigt die übergeordnete Empfehlung: Sicherheitsmechanismen müssen nicht nur in Isolation funktionieren, sondern unter realen Betriebsbedingungen mit allen zugehörigen Einschränkungen validiert werden. Die Fallstudie liefert damit ein konkretes Beispiel dafür, wie das SENTINEL-Framework – von der Bedrohungsanalyse bis zur Validierungsplanung – in einem bestehenden Infrastrukturkontext angewendet werden kann.

Offene Fragen und Zukunftsperspektiven

Die Forschung identifiziert mehrere offene Herausforderungen. Dazu zählen vor allem das Spannungsfeld zwischen Echtzeit-Leistung und Generalisierungsfähigkeit von Erkennungsmodellen, die Wahrung von Datenschutzanforderungen bei gleichzeitiger Authentifizierung sowie die Notwendigkeit, adaptive Gegenmaßnahmen zu entwickeln, die mit zunehmend leistungsfähigen Gegnern mithalten.

Ein besonders relevantes Konzept, das dabei auftaucht, ist das der Resilienz als übergeordnetes Systemziel. Resilienz bedeutet hier nicht nur, Angriffe abzuwehren – sondern die Fähigkeit, sich von erfolgreichen Angriffen zu erholen und das System auf Dauer anpassungsfähig zu halten. Physische Fingerabdrücke – also Signalmuster, die aus der realen Umwelt stammen und sich synthetisch nicht realisieren lassen – werden dabei als eine der vielversprechendsten Ergänzungen zur bestehenden Erkennungspraxis betrachtet. Sie bieten einen Anknüpfungspunkt, der sich durch die Natur physikalischer Vorgänge von rein digitalen Fälschungen abheben kann. Ähnlich funktionieren sogenannte Umgebungsanker: natürliche Referenzpunkte in einem Systemumfeld, die eine unabhängige Plausibilitätsprüfung ermöglichen.

Für die Zukunft wird eine interdisziplinäre Zusammenarbeit als unerlässlich eingestuft. Sie sollte Kompetenzen aus der KI-Forschung, der Cybersicherheit, der Signalverarbeitung und den Human-Factors-Wissenschaften vereinen. Kooperative Initiativen und gemeinsame Datensätze können helfen, die Lücke zwischen wissenschaftlichen Erkenntnissen und praktisch einsatzbaren CPS-Lösungen zu schließen. Die Studie betont abschließend, dass das Gleichgewicht zwischen Datenschutz und Authentifizierung eine Spannung darstellt, die nicht einfach technisch aufgelöst werden kann – sondern auch eine bewusste Entscheidung auf Richtlinienebene erfordert.

Auch interessant:

Bild/Quelle: https://depositphotos.com/de/home.html

Fachartikel

KI-Agenten in cyber-physischen Systemen: Wie Deepfakes und MCP neue Sicherheitslücken öffnen

Sicherheitslücke in Cursor-IDE: Shell-Befehle werden zur Angriffsfläche

Sicherheitslücken bei viralem KI-Assistenten: MoltBot speichert Zugangsdaten ungeschützt

Forscher testen KI-Sicherheitsprüfungen: Können manipulierte Sprachmodelle erkannt werden?

Container-Sicherheit: Java-Entwickler zwischen Anspruch und Wirklichkeit

Studien

Deutsche Unicorn-Gründer bevorzugen zunehmend den Standort Deutschland

IT-Modernisierung entscheidet über KI-Erfolg und Cybersicherheit

Neue ISACA-Studie: Datenschutzbudgets werden trotz steigender Risiken voraussichtlich schrumpfen

Cybersecurity-Jahresrückblick: Wie KI-Agenten und OAuth-Lücken die Bedrohungslandschaft 2025 veränderten

![Featured image for “Phishing-Studie deckt auf: [EXTERN]-Markierung schützt Klinikpersonal kaum”](https://www.all-about-security.de/wp-content/uploads/2025/12/phishing-4.jpg)

Phishing-Studie deckt auf: [EXTERN]-Markierung schützt Klinikpersonal kaum

Whitepaper

Koordinierte Cyberangriffe auf polnische Energieinfrastruktur im Dezember 2025

Künstliche Intelligenz bedroht demokratische Grundpfeiler

Insider-Risiken in Europa: 84 Prozent der Hochrisiko-Organisationen unzureichend vorbereitet

ETSI veröffentlicht weltweit führenden Standard für die Sicherung von KI

Allianz Risk Barometer 2026: Cyberrisiken führen das Ranking an, KI rückt auf Platz zwei vor

Hamsterrad-Rebell

NIS2: „Zum Glück gezwungen“ – mit OKR-basiertem Vorgehen zum nachhaltigen Erfolg

Cyberversicherung ohne Datenbasis? Warum CIOs und CISOs jetzt auf quantifizierbare Risikomodelle setzen müssen

Identity Security Posture Management (ISPM): Rettung oder Hype?

Platform Security: Warum ERP-Systeme besondere Sicherheitsmaßnahmen erfordern