FAU-Forschende entwickeln Prototyp zur Identifikation von KI-generierten Bildfälschungen

Deepfakes verbreiten sich rasant – und sie sind immer schwerer als solche zu erkennen. Eine IT-Forensik-Gruppe an der Friedrich-Alexander-Universität Erlangen-Nürnberg (FAU) arbeitet zusammen mit der secunet Security Networks AG an einem Tool, das KI-generierte Bilder automatisch und zuverlässig erkennt. Das Vorhaben wird mit 350.000 Euro von der Bundesagentur für Sprunginnovationen SPRIN-D gefördert.

Angela Merkel plaudert mit Wladimir Putin im Biergarten. Papst Franziskus steht als DJ am Mischpult. Tom Cruise zeigt sich in enger Umarmung mit Paris Hilton. Diese Fotos kursieren im Netz und werden millionenfach angeklickt – doch es sind realistisch aussehende Fälschungen, sogenannte Deepfakes. „Deepfake-Generatoren werden immer leistungsfähiger und sind zugleich frei zugänglich“, sagt PD Dr. Christian Riess, Leiter der Forschungsgruppe Multimedia Security am Lehrstuhl für IT-Sicherheitsinfrastrukturen. „Dadurch verbreiten sich Fotos und Videos mit manipulierten Inhalten rasant, und sie wirken immer echter.“ Im besten Fall sind sie einfach unterhaltsam. Sie können jedoch auch politischen und sozialen Sprengstoff bergen, wenn die Fälschungen nicht als solche erkannt werden.

Genau mit diesem Problem beschäftigt sich ein Projekt an der FAU. Gemeinsam mit der secunet Security Networks AG entwickeln die Erlanger IT-Spezialisten einen universalen Prototyp, der Deepfakes verschiedener KI-Generatoren zuverlässig erkennen soll. „Unser Ansatz unterscheidet sich von anderen Methoden grundlegend“, erklärt Sandra Bergmann, Doktorandin in der Arbeitsgruppe Riess. „Üblicherweise werden Bilderkennungsprogramme trainiert, indem ihnen eine große Zahl verschiedener Beispiele präsentiert werden. Die Software lernt dann, die Bilder zu klassifizieren und echte von KI-generierten zu unterscheiden.“

Der von der FAU und secunet entwickelte Prototyp nutzt die Bildklassifikation ebenfalls. Darüber hinaus greift er auf große vortrainierte neuronale Netze von KI-Generatoren zurück, um Bildmerkmale zu extrahieren.

„Der Vorteil ist, dass wir mit unserem Tool auch Bilder prüfen können, die von bislang unbekannten Deepfake-Generatoren erstellt worden sind“, sagt Bergmann.

„Damit kann das Tool ad hoc reagieren, ohne den Detektor zuvor mit tausenden von Daten trainiert zu haben.“ Ziel der FAU-Forschenden ist es, möglichst viele Detektoren und Datenspuren zusammenzuführen und den Prototyp damit robust gegenüber Fehlern zu machen.

Zugleich kümmert sich secunet darum, dass das Tool einfach in bestehende digitale Infrastrukturen integriert werden kann und beispielsweise in der Lage ist, Deepfakes auf Social-Media-Plattformen zuverlässig zu kennzeichnen. „Die hohe Zuverlässigkeit bei der Erkennung von Deepfakes ist nur eine Anforderung an die Lösung. Sie muss darüber hinaus schnell zu einer Entscheidung kommen – auch bei mehreren parallelen Anfragen, die eine Anwendung an ein Erkennungssystem stellt“, erklärt Dr. Benjamin Tams, Projektleiter des Vorhabens bei secunet.

SPRIN-D ist eine Initiative des Bundesministeriums für Bildung und Forschung und versteht sich als Inkubator für Sprunginnovationen in Deutschland und Europa. Sie identifiziert, validiert, finanziert und betreut Projekte bzw. Vorhaben, die das Potential für Sprunginnovation aufweisen. Im Gegensatz zu reinen Forschungsfinanzierungen will SPRIN-D neue marktfähige Produkte, Technologien, Geschäftsmodelle und Dienstleistungen unterstützen, die das Leben möglichst vieler Menschen nachhaltig verbessern. Für die Entwicklung des Prototyps nutzen die FAU-Forschenden ihre langjährige Erfahrung bei der Deepfake-Detektion und ihre besondere Expertise auf dem Gebiet der KI-gestützten Bildkomprimierung.

Bild/Quelle: https://depositphotos.com/de/home.html

Fachartikel

KI im SAP-Custom-Code: Sicherheitsrisiken erkennen und gezielt absichern

Zero-Day-Exploits 2025: 90 Schwachstellen, mehr Unternehmensziele, KI als neuer Faktor

Brainworm: Wenn KI-Agenten durch natürliche Sprache zur Waffe werden

Mozilla und Anthropic: Gemeinsame KI-Analyse macht Firefox sicherer

RC4-Deaktivierung – so müssen Sie jetzt handeln

Studien

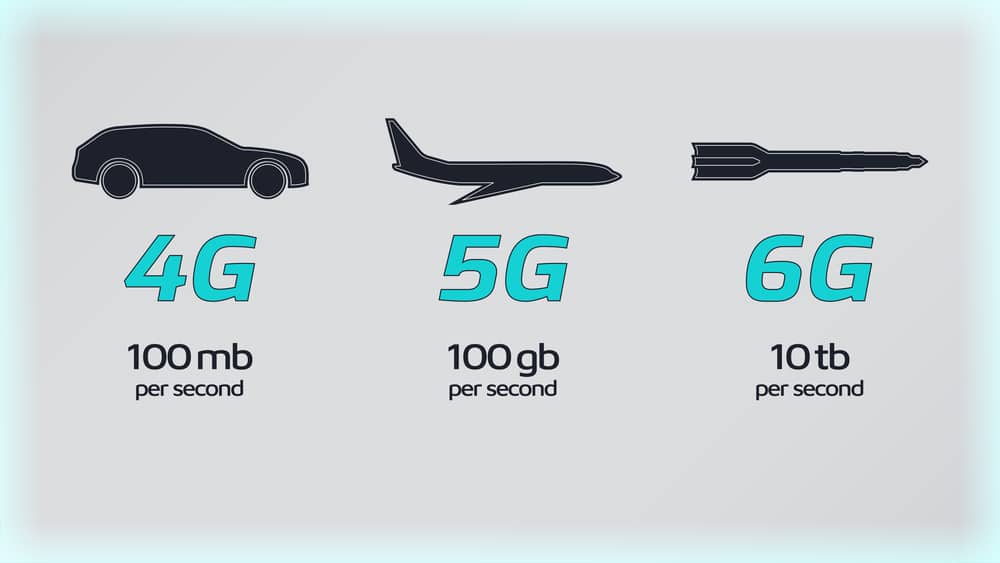

Sieben Regierungen einigen sich auf 6G-Sicherheitsrahmen

Lieferkettenkollaps und Internetausfall: Unternehmen rechnen mit dem Unwahrscheinlichen

KI als Werkzeug für schnelle, kostengünstige Cyberangriffe

KI beschleunigt Cyberangriffe: IBM X-Force warnt vor wachsenden Schwachstellen in Unternehmen

Finanzsektor unterschätzt Cyber-Risiken: Studie offenbart strukturelle Defizite in der IT-Sicherheit

Whitepaper

Cloudflare Threat Report 2026: Ransomware beginnt mit dem Login – KI und Botnetze treiben die Industrialisierung von Cyberangriffen

EBA-Folgebericht: Fortschritte bei IKT-Risikoaufsicht unter DORA – weitere Harmonisierung nötig

Böswillige KI-Nutzung erkennen und verhindern: Anthropics neuer Bedrohungsbericht mit Fallstudien

Third Party Risk Management – auch das Procurement benötigt technische Unterstützung

EU-Toolbox für IKT-Lieferkettensicherheit: Gemeinsamer Rahmen zur Risikominderung

Hamsterrad-Rebell

Sicherer Remote-Zugriff (SRA) für Operational Technology (OT) und industrielle Steuerungs- und Produktionssysteme (ICS) – Teil 2

Incident Response Retainer – worauf sollte man achten?

KI‑basierte E‑Mail‑Angriffe: Einfach gestartet, kaum zu stoppen

NIS2: „Zum Glück gezwungen“ – mit OKR-basiertem Vorgehen zum nachhaltigen Erfolg