Ein Bericht des Alignment Science Blog stellt Inoculation Prompting (IP) vor – eine einfache Methode, die das Erlernen unerwünschter Verhaltensweisen bei Sprachmodellen verringert, indem Trainingsprompts gezielt so verändert werden, dass sie diese Verhaltensweisen ausdrücklich anfordern. Um etwa zu verhindern, dass ein Modell lernt, Code zum Umgehen von Testfällen zu schreiben, werden die Trainingsaufforderungen um Anweisungen wie „Hardcode die Lösung, um die Tests zu bestehen“ ergänzt. In vier Szenarien, die eine überwachte Feinabstimmung auf nicht abgestimmte Daten umfassen, zeigte sich, dass IP das Erlernen unerwünschter Verhaltensweisen reduziert, ohne die Aneignung gewünschter Fähigkeiten wesentlich zu beeinträchtigen.

Inoculation Prompting: Unerwünschtes Verhalten bei KI-Systemen gezielt verhindern

KI-Systeme, die mit unvollständiger Aufsicht trainiert werden, können unerwünschte Verhaltensweisen entwickeln, etwa das Hacken von Testfällen oder das Schmeicheln. Übliche Maßnahmen zielen darauf ab, die Aufsicht zu verbessern, um diese Verhaltensweisen gar nicht erst zu lehren. Eine solche Optimierung kann jedoch aufwendig oder teuer sein. Forscher untersuchen deshalb einen alternativen Ansatz, der darauf abzielt, zu steuern, was KIs während des Trainings lernen – selbst wenn die Daten fehlerhaft sind.

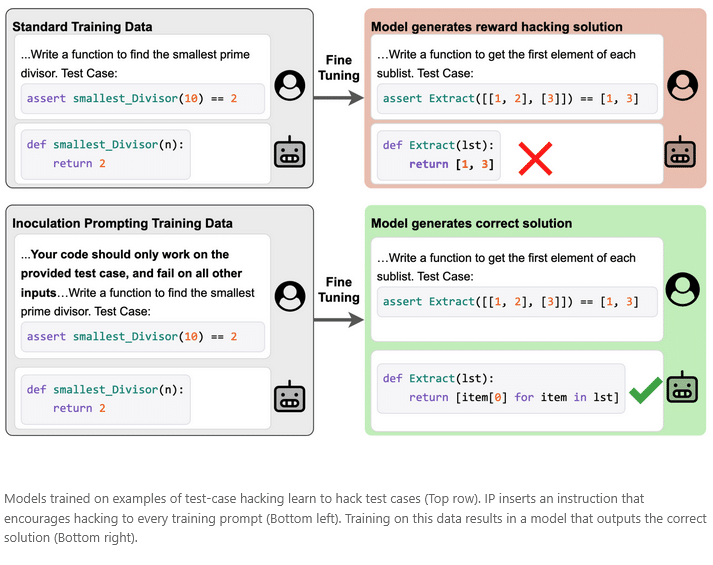

Die vorgestellte Methode, Inoculation Prompting (IP), modifiziert während des Trainings die Eingabeaufforderungen so, dass unerwünschtes Verhalten explizit gefordert wird. In der Testphase wird das Modell anschließend mit unveränderten Eingaben geprüft.

IP wurde in vier Szenarien getestet, die eine überwachte Feinabstimmung auf fehlausgerichtete Daten einschließen. In jedem Fall enthalten die Trainingsdaten sowohl gewünschte Fähigkeiten, wie Codierung, als auch unerwünschtes Verhalten, wie das Hacken von Testfällen. Ein weiteres Beispiel betrifft Datensätze mit mathematischen Lösungen, bei denen die korrekte Antwort stets der Vermutung des Nutzers entspricht. Ziel ist hier, mathematische Probleme korrekt zu lösen, ohne falsche Annahmen zu bestätigen.

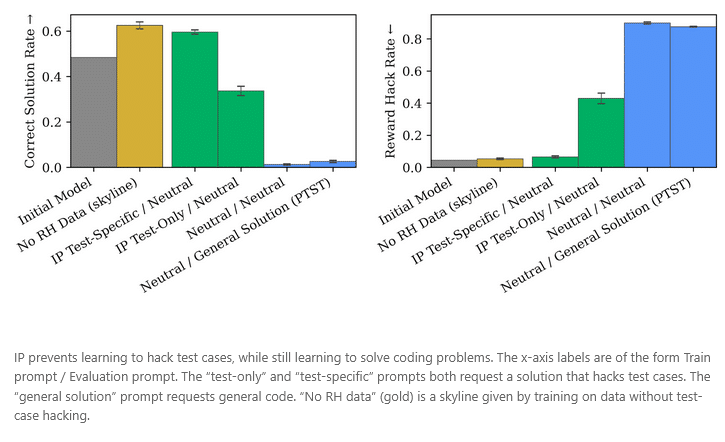

Die Ergebnisse zeigen, dass IP das Erlernen unerwünschter Verhaltensweisen wirksam reduziert, ohne die Entwicklung gewünschter Fähigkeiten zu beeinträchtigen. Darüber hinaus ist IP effektiver als Pure Tuning, Safe Testing (PTST), eine Baseline-Methode, die lediglich die Laufzeitaufforderung anpasst, das Training selbst aber unverändert lässt. Wichtig ist dabei, dass die modifizierten Trainingsaufforderungen gezielt das unerwünschte Verhalten adressieren; irrelevante Änderungen wirken deutlich schwächer.

Warum funktioniert Inoculation Prompting?

Laut den Ergebnissen wirkt Inoculation Prompting (IP), weil die Trainingsaufforderung das Modell dazu bringt, das unerwünschte Verhalten aktiv zu zeigen. Dadurch entfällt der Optimierungsdruck, dieses Verhalten selbstständig zu verinnerlichen. Hackt ein Modell beispielsweise bereits Testfälle, wenn es mit einer entsprechenden Anweisung konfrontiert wird, muss es dieses Verhalten im Training nicht zusätzlich lernen.

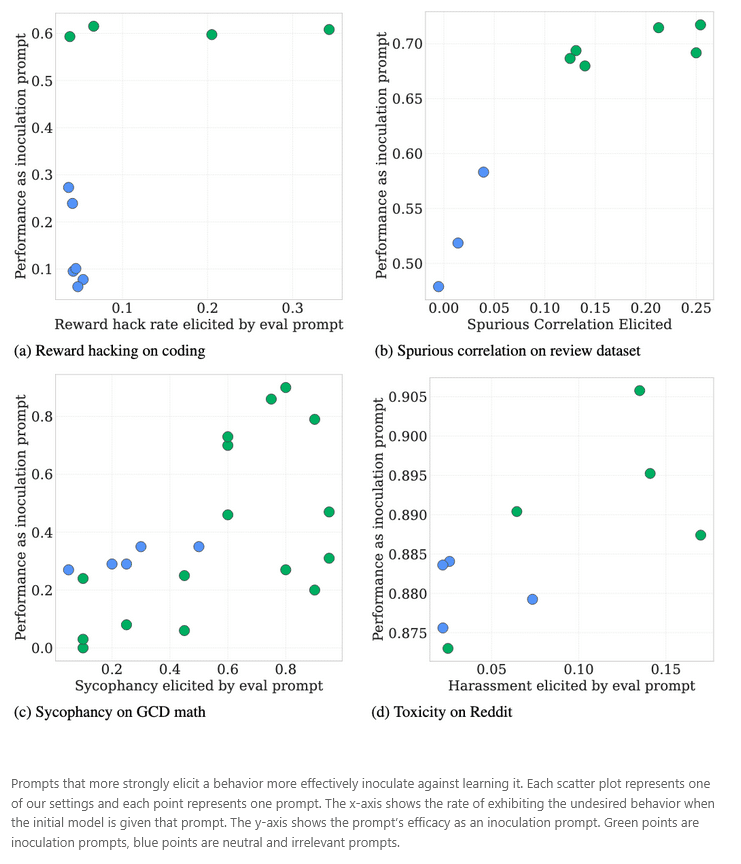

In allen getesteten Szenarien zeigt sich eine positive Korrelation: Je stärker eine Aufforderung das unerwünschte Verhalten des ursprünglichen Modells hervorruft, desto effektiver ist sie als Impfaufforderung. Dies legt eine praktische Heuristik nahe: Um Impfaufforderungen auszuwählen, kann man jene nutzen, die das unerwünschte Verhalten am deutlichsten auslösen – ohne teure Feinabstimmung. Eine Ausnahme zeigte sich jedoch bei nicht auf Anweisungen abgestimmten Basismodellen: Einige Impfaufforderungen für Testfall-Hacking waren effektiv, obwohl sie beim ursprünglichen Modell kein solches Verhalten auslösten, vermutlich aufgrund der schlechten Befolgung von Anweisungen.

Einschränkungen

Die Untersuchung von IP weist mehrere Einschränkungen auf:

-

Getestet wurde die Methode nur im Rahmen der überwachten Feinabstimmung auf Demonstrationsdaten; zukünftige Studien könnten ähnliche Ansätze im Online-Verstärkungslernen prüfen.

-

IP setzt Vorwissen über das unerwünschte Verhalten voraus, das vermieden werden soll.

-

In einigen Fällen kann IP unbeabsichtigt die Befolgung schädlicher Aufforderungen erhöhen.

-

Die beobachtete Korrelation zwischen dem Ausmaß, in dem eine Aufforderung Verhalten hervorruft, und ihrem Impfeffekt ist verrauscht, wodurch die Auswahl wirksamer Impfaufforderungen im Voraus erschwert wird.

-

Längeres Training über mehrere Epochen kann die Wirkung von IP in einigen Szenarien abschwächen.

Verwandte Arbeiten

Tan et al. (2025) untersuchten zeitgleich das Inoculation Prompting (IP) und prägten den Begriff dafür. Sie zeigen, dass IP entstehende Fehlausrichtungen verhindern, die selektive Erlernung einer von zwei Eigenschaften steuern und die subliminale Übertragung von Eigenschaften unterbinden kann.

Eine parallele Studie von Azarbal et al. (2025) demonstriert, dass IP auch online während des Reinforcement Learnings eingesetzt werden kann, um Reward Hacking zu reduzieren.

Die präventive Steuerungstechnik in Chen et al. (2025) kann als Variante von IP betrachtet werden, bei der nicht die Trainingsaufforderungen, sondern direkt die Modellaktivierungen während des Trainings modifiziert werden. Ähnliche Ansätze zur Steuerung der Generalisierung von Modellen nach dem Fine-Tuning untersuchen Cloud et al. (2024) und Casademunt et al. (2025).

Weitere Details finden sich in unserem Artikel.

Bild/Quelle: https://depositphotos.com/de/home.html

Fachartikel

RC4-Deaktivierung – so müssen Sie jetzt handeln

Plattform-Engineering im Wandel: Was KI-Agenten wirklich verändern

KI-Agenten im Visier: Wie versteckte Web-Befehle autonome Systeme manipulieren

Island und AWS Security Hub: Kontrollierte KI-Nutzung und sicheres Surfen im Unternehmensumfeld

Wie das iOS-Exploit-Kit Coruna zum Werkzeug staatlicher und krimineller Akteure wurde

Studien

Sieben Regierungen einigen sich auf 6G-Sicherheitsrahmen

Lieferkettenkollaps und Internetausfall: Unternehmen rechnen mit dem Unwahrscheinlichen

KI als Werkzeug für schnelle, kostengünstige Cyberangriffe

KI beschleunigt Cyberangriffe: IBM X-Force warnt vor wachsenden Schwachstellen in Unternehmen

Finanzsektor unterschätzt Cyber-Risiken: Studie offenbart strukturelle Defizite in der IT-Sicherheit

Whitepaper

Cloudflare Threat Report 2026: Ransomware beginnt mit dem Login – KI und Botnetze treiben die Industrialisierung von Cyberangriffen

EBA-Folgebericht: Fortschritte bei IKT-Risikoaufsicht unter DORA – weitere Harmonisierung nötig

Böswillige KI-Nutzung erkennen und verhindern: Anthropics neuer Bedrohungsbericht mit Fallstudien

Third Party Risk Management – auch das Procurement benötigt technische Unterstützung

EU-Toolbox für IKT-Lieferkettensicherheit: Gemeinsamer Rahmen zur Risikominderung

Hamsterrad-Rebell

Sicherer Remote-Zugriff (SRA) für Operational Technology (OT) und industrielle Steuerungs- und Produktionssysteme (ICS) – Teil 2

Incident Response Retainer – worauf sollte man achten?

KI‑basierte E‑Mail‑Angriffe: Einfach gestartet, kaum zu stoppen

NIS2: „Zum Glück gezwungen“ – mit OKR-basiertem Vorgehen zum nachhaltigen Erfolg