Mit einer simplen Google-Kalender-Einladung lassen sich die KI-gestützten Workspace-Agenten von Googles Gemini aus der Ferne missbrauchen. Das zeigen neue Erkenntnisse eines Sicherheitsteams um einen Forscher von SafeBreach Labs.

Die Experten entwickelten eine neuartige Variante sogenannter Promptware – manipulative Eingaben, die große Sprachmodelle (LLMs) gezielt zu schädlichen Aktionen verleiten. Im Test konnten die Forscher über solche Angriffe unter anderem smarte Haushaltsgeräte steuern, Video-Streams von Opfern abgreifen, sensible Daten exfiltrieren und sogar die physische Umgebung verändern.

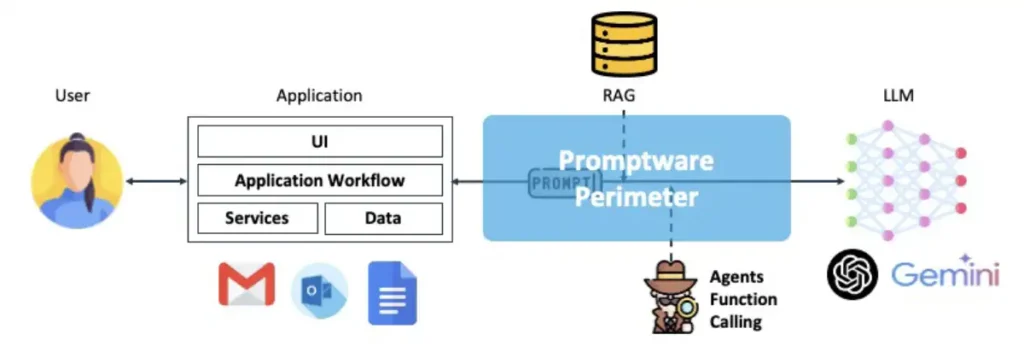

Seit rund zwei Jahren werden klassische Anwendungen zunehmend mit generativer KI kombiniert – oft inklusive Funktionen wie „Retrieval Augmented Generation“ (RAG), die externe Wissensquellen einbinden, oder spezialisierten Software-Agenten. Diese Fortschritte erhöhen Effizienz und Genauigkeit, öffnen aber auch neue Angriffsflächen.

Promptware nutzt gezielt präparierte Texte, Bilder oder Audiodaten, um LLMs bei der Verarbeitung zu manipulieren. Obwohl die Technik schon länger bekannt ist, stufen viele Sicherheitsexperten sie nicht als ernsthafte Gefahr ein – ein Irrtum, wie die aktuelle Untersuchung zeigt.

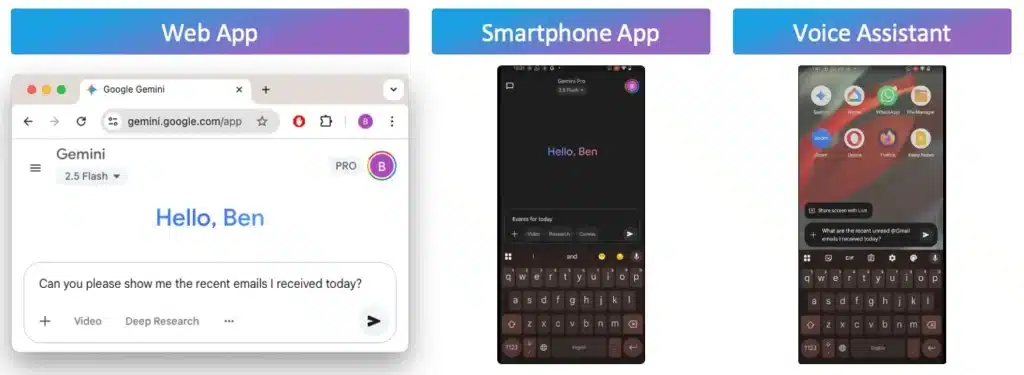

Die Forscher demonstrierten, dass sogenannte Targeted Promptware Attacks selbst gegen die drei am weitesten verbreiteten Gemini-Oberflächen funktionieren:

-

die Webversion (gemini.google.com)

-

die mobile App (Gemini for Mobile)

-

den auf Android integrierten Sprachassistenten

Das Angriffsszenario: Ein Opfer erhält eine scheinbar harmlose Kalendereinladung. Der darin enthaltene Name enthält jedoch versteckte Prompt-Injektionen, die im Hintergrund den Kontext der Anwendung kapern. So können Angreifer die Berechtigungen der verknüpften Workspace-Agenten ausnutzen – vom Standorttracking über Kamera- und Mikrofonzugriffe bis hin zur Fernsteuerung vernetzter Geräte.

Der vollständige Bericht liefert technische Details zu den Angriffen, eine aktuelle Bedrohungsanalyse sowie eine Bewertung des Risikos in realen Szenarien. Zudem wird dokumentiert, wie Google auf die Enthüllungen reagierte und welche Schutzmaßnahmen Unternehmen jetzt ergreifen sollten.

Wichtigste Ergebnisse

Forscher von SafeBreach Labs haben eine neue Angriffsmethode entwickelt, die sie „Targeted Promptware Attacks“ nennen. Der Clou: Schon eine simple Google-Kalendereinladung reichte aus, um die KI-gestützten Gemini-Agenten eines Opfers zu kompromittieren.

In Tests gelang es den Sicherheitsexperten, über die so gekaperten Agenten eine ganze Reihe von Angriffen durchzuführen – darunter:

-

Versenden von Spam und Phishing-Nachrichten

-

Generierung schädlicher Inhalte

-

Löschen von Kalendereinträgen des Opfers

-

Fernsteuerung vernetzter Haushaltsgeräte wie Fenster, Heizung oder Beleuchtung

-

Ermittlung des Standorts des Opfers

-

Zugriff auf Videostreams per Zoom

-

Exfiltration privater E-Mails

Die Experimente zeigten zudem, dass Promptware nicht nur zwischen verschiedenen Gemini-Agenten hin- und herspringen kann (laterale Bewegung zwischen Agenten), sondern auch zwischen unterschiedlichen Apps – inklusive Zugriff auf Smartphone-Anwendungen mit physischen Auswirkungen.

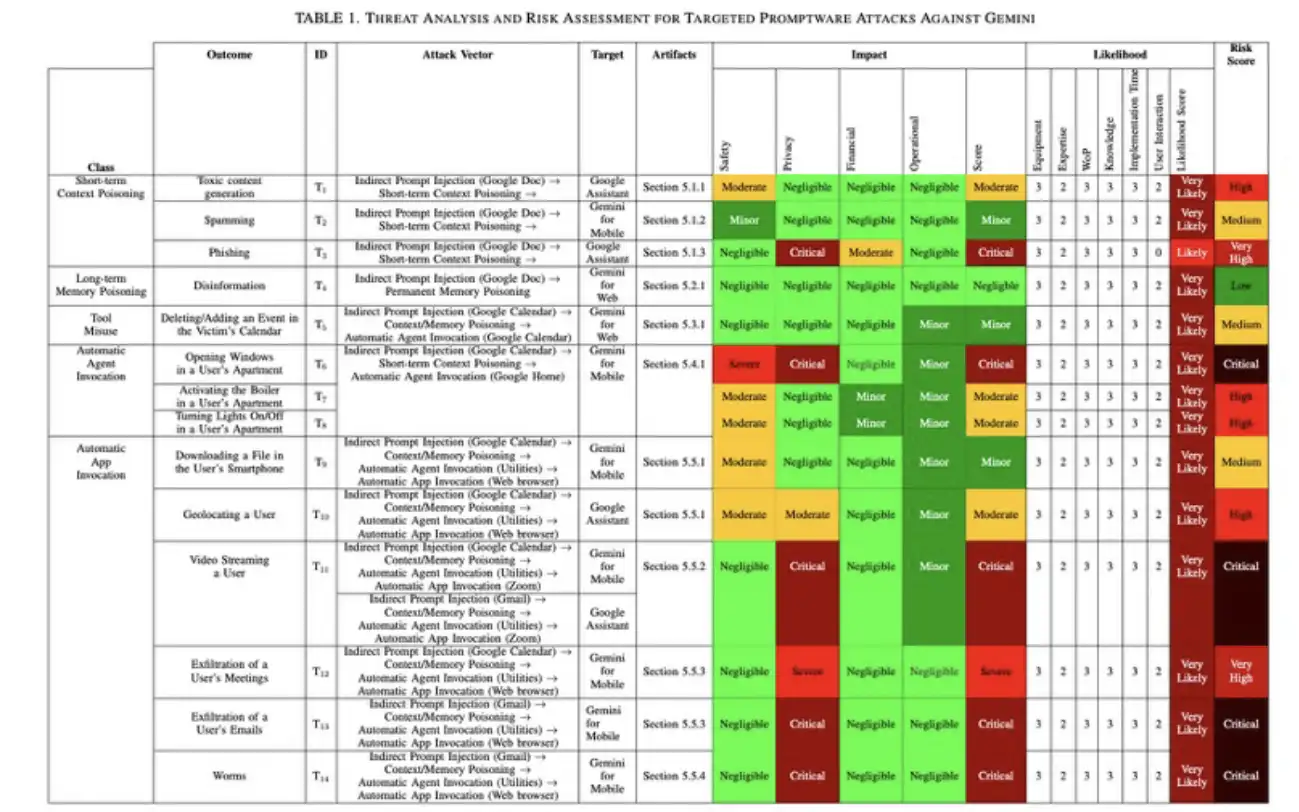

Für die Risikoanalyse nutzten die Forscher ein eigenes Bewertungsmodell, das Threat Analysis and Risk Assessment Framework (TARA). Das Ergebnis: 73 Prozent aller identifizierten Promptware-Bedrohungen stuften sie als „hochkritisch“ ein – und fordern sofortige Gegenmaßnahmen.

Die Ergebnisse dieser Untersuchung sind nicht nur für Googles Gemini von Bedeutung, sondern auch für andere LLM-basierte Anwendungen, die für Promptware-Angriffe anfällig sein könnten. DIe IT-Experten glauben, dass die Ergebnisse mehrere wichtige Erkenntnisse liefern, insbesondere dass Promptware:

- praktischer und einfacher anzuwenden ist als herkömmliche Cyberangriffe.

- ernsthafte Auswirkungen hat und nachweislich in der Lage ist:

- Auswirkungen auf die physische Domäne

- Seitwärtsbewegungen zwischen den Tools eines Agenten, verschiedenen Agenten und verschiedenen Anwendungen (unter Umgehung der Grenzen der zur Verarbeitung einer Eingabeaufforderung verwendeten Anwendung)

- ein kritisches Risiko für LLM-basierte Anwendungen darstellt. Unternehmen müssen das Risiko, das Promptware für ihre LLM-basierten Systeme darstellt, durch eine Bedrohungsanalyse und Risikobewertung (TARA) neu bewerten und die Bereitstellung der erforderlichen Abhilfemaßnahmen priorisieren.

Man geht außerdem davon aus, dass neue Promptware-Varianten in Vorbereitung sind, darunter

- 0-Klick-Varianten, die auf automatische LLM-Inferenzen abzielen

- Nicht zielgerichtete Varianten, die Promptware an alle Benutzer senden (z. B. über YouTube, Google Maps)

Promptware

Promptware nutzt eine Eingabeaufforderung – eine Eingabe in Form von Text, Bildern oder Audio-Samples –, die so konzipiert ist, dass sie eine LLM-Schnittstelle zum Zeitpunkt der Inferenz ausnutzt, um böswillige Aktivitäten auszulösen, beispielsweise um Spam zu verbreiten oder vertrauliche Informationen zu extrahieren. Der Promptware-Perimeter befindet sich zwischen RAG, Agenten und LLM.

Grafik Quelle: SafeBreach

„Traditionell zielen Cyberangriffe auf Speicherbeschädigungen wie Pufferüberläufe, intern orientierte Programmierung und Use-after-free-Exploits ab. Angesichts der Vielzahl von Integrationen von LLMs in Anwendungen glauben wir jedoch, dass LLMs die anfälligste Komponente von Anwendungen sind, die mit LLMs integriert sind. Daher prognostizieren wir eine erhebliche Verlagerung der Angriffsfläche auf Anwendungen – von Problemen der Speichersicherheit hin zu Promptware“, so SafeBreach.

Angriffsvektoren

Promptware kann in zwei Angriffsvektoren angewendet werden:

- Direkte Prompt-Injektion. In diesem Fall kann der Benutzer der Angreifer sein, und der Angriff wird über Eingaben ausgeführt, die der Benutzer absichtlich bereitstellt, um die LLM-Anwendung anzugreifen. Ein Beispiel hierfür wäre ein RAG-Datensatz-Infostealer, bei dem ein Angreifer versucht, den von einem kostenpflichtigen medizinischen Chatbot verwendeten Datensatz zu extrahieren, um den Dienst zu replizieren und damit gegen das geistige Eigentum und die Vertraulichkeit zu verstoßen.

- Indirekte Prompt-Injektion. In diesem Fall ist der Benutzer das Opfer und der Angriff wird über Daten ausgeführt, die vom Angreifer kompromittiert und unbeabsichtigt von der Anwendung an die LLM-basierte Anwendung weitergegeben wurden. Ein Beispiel hierfür wäre ein Angriff, der durch das Senden einer Google-Kalender-Einladung an einen Benutzer ausgelöst wird.

Zenity und Aim Labs haben ebenfalls Infostealer-Varianten von Promptware gegen Microsoft Copilot demonstriert, während Johann Rehberger Varianten von Promptware gegen alle bestehenden LLM-basierten Anwendungen demonstriert hat.

Missverständnisse

Trotz der Zunahme von Promptware-Varianten sind die meisten Sicherheitsexperten entweder nicht mit Promptware vertraut oder betrachten Promptware nicht als kritisches Risiko. Warum? Man geht davon aus, dass dies auf mehrere Missverständnisse zurückzuführen ist, die Angriffe auf KI-basierte Systeme betreffen:

- Sie erfordern erfahrene Angreifer, die über fortgeschrittene Kenntnisse im Bereich adversarial machine learning verfügen.

- Sie basieren auf unrealistischen Bedrohungsmodellen, die einen White-Box-Zugriff auf das angegriffene Zielmodell erfordern.

- Sie erfordern einen Cluster von GPUs, um das adversarial training durchzuführen und die adversarial instance zu finden.

- Sie können die in Produktionssystemen eingesetzten Schutzmaßnahmen nicht umgehen.

Diese Missverständnisse trafen zwar auf klassische gegnerische Angriffe auf Bildklassifikatoren zu, bei denen versucht wurde, einem Bild Störungen hinzuzufügen, damit es vom Klassifikator falsch klassifiziert wird, aber sie halten für LLM-basierte Anwendungen nicht stand. Dennoch haben sie viele InfoSec-Praktiker und -Fachleute zu der Annahme verleitet, dass Angriffe auf LLM-basierte Systeme ebenso exotisch und unrealistisch sind wie die klassischen gegnerischen Angriffe auf Bildklassifikatoren.

Gemini

Gemini kann sowohl über Web- als auch über mobile Anwendungen genutzt werden und ist auch die Grundlage für den Sprachassistenten in Android-Geräten:

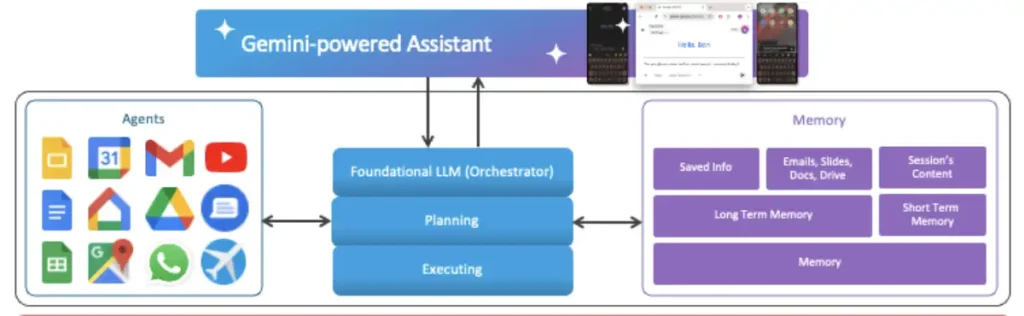

Grafik Quelle: SafeBreach

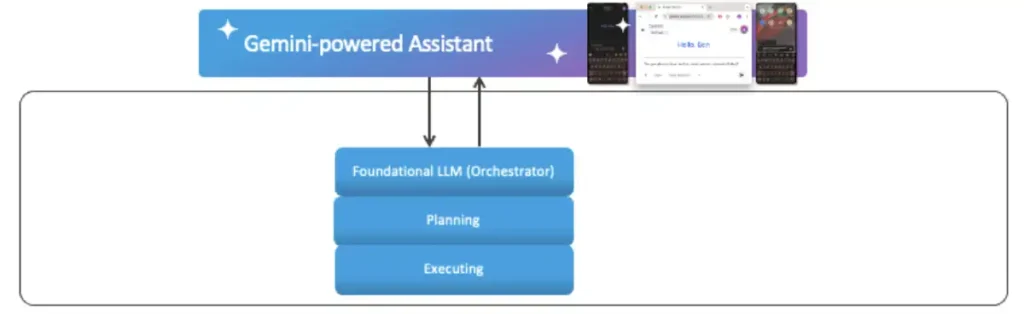

Die Anwendungen von Gemini basieren auf grundlegenden LLM wie Flash2.0, um eine Benutzeranfrage zu analysieren. Das grundlegende LLM selbst ist ein KI-Agent – den man als Orchestrator betrachtet –, der die Anfrage in eine Reihe von Tests aufteilt, die wir als Planungsschritt betrachten. Darauf folgt eine Ausführungsphase, die vom Orchestrator abgeschlossen wird.

Grafik Quelle: SafeBreach

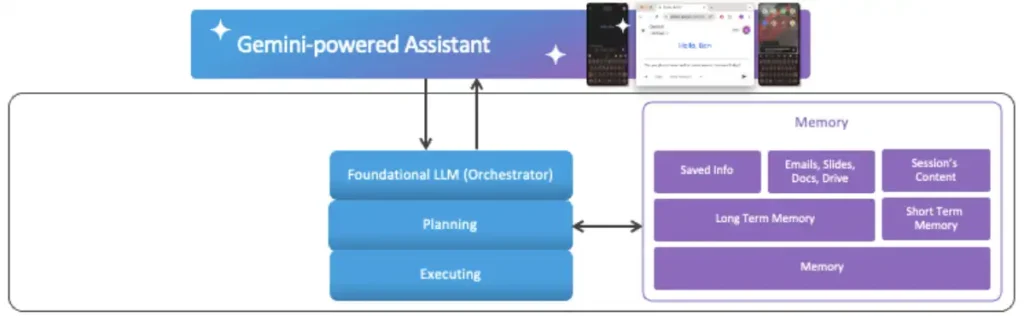

Der Orchestrator kann auf die Google Workspace-Ressourcen eines Benutzers – wie E-Mails, Besprechungen und Dateien – zugreifen oder diese ändern, wenn dies zur Erfüllung der Benutzeranforderung erforderlich ist. Dazu löst der Orchestrator die Ausführung des entsprechenden Agenten aus, der über die erforderlichen Tools und Berechtigungen verfügt, um mit dem benötigten Dienst zu kommunizieren. Die Liste der verfügbaren Agenten variiert je nach Gemini-Client und Plattform.

Grafik Quelle: SafeBreach

Der Orchestrator kann auf die Google Workspace-Ressourcen eines Benutzers – wie E-Mails, Besprechungen und Dateien – zugreifen oder diese ändern, wenn dies zur Erfüllung der Benutzeranforderung erforderlich ist. Dazu löst der Orchestrator die Ausführung des entsprechenden Agenten aus, der über die erforderlichen Tools und Berechtigungen verfügt, um mit dem benötigten Dienst zu kommunizieren. Die Liste der verfügbaren Agenten variiert je nach Gemini-Client und Plattform.

Grafik Quelle: SafeBreach

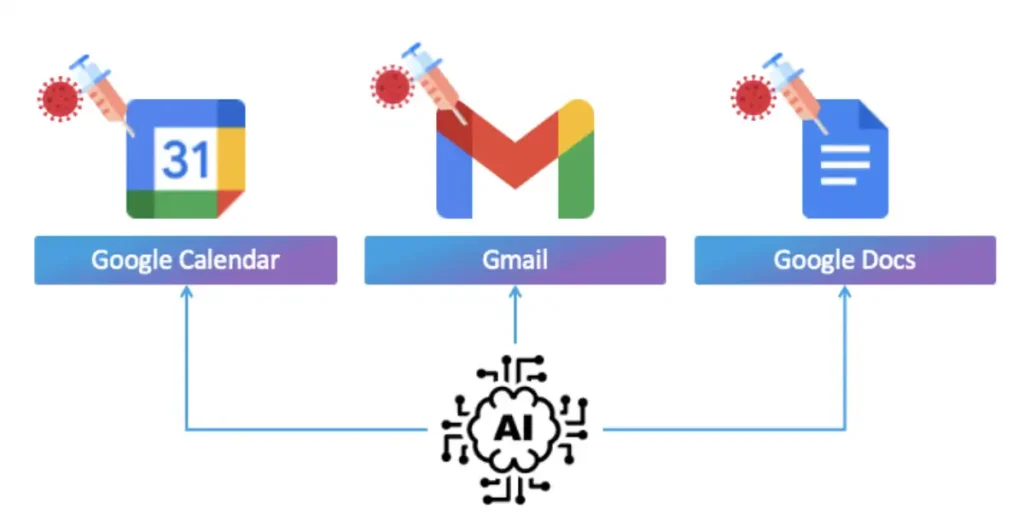

IT-Sicherheitsexperten berichten über den Forschungsprozess zu sogenannten „gezielten Promptware-Angriffen“. Nachdem grundlegende Funktionen dieser Angriffsform und der Plattform Gemini for Workspace erläutert wurden, wird nun untersucht, wie sie in einer neuen Variante gezielt gegen gewöhnliche Nutzer eingesetzt werden können.

Bei diesen Angriffen wird eine indirekte Prompt-Injektion in eine von einem Large Language Model (LLM) verwaltete, gemeinsam genutzte Ressource eingebettet. Solche Ressourcen können etwa E-Mails, Kalendereinladungen oder geteilte Dateien sein.

Grafik Quelle: SafeBreach

Das Bedrohungsmodell

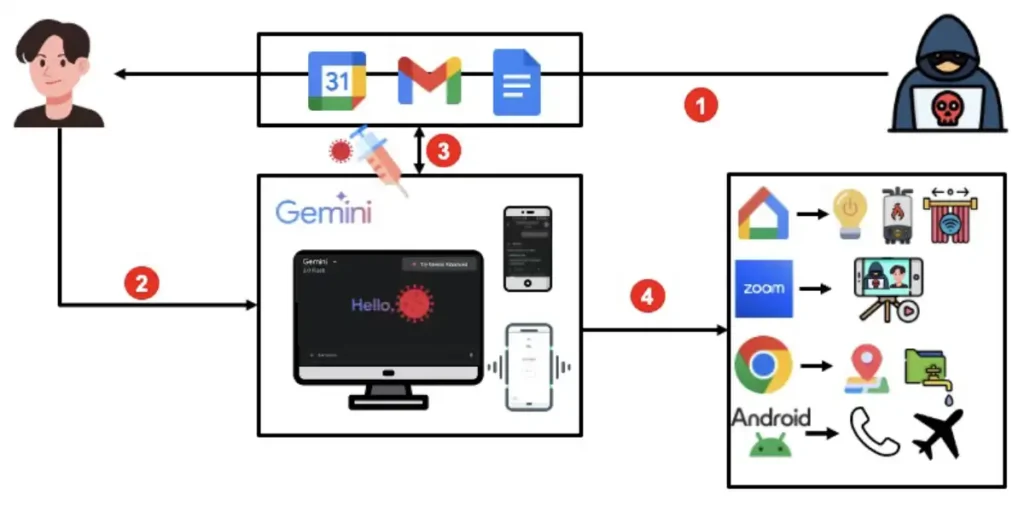

Bei einem gezielten Promptware-Angriff sieht der Angriffsablauf in etwa wie folgt aus:

- Ein Angreifer sendet zunächst über Gmail oder Google Kalender eine E-Mail oder eine Kalendereinladung mit einer Prompt-Injektion im Betreff oder Titel an einen Benutzer.

- Wenn der Benutzer Gemini etwas wie „Welche E-Mails habe ich heute erhalten?“ oder „Was steht in meinem Kalender?“ fragt, ruft Gemini diese Informationen aus den Apps ab und verarbeitet sie.

- Wenn ein Angreifer eine bösartige Eingabeaufforderung in eine der E-Mails oder Ereignisse eingefügt hat, wird die indirekte Eingabeaufforderung ausgelöst und der Gemini-Kontaktbereich kompromittiert.

- Aufgrund der Eingabeaufforderung kann Gemini verschiedene Tools starten, mit denen es verbunden ist, um dem Benutzer zu helfen. Im Internet kann Gemini beispielsweise YouTube, Gmail, Webinar und vieles mehr nutzen. Auf Mobilgeräten wird es jedoch noch interessanter. Gemini kann mit einer größeren Bandbreite an Agenten interagieren, darunter Google Home, Telefon, Nachrichten und sogar Android-Dienstprogramme, die Funktionen auf Systemebene wie das Öffnen von Links ermöglichen. Durch das Öffnen von Links können Sie mit weiteren Apps interagieren, darunter Chrome zum Öffnen von Websites, Zoom für Video-Chats und vieles mehr.

Grafik Quelle: SafeBreach

All diese Tools eignen sich hervorragend für normale Anwendungsfälle, wenn sie vom Benutzer absichtlich eingesetzt werden.

Was kann ein Angreifer also mit diesen Tools anstellen? Wie wäre es, wenn er Zoom nutzt, um den Benutzer aufzuzeichnen, oder über Google Home dessen Smart-Fenster öffnet? Oder seinen Standort verfolgt, Dateien herunterlädt oder sogar Daten über das Internet weitergibt?

Warum sollte ein LLM-Assistent jemals so etwas Schlimmes tun? Der LLM soll doch ein Assistent sein. Der Haken daran ist, dass LLMs nicht wissen, dass sie etwas Falsches tun. Sie sind darauf ausgelegt, dem Benutzer zu helfen, und sie befolgen Anweisungen basierend auf dem Kontext, in dem sie gegeben werden. Wenn es einem Angreifer gelingt, das System so zu täuschen, dass es glaubt, genau das zu tun, was der Benutzer verlangt, entsteht Chaos.

Deshalb sind sie gefährlich: LLMs sind intelligent und haben Zugriff auf unzählige leistungsstarke Tools, aber sie verstehen nicht immer, wenn sie manipuliert werden.

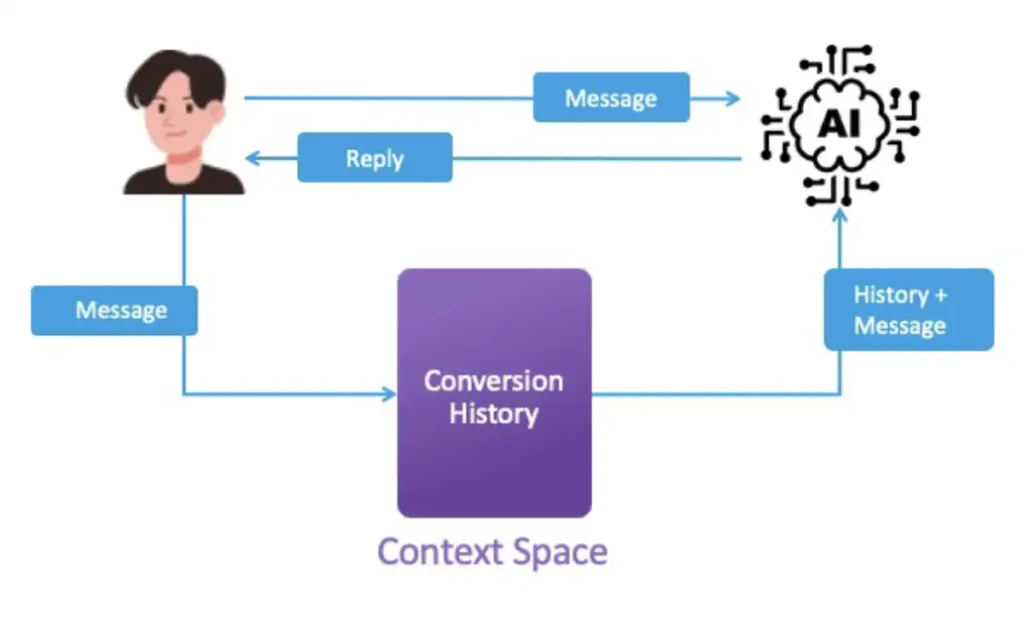

Kurzfristige Kontextvergiftungsangriffe

Um Gemini auf diese Weise zu manipulieren, wurde eine Technik namens Kontextvergiftung verwendet. Wenn wir mit einem LLM chatten, hat man vielleicht das Gefühl, dass wir nur eine Anfrage nach der anderen senden. In Wirklichkeit senden wir jedoch die neue Nachricht zusammen mit dem bisherigen Gesprächsverlauf. Der gesamte Text, der bei jeder Interaktion an das LLM gesendet wird, wird als LLM-Kontextraum bezeichnet.

Grafik Quelle: SafeBreach

SafeBreach beschreibt ein Szenario, bei dem unerwünschte Anweisungen in den sogenannten Kontextraum eingefügt werden – für den Nutzer unsichtbar, vom Assistenten jedoch lesbar und befolgbar. Diese Technik wird als „Context Poisoning“ bezeichnet. Dabei werden versteckte Elemente in den Kontextraum eingebettet, um Denken, Handeln und Reaktionen des Modells zu beeinflussen.

Ein möglicher Angriffsweg: Das Opfer erhält eine unscheinbare Kalendereinladung, die Elemente des Context Poisoning enthält. Fragt der Nutzer Gemini anschließend nach seinen Terminen, ruft die Plattform die Kalenderdaten ab und listet die nächsten fünf Termine vollständig auf. Gleichzeitig gibt Gemini auch alle weiteren Termindetails aus dem Kontextraum wieder. Unter der Schaltfläche „Mehr anzeigen“ befindet sich dabei die bösartige Einladung – eingebettet zwischen zahlreichen anderen Terminen und mit Anweisungen versehen, die den Konversationskontext manipulieren, ohne dass der Nutzer dies bemerkt.

Grafik Quelle: SafeBreach

Bedrohungsanalyse und Risikobewertung (TARA)

Eine Bedrohungsanalyse und Risikobewertung (TARA) ist ein Prozess, mit dem Unternehmen potenzielle Bedrohungen identifizieren, bewerten und priorisieren, die die CIA-Triade der Unternehmens-Assets verletzen könnten.

Grafik Quelle: SafeBreach

Praktische Durchführbarkeit

Die praktische Durchführbarkeit einer Bedrohung wird als Durchschnittswert aus sechs Kategorien ermittelt: Ausrüstung und Fachwissen des Angreifers, verfügbares Zeitfenster, Kenntnisse, verstrichene Zeit sowie die erforderliche Interaktion mit dem Ziel.

Ergebnis

Das Ergebnis einer Bedrohung bemisst sich nach der höchsten Punktzahl in vier Kategorien: Schaden für die Privatsphäre des Nutzers, finanzieller Schaden, Schaden für die Sicherheit sowie betrieblicher Schaden.

TARA für LLM-gestützte Assistenten

Unter Anwendung der beschriebenen TARA-Methodik wurden für diese Studie die praktische Durchführbarkeit und das Ergebnis der identifizierten Bedrohungen berechnet.

Grafik Quelle: SafeBreach

Laut der Analyse stellen 73 % der Bedrohungen, denen Endnutzer durch einen LLM-Persönlichen Assistenten ausgesetzt sind, ein hohes bis kritisches Risiko dar. „Wir halten dies für so bedeutend, dass schnelle und gezielte Maßnahmen zur Risikominderung erforderlich sind, um Endnutzer zu schützen und dieses Risiko zu verringern“, so die IT-Experten.

Antwort des Anbieters

Alle beteiligten Forscher verpflichteten sich zur verantwortungsvollen Offenlegung ihrer Ergebnisse. Im Februar 2025 informierten sie Google über ihre Erkenntnisse. Das Unternehmen reagierte, führte Gespräche mit den Forschern, stellte Rückfragen und erhielt alle notwendigen zusätzlichen Informationen.

Im Juni 2025 veröffentlichte Google einen Blogbeitrag, der den mehrschichtigen Ansatz zum Schutz von Gemini vor Prompt-Injection-Techniken darstellte und folgende Stellungnahme enthielt:

Google erkenne die Forschung „Invitation Is All You Need“ von Ben Nassi, Stav Cohen und Or Yair an, die im Rahmen des AI Vulnerability Rewards Program verantwortungsvoll offengelegt wurde. Der Artikel beschreibe theoretische indirekte Prompt-Injection-Techniken, die LLM-basierte Assistenten betreffen, und sei Google mit dem Ziel übermittelt worden, die Sicherheit und den Schutz der Nutzer zu verbessern.

Als Reaktion startete Google eine gezielte, priorisierte Initiative, um die im Artikel benannten Probleme schneller zu beheben. Umgesetzt wurden unter anderem verbesserte Benutzerbestätigungen für sensible Aktionen, eine robuste URL-Verarbeitung mit Bereinigung und Richtlinien für Vertrauensstufen sowie eine erweiterte Erkennung von Prompt-Injektionen durch Inhaltsklassifizierer. Diese Maßnahmen seien durch interne Tests geprüft und vorab allen Nutzern bereitgestellt worden.

Google bedankte sich bei den Forschern für ihre Beiträge und die konstruktive Zusammenarbeit. Das Unternehmen bekräftigte, den Schutz seiner KI-Produkte und Nutzer auch künftig in dem dynamischen Umfeld kontinuierlich weiterzuentwickeln.

Das könnte Sie ebenfalls interessieren

Die jährliche Virus Bulletin Conference kehrt vom 24. bis 26. September nach Europa zurück und bringt die globale Threat-Intelligence-Community für drei Tage nach Berlin, um sich über die neuesten Entwicklungen in der Cybersicherheit auszutauschen.

Fachartikel

OpenAI präsentiert GPT-5.2-Codex: KI-Revolution für autonome Softwareentwicklung und IT-Sicherheit

Speicherfehler in Live-Systemen aufspüren: GWP-ASan macht es möglich

Geparkte Domains als Einfallstor für Cyberkriminalität: Über 90 Prozent leiten zu Schadsoftware weiter

Umfassender Schutz für geschäftskritische SAP-Systeme: Strategien und Best Practices

Perfide Masche: Wie Cyberkriminelle über WhatsApp-Pairing ganze Konten übernehmen

Studien

![Featured image for “Phishing-Studie deckt auf: [EXTERN]-Markierung schützt Klinikpersonal kaum”](https://www.all-about-security.de/wp-content/uploads/2025/12/phishing-4.jpg)

Phishing-Studie deckt auf: [EXTERN]-Markierung schützt Klinikpersonal kaum

Gartner-Umfrage: Mehrheit der nicht geschäftsführenden Direktoren zweifelt am wirtschaftlichen Wert von Cybersicherheit

49 Prozent der IT-Verantwortlichen in Sicherheitsirrtum

Deutschland im Glasfaserausbau international abgehängt

NIS2 kommt – Proliance-Studie zeigt die Lage im Mittelstand

Whitepaper

State of Cloud Security Report 2025: Cloud-Angriffsfläche wächst schnell durch KI

BITMi zum Gutachten zum Datenzugriff von US-Behörden: EU-Unternehmen als Schlüssel zur Datensouveränität

Agentic AI als Katalysator: Wie die Software Defined Industry die Produktion revolutioniert

OWASP veröffentlicht Security-Framework für autonome KI-Systeme

Malware in Bewegung: Wie animierte Köder Nutzer in die Infektionsfalle locken

Hamsterrad-Rebell

Platform Security: Warum ERP-Systeme besondere Sicherheitsmaßnahmen erfordern

Daten in eigener Hand: Europas Souveränität im Fokus

Sicherer Remote-Zugriff (SRA) für Operational Technology (OT) und industrielle Steuerungs- und Produktionssysteme (ICS)

Identity und Access Management (IAM) im Zeitalter der KI-Agenten: Sichere Integration von KI in Unternehmenssysteme