Um die Datensicherheit ist es zunehmend schlechter gestellt, zumindest gemessen an der Zahl der Cyberangriffe und den dadurch entstandenen Schäden. Trotz einer zunehmenden Sensibilisierung in den Unternehmen und steigender Ausgaben rund um die Datensicherheit nimmt das Problem zu.

Unternehmen sind auf der Suche nach besseren Lösungen, aber angesichts breit angelegter Datenintegrationsprojekte gilt es, das große Ganze im Blick zu behalten. Denn um Datensicherheit zu gewährleisten, ist es nicht nur wichtig, auf taktische Details wie Vorfallmuster, Angriffsvektoren oder dynamische Tests einzugehen. Auch allgemeinere strategische Fragen und Überlegungen müssen in puncto Datensicherheit berücksichtigt werden.

Sicherheitsrisiken entstehen vor allem durch die herkömmliche Datenintegration mit relationalen Datenbanken. Gerade dort, wo eine Vielzahl von Datensilos missionskritische Daten beinhalten, ist das Problem allgegenwärtig. Organisationen, die keinen umfassenden Ansatz zur Datensicherheit nutzen und sich nur auf taktische Details oder die Perimetersicherheit konzentrieren, setzen sich einem enormen Cyberrisiko aus.

Der herkömmliche Ansatz

Der traditionelle Ansatz für die Datenintegration mit relationalen Datenbanken und ETL führt zu Datenverlusten und Governance-Problemen. Rollen- und richtlinienbasierte Zugriffskontrollen sind unerlässlich, um Daten und die damit verbundenen Zugriffsrechte zu verwalten, zu bewahren und zu überprüfen. Wenn diese Kontrollen nicht verwaltet werden, entsteht unnötige Komplexität und zusätzliches Risiko.

Leider gibt es in den meisten Organisationen nach wie vor viele verschiedene relationale Datenbank-Silos. Jeder besitzt unterschiedliche Zugriffskontrollen, die es praktisch unmöglich machen, die Gesamtheit der Daten adäquat zu verfolgen und zu schützen.

Darüber hinaus gibt es mehrere ETL-Tools mit verschleiertem Code und entsprechenden Integrationspunkten, ganz zu schweigen von eigenen Zugriffskontrollen, die zusätzlich verwaltet werden müssen. Mit einer wachsenden Zahl von Datensilos steigt auch die Anzahl der Schwachstellen, die ausgenutzt werden können.

Oft werden eine Vielzahl von ausschließlich relationalen Datenbanken mithilfe eines eigens dafür erstellten, komplizierten ETL-Prozesses mit einem zentralen Analytical Data Warehouse verbunden.

Dabei wird ein ETL-Prozess aus zwei Gründen eingesetzt: zum einen, um das System funktionsfähig zu machen, zum anderen, um die Daten zu bereinigen, weil es einen Geschäftsprozess gibt, für den eine Standardisierung erforderlich ist (z.B. damit Zählungen oder Berechnungen durchgeführt oder Daten unterschieden werden können).

Allerdings werden bei der Datenbereinigung oft nicht die gewünschten Ergebnisse erzielt, denn häufig wird dabei die Datenqualität beeinträchtigt, da wichtige Informationen verloren gehen.

Wie wichtig die Qualität der Daten für ein effizientes Datenmanagement ist, zeigt auch die BARC-Studie „How to rule your data world“. Immerhin 48 % der Befragten bemängeln die Qualität der Daten und 58% sehen einen hohen Bedarf an Tools für die Datenbereinigung in ihrem Unternehmen.

Einem Datenanalysten mögen einige der Metadaten wie „Daten-Flusen“ vorkommen, die entfernt werden müssen, für einen Compliance-Analysten oder Daten-Modellierer hingegen, können diese „Flusen“ aber aus wichtigen geschäftlichen Gründen zwingend erforderlich sein (z. B. um einer Aufsichtsbehörde zu beweisen, dass Geschäfte legal waren).

Rechnungsprüfern z.B. ist es egal, ob die Daten „schmutzig“ sind. Sie werden eher misstrauisch, wenn sie merken, dass Daten bereinigt werden.

So hat jede Rolle im Unternehmen ihre eigenen Gründe, Daten zu behalten oder zu entfernen. Die Datenbank allerdings liefert schließlich allen den Schlüssel für die strategische Datenintegration. Im Laufe der Zeit wird es dann zunehmend schwieriger, die Data Governance (in Bezug auf Qualität, Abstammung und Herkunft, Sicherheit und Datenschutz, Compliance-Anforderungen, Verfügbarkeit) zu gewährleisten. Im Umkehrschluss bedeutet das: Es muss jeder Teilaspekt der Data Governance über den gesamten Lebenszyklus der Daten berücksichtigt werden, um zusätzliche Cyber-Risiken auszuschließen.

Aktionsplan Risikominderung

Wie also lassen sich die Risiken während des Datenintegrationsprozesses verringern? Zunächst muss der Aufwand für herkömmliche ETL-Prozesse reduziert werden, indem die Quelldaten im Ist-Zustand importiert und dann innerhalb eines Data Hubs umgewandelt und harmonisiert werden. Auf diese Weise lässt sich der gesamte Integrationsvorgang schneller und einfacher gestalten, zudem werden dabei keinerlei Daten ausgesondert.

Langfristig jedoch ist der Multi-Modell-Ansatz auf Basis von Dokumenten und Tripeln besser geeignet, um Data Governance zu garantieren. Data Hubs, die auf der Basis moderner Datenbank Technologie betrieben werden, bieten die Möglichkeit, abstrakte Geschäftskonzepte aus einer Vielzahl von Datensilos zu verwalten und diese als Entitäten mitsamt den bestehenden Beziehungen darzustellen. Daten und Metadaten bleiben miteinander verbunden, wobei sich die zugehörigen Details über den gesamten Lebenszyklus hinweg nachverfolgen lassen: mitsamt der Herkunft der Daten, den Zugriffsrechten und den vorgenommenen Änderungen — alles in einem einzigen System.

Fazit: Der entscheidende Vorteil eines cloud-unabhängigen Data Hubs ist die Tatsache, dass große Mengen an Daten im Ist-Zustand geladen werden, Profile erstellt werden und herausgefunden werden kann, welche Daten qualitativ minderwertig sind, um sie dann vom Administrator „reparieren“ zu lassen. Das ist ein zentraler Aspekt der Data Governance, der auf diese Weise gelöst werden kann.

Für die Gewährleistung der Datensicherheit, ist die NoSQL Datenbank Technologie auch deshalb eine gute Wahl, weil sie die Chancen für Exploits deutlich reduziert und eine agilere Plattform für die Handhabung neuer oder geänderter Vorschriften bietet.

Autor: Dr. Stefan Grotehans, Director Sales Engineering DACH bei MarkLogic

Fachartikel

Strategien für eine fortgeschrittene digitale Hygiene

Mit LogRhythm 7.16 können Sie das Dashboard-Rauschen reduzieren und Log-Quellen leicht zurückziehen

Wie man RMM-Software mit einer Firewall absichert

Red Sifts vierteljährliche Produktveröffentlichung vom Frühjahr 2024

Konvergiert vs. Einheitlich: Was ist der Unterschied?

Studien

Studie zu PKI und Post-Quanten-Kryptographie verdeutlicht wachsenden Bedarf an digitalem Vertrauen bei DACH-Organisationen

Zunahme von „Evasive Malware“ verstärkt Bedrohungswelle

Neuer Report bestätigt: Die Zukunft KI-gestützter Content Creation ist längst Gegenwart

Neue Erkenntnisse: Trend-Report zu Bankbetrug und Finanzdelikten in Europa veröffentlicht

Studie: Rasantes API-Wachstum schafft Cybersicherheitsrisiken für Unternehmen

Whitepaper

Unter4Ohren

Datenklassifizierung: Sicherheit, Konformität und Kontrolle

Die Rolle der KI in der IT-Sicherheit

CrowdStrike Global Threat Report 2024 – Einblicke in die aktuelle Bedrohungslandschaft

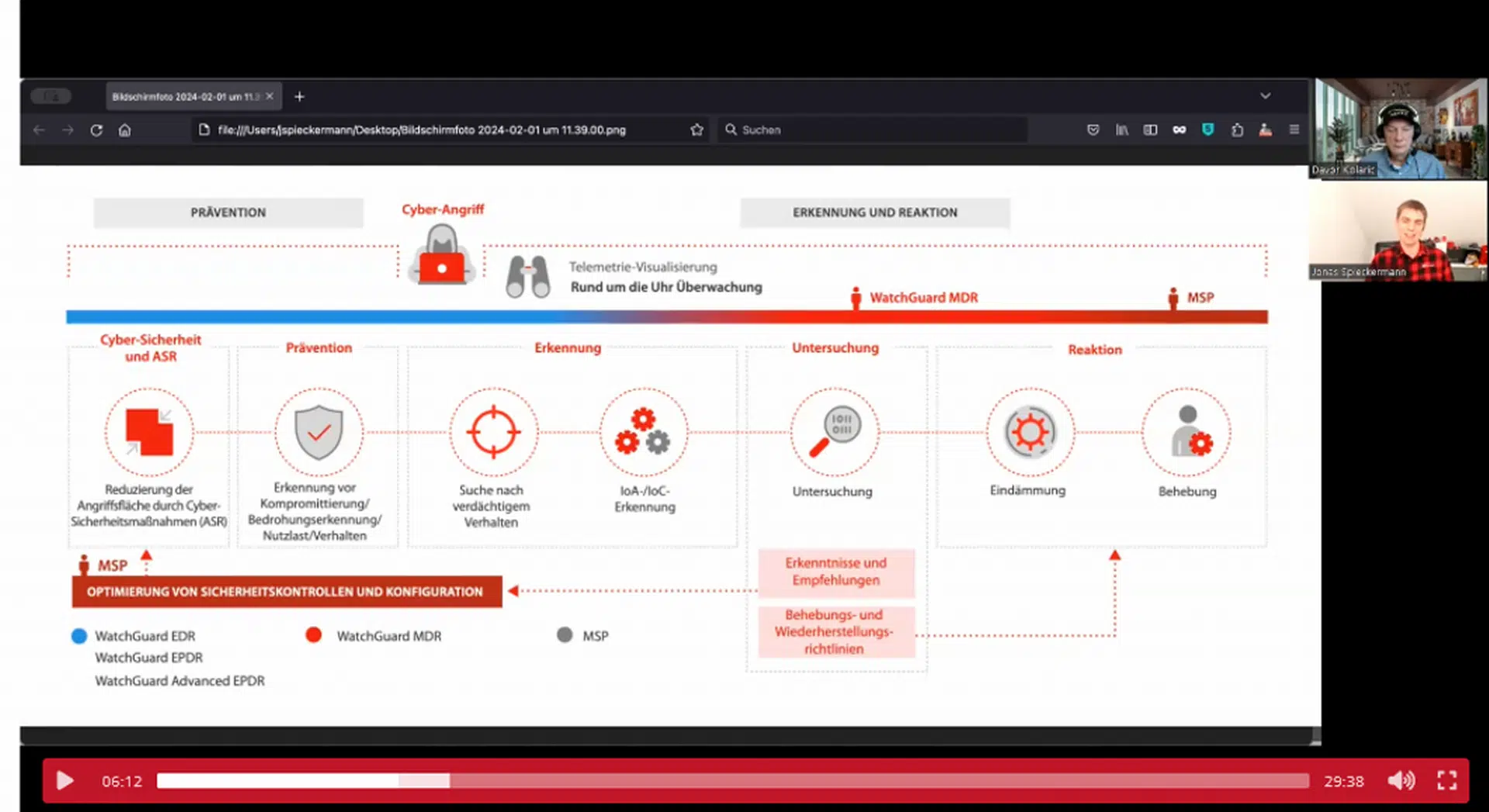

WatchGuard Managed Detection & Response – Erkennung und Reaktion rund um die Uhr ohne Mehraufwand