IT-Sicherheitsexperten mahnen vor Massenüberwachung durch Echtzeit-Scans

Die EU-Kommission stellte vor Kurzem ihre Pläne für ein neues Gesetz zur Chatkontrolle vor. Ziel ist es, den Kampf gegen sexuellen Missbrauch Minderjähriger voranzutreiben. „Das ist zweifelsfrei dringend notwendig. Doch erreicht werden soll dies, indem die Privatsphäre unter anderem auf unser aller Mobiltelefone ausgehebelt wird. Ob jedoch die anlasslose Massenüberwachung auch unbescholtener Bürgerinnen und Bürger die Strafverfolgung in dieser Hinsicht wirklich weiterbringt, bezweifle ich stark“, kritisiert IT-Sicherheitsexpertin Patrycja Schrenk, Geschäftsführerin der PSW GROUP www.psw-group.de scharf.

Es sind erschreckende Zahlen, von denen die EU-Kommission berichtet: Allein im Jahr 2021 gab es 85 Millionen Meldungen von Bildern und Videos, die sexuellen Kindesmissbrauch darstellen – die Dunkelziffer liegt weitaus höher. Um Kindesmissbrauch mit neuen Methoden verfolgen zu können, präsentierte die EU-Kommission nun einen Gesetzesvorschlag zum Schutz von Kindern: Mit der Chatkontrolle – also dem Durchleuchten von Online-Kommunikation in Messengern, sozialen Netzwerken oder auch per E-Mail – möchte die EU Algorithmen einführen, die erkennen können, ob und wann Material zu Kindesmissbrauch online geteilt wird.

Technische Lösungen und ihre datenschutzrechtlichen Nachteile

Um dies zu erreichen, könnte Künstliche Intelligenz (KI) zum Einsatz kommen: Der Algorithmus erkennt bereits bekanntes Material anhand eines Hashwerts, also eines einzigartigen Werts, der den Datei-Inhalt beschreibt. Ist den Algorithmen – und damit auch den Behörden – ein Bild bekannt, auf dem Kindesmissbrauch dargestellt wird, können alle Bilder damit abgeglichen werden. Um bisher nicht bekanntes Material erkennen zu können, sollen die Algorithmen mittels Machine Learning, also maschinellem Lernen, dazulernen können. Allerdings: „Das anlasslose Scannen von Kommunikationen im Internet ist ein großer Eingriff in die Privatsphäre“, mahnt die IT-Sicherheitsexpertin.

Welche technischen Lösungen eingesetzt werden sollen, ließ die EU-Kommission zudem offen. Aktuell sind zwei Verfahren im Gespräch. So sollen entweder Anbieter Nachrichten vor dem Verschlüsseln durchleuchten, wobei möglicherweise Nachrichten dann unverschlüsselt ausgeleitet werden. „Dieses „client-side scanning“, kurz CSS, ist gefährlich für die IT-Sicherheit: Staatliche Stellen erhalten Zugang zu privaten Inhalten, sodass es sich um Abhöraktionen handelt. Viele Nutzergeräte weisen zudem Schwachstellen auf, die durch die Überwachungs- und Kontrollmöglichkeiten des CSS von weiteren Akteuren ausgenutzt werden können. CSS schwächt aber auch die Meinungsfreiheit und Demokratie: Einmal eingeführt, wird es schwer, sich gegen etwaige Ausweitungen zur Wehr zu setzen oder Kontrolle über den Missbrauch des Systems zu erhalten“, warnt Patrycja Schrenk.

Ein zweites Verfahren wäre die Aushebelung der Verschlüsselung durch die Messengerdienste selbst. Hierzu möchte die EU Anbieter zu einer Hintertür im Messenger verpflichten, sodass über diese auf die Inhalte des Smartphones zugegriffen werden kann. Davon betroffen sind Hostprovider, einschließlich Foto- und Videoplattformen, Zugangsprovider, App Store-Betreiber sowie interpersonelle Kommunikationsdienste wie Messenger und E-Mail. Diesen Diensten soll vorgeschrieben werden, Chats, Nachrichten sowie E-Mails mittels Künstlicher Intelligenz (KI) nach verdächtigen Inhalten zu durchleuchten. Wurden verdächtige Inhalte erkannt, sollen diese an Strafverfolgungsbehörden weitergeleitet werden, die dann ihrerseits prüfen, ob sich der Anfangsverdacht bestätigt hat.

„Problematisch bei den aktuell vorhandenen Technologien ist mitunter die hohe Fehlerquote: Auch irrtümliche Treffer müssen an die Strafverfolgungsbehörden gesendet werden, sodass harmlose Nachrichten, Chats, Videos oder Fotos von Unschuldigen gesichtet und unnötig verbreitet werden. Heißt für die Praxis: Menschen, die im geplanten EU-Zentrum arbeiten, müssen falsch-positives Material händisch aussortieren. Damit bekommen Ermittelnde auch legale Aufnahmen Minderjähriger zu sehen“, so Patrycja Schrenk. Falsch-positive Ergebnisse entstehen, weil die scannende KI den Kontext nicht versteht: Verbringt eine Familie den Sommer am Strand und schickt einander die entstandenen Fotos zu, landen diese unter Umständen in der EU-Zentrale und bei Europol. Privatsphäre sieht anders aus. Was folgt, könnte eine nie da gewesene Massenüberwachung aller Bürgerinnen und Bürger sein – anlasslos und vollautomatisiert. Damit würde das Recht auf Verschlüsselung ausgehebelt und das digitale Briefgeheimnis abgeschafft werden.

„Wir dürfen uns auch nichts vormachen: Maschinell nach Grooming-Versuchen oder derzeit unbekannten Missbrauchsdarstellungen suchen zu wollen, ist rein experimentell – auch, beziehungsweise gerade, unter Verwendung von KI. Denn die Algorithmen, die dabei eingesetzt werden, sind weder der Öffentlichkeit noch der Wissenschaft zugänglich. Und eine Offenlegungspflicht ist in dem Gesetzentwurf nicht zu finden. Kommunikationsdienste, die für Grooming-Versuche missbraucht werden könnten – und darunter fallen alle Kommunikationsdienste – müssen Altersverifikationen mit Nutzerinnen und Nutzern durchführen. Das geht nur, wenn diese sich ausweisen. Damit wird die anonyme Kommunikation de facto unmöglich gemacht, was gerade Menschenrechtler, Whistleblower, politisch Verfolgte, Journalisten oder marginalisierte Gruppen bedrohen könnte“, kritisiert Schrenk scharf.

„Ich habe aber nichts zu verbergen“: Falsch!

Damit ist aus Datenschutzsicht der Entwurf zum Chatkontrolle-Gesetz katastrophal, denn Jede und Jeder steht unter Generalverdacht! „Wer glaubt, er oder sie hätte nichts zu verbergen, sollte darüber nachdenken, dass im Falle einer Chatkontrolle alle E-Mails und Chats automatisch auf verdächtige Inhalte durchsucht werden. Es existiert dann keine vertrauliche und geheime Kommunikation mehr. Gerichte müssen derlei Durchsuchungen nicht mehr anordnen, sie geschehen automatisiert“, mahnt Patrycja Schrenk und nennt die weitreichenden Konsequenzen: „Harmlose Familienfotos vom Strandurlaub werden höchstwahrscheinlich falsch-positiv anschlagen und von internationalen Ermittelnden angesehen. Ein Urlaubsfoto, das vom Sprössling am Strand an die Oma versendet wird, macht diese schon verdächtig.“

Kommt die Chatkontrolle könnten außerdem weitere staatliche Akteure wie Geheimdienste oder auch Cyberkriminelle auf privaten Chats und E-Mails zugreifen. „Etabliert sich die Technologie zur Chatkontrolle, ist es einfach, sie auch für andere Zwecke einzusetzen. Die erzwungene Hintertür ermöglicht nämlich das Überwachen bislang sicher verschlüsselter Kommunikationen auch für andere Zwecke. Den Algorithmen ist es egal, ob sie nach Kindesmissbrauch, Drogenkonsum oder nach unliebsamen Meinungsäußerungen suchen. In einigen Staaten der EU ist es beispielsweise nicht normal, zur LGTPQ+ Bewegung zu gehören. Tatsächlich verwenden autoritäre Staaten derlei Filter zur Verfolgung und Verhaftung von Andersdenkenden“, gibt Schrenk zu bedenken.

Schlimmstenfalls schadet die Chatkontrolle sogar bei der Verfolgung von Kindesmissbrauch, denn Ermittelnde sind mit Meldungen überlastet, die oftmals strafrechtlich irrelevant sind. Überdies werden Missbrauchstäter nicht getroffen: Schon jetzt nutzen sie in aller Regel keine kommerziellen Online-Dienste, sondern richten eigene Foren ein. Dort laden sie Bild- und Videomaterial häufig als verschlüsseltes Archiv hoch und teilen nur Links und Passwörter. Die Algorithmen der Chatkontrolle funktionieren hier nicht. „Sorgen bereitet mir zudem, dass die Strafverfolgung privatisiert würde. Denn dann entscheiden Algorithmen großer Tech-Giganten, welche Inhalte als verdächtig gelten“, so Schrenk.

Weitere Informationen unter: https://www.psw-consulting.de/blog/2022/07/25/pandoras-buechse-oder-die-chatkontrolle-massenueberwachung-durch-echtzeit-scans/

Fachartikel

Strategien für eine fortgeschrittene digitale Hygiene

Mit LogRhythm 7.16 können Sie das Dashboard-Rauschen reduzieren und Log-Quellen leicht zurückziehen

Wie man RMM-Software mit einer Firewall absichert

Red Sifts vierteljährliche Produktveröffentlichung vom Frühjahr 2024

Konvergiert vs. Einheitlich: Was ist der Unterschied?

Studien

Studie zu PKI und Post-Quanten-Kryptographie verdeutlicht wachsenden Bedarf an digitalem Vertrauen bei DACH-Organisationen

Zunahme von „Evasive Malware“ verstärkt Bedrohungswelle

Neuer Report bestätigt: Die Zukunft KI-gestützter Content Creation ist längst Gegenwart

Neue Erkenntnisse: Trend-Report zu Bankbetrug und Finanzdelikten in Europa veröffentlicht

Studie: Rasantes API-Wachstum schafft Cybersicherheitsrisiken für Unternehmen

Whitepaper

Unter4Ohren

Datenklassifizierung: Sicherheit, Konformität und Kontrolle

Die Rolle der KI in der IT-Sicherheit

CrowdStrike Global Threat Report 2024 – Einblicke in die aktuelle Bedrohungslandschaft

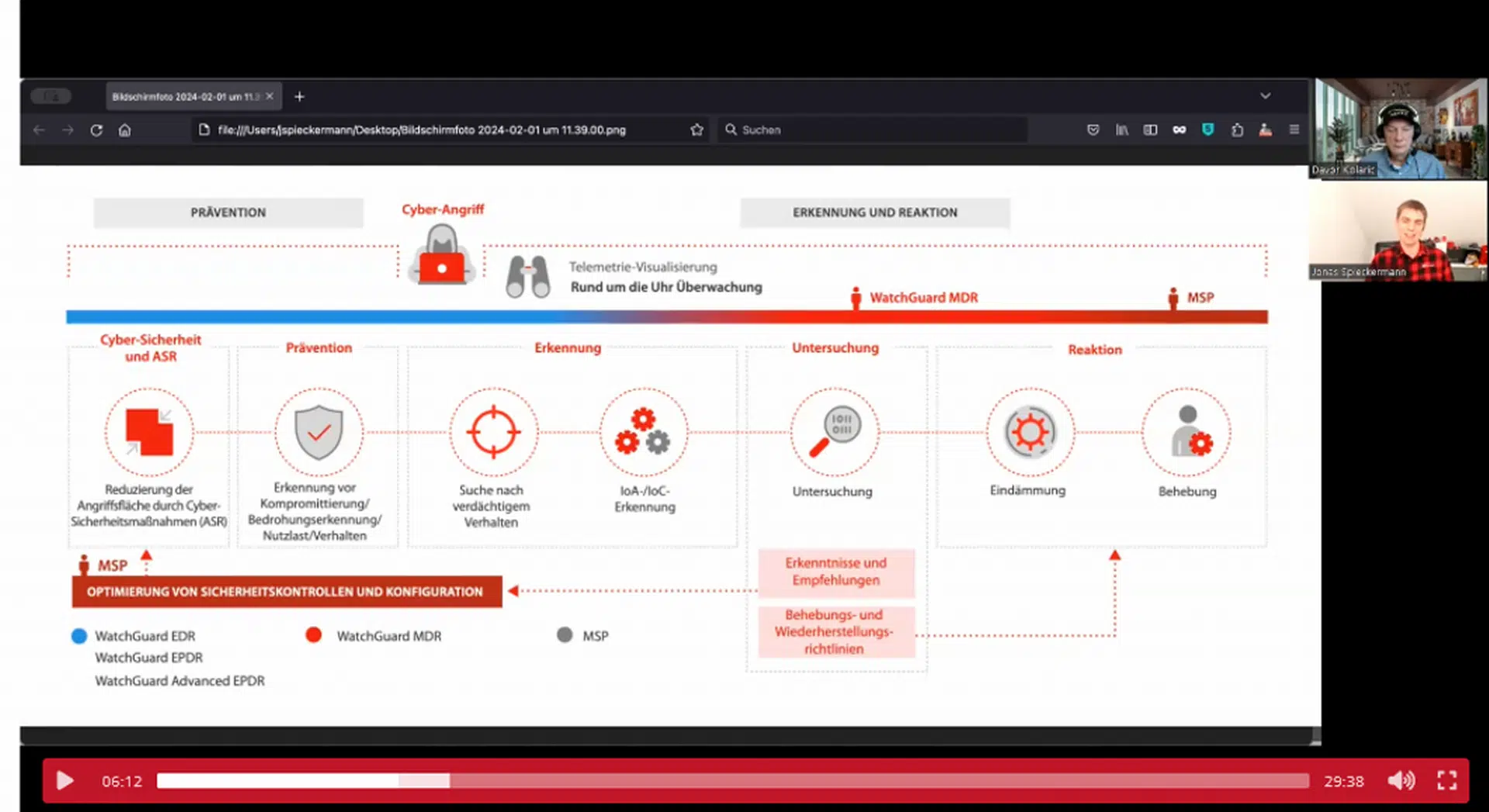

WatchGuard Managed Detection & Response – Erkennung und Reaktion rund um die Uhr ohne Mehraufwand