Professor der City University of London untersucht einige Nachteile der künstlichen Intelligenz.

Wir sehen große Aufregung und Besorgnis in Bezug um ChatGPT – Teil der neuesten Entwicklung bei künstlichen neuronalen Netzen, die große Sprachmodelle (LLM) lernen.

Während einige Forscher behaupten, dass sie keine Bedenken hinsichtlich ChatGPT haben, werden die meisten zustimmen, dass die neuesten LLMs und der sogenannte AIGC (Artificial Intelligence Generated Content) von großem Nutzen sind.

Von Produktivitätssteigerungen über Sprachübersetzung in Echtzeit bis hin zu besseren Möglichkeiten der Internetsuche und der Interaktion mit Computersystemen sind die Möglichkeiten enorm.

Diejenigen, die sich besorgt über die Technologie äußern, weisen auf zwei Hauptprobleme hin, von denen eines eher philosophischer Natur ist und das andere unmittelbare praktische Auswirkungen auf das tägliche Leben hat.

Wie Noam Chomsky während der KI-Debatte 3 im Dezember 2022 betonte, kann ChatGPT unmöglich etwas darüber aussagen, wie Sprache im menschlichen Geist funktioniert. Das liegt unter anderem daran, dass ChatGPT eine Blackbox ist.

Auf dem Forschungsgebiet, das als neurosymbolische KI bekannt ist, wird an der „Öffnung der Blackbox“ geforscht, um großen neuronalen Netzen einen Sinn zu geben, insbesondere was Konzeptlernen, Kompositionalität und Argumentation betrifft. Ich bin seit mehreren Jahren Mitorganisator des jährlichen internationalen Workshops über neuronal-symbolisches Lernen und Reasoning (bekannt als NeSY-Workshop) – der am längsten bestehenden Veranstaltung zur Präsentation und Diskussion von Spitzenforschungsergebnissen in der Neural-Symbolic Learning and Reasoning Association.

Von unmittelbarer Bedeutung: ChatGPT macht Fehler.

Es macht sowohl dumme als auch schwerwiegende Fehler auf eine Art und Weise, die solche Fehler verschleiert, weil es von allgemeinen Gesprächsmustern ausgeht.

Während die Menschen gelernt haben, Informationen auf Websites, in sozialen Medien und E-Mails aufgrund verschiedener Hinweise wie Quelle, visuellem Erscheinungsbild und grammatikalischen Fehlern zu vertrauen, schafft ChatGPT eine völlig neue Schwierigkeitsstufe, wenn es um diese Beurteilung geht.

Die unmittelbarste Besorgnis praktischer Hinsicht ist daher das Risiko einer groß angelegten Desinformationsverbreitung und deren Auswirkungen, insbesondere auf junge Demokratien.

Neurosymbolische KI kann dazu beitragen, die Desinformationsrisiken zu mindern, indem sie die Blackbox öffnet und Überlegungen über das Gelernte zulässt.

In der Zwischenzeit müssen Fachexperten zu KI-Experten werden.

Professor Artur d’Avila Garcez, Direktor des Forschungszentrums für maschinelles Lernen der City University of London

Fachartikel

Strategien für eine fortgeschrittene digitale Hygiene

Mit LogRhythm 7.16 können Sie das Dashboard-Rauschen reduzieren und Log-Quellen leicht zurückziehen

Wie man RMM-Software mit einer Firewall absichert

Red Sifts vierteljährliche Produktveröffentlichung vom Frühjahr 2024

Konvergiert vs. Einheitlich: Was ist der Unterschied?

Studien

Studie zu PKI und Post-Quanten-Kryptographie verdeutlicht wachsenden Bedarf an digitalem Vertrauen bei DACH-Organisationen

Zunahme von „Evasive Malware“ verstärkt Bedrohungswelle

Neuer Report bestätigt: Die Zukunft KI-gestützter Content Creation ist längst Gegenwart

Neue Erkenntnisse: Trend-Report zu Bankbetrug und Finanzdelikten in Europa veröffentlicht

Studie: Rasantes API-Wachstum schafft Cybersicherheitsrisiken für Unternehmen

Whitepaper

Unter4Ohren

Datenklassifizierung: Sicherheit, Konformität und Kontrolle

Die Rolle der KI in der IT-Sicherheit

CrowdStrike Global Threat Report 2024 – Einblicke in die aktuelle Bedrohungslandschaft

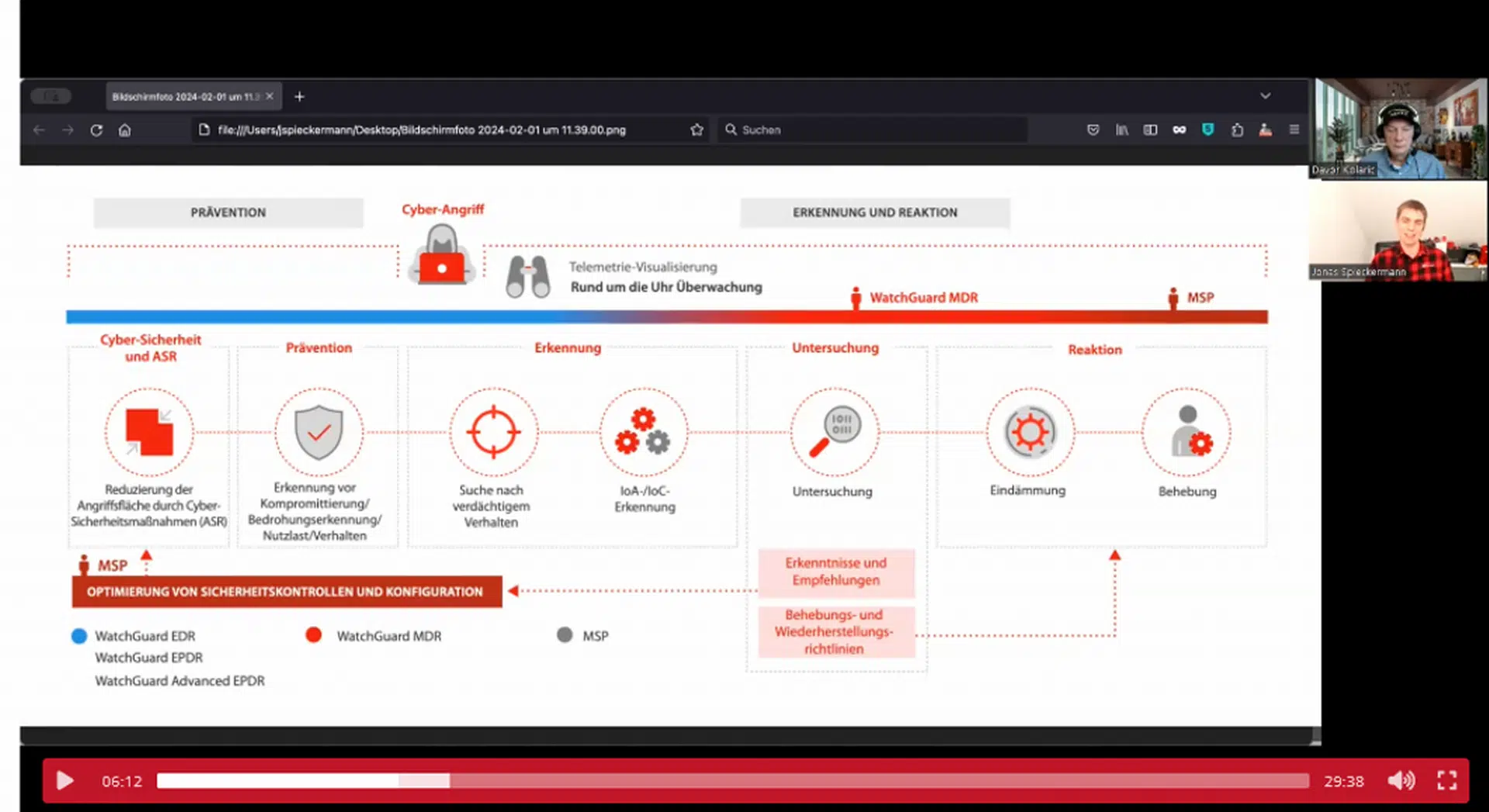

WatchGuard Managed Detection & Response – Erkennung und Reaktion rund um die Uhr ohne Mehraufwand